La historia de la tecnología nos muestra que la revolución industrial

del siglo XIX fue una revolución en la mecánica que sirvió para

automatizar el trabajo físico. Los actuales cambios que propicia la

nanotecnología, los voy a enmarcar en una revolución existencial, porque

nos afectan directamente como seres

https://www.bbvaopenmind.com/articulos/el-espiritu-en-la-maquina-la-nanotecnologia-la-complejidad-y-nosotros/?fbclid=IwAR3bZHU6-aBmRmm_jRw08vSZ88-ZB6pLUPMcY_edHAGuOO2zD-9ylMhjB-Q

El espíritu en la máquina. La nanotecnología, la complejidad y nosotros

Escuchar audio

La influencia de la nanotecnología en nuestra vida diaria

se refleja en las herramientas de comunicación móvil, en los

diagnósticos y nuevos tratamientos médicos, en el uso de datos por las

empresas y los gobiernos y en la acumulación de los mismos en la nube.

La sociedad reacciona despacio a los cambios tecnológicos, que se

suceden con gran rapidez. La nanotecnología, con sus capacidades a

escala atómica a las que se producen gran parte de las dinámicas del

mundo natural y físico, tiene el potencial de hacer factibles avances

sin precedentes en la historia de la humanidad. Los cambios evolutivos

—la manipulación del mundo natural que se da, por ejemplo, en la

genética— y los cambios emergentes —la manipulación y la autonomía del

mundo físico que facilita, por ejemplo, la inteligencia artificial—

pueden ahora combinarse y desembocar en profundas transformaciones

existenciales. En el interior de las máquinas complejas que hemos creado

mora un espíritu, y la humanidad debe trabajar en cada fase del proceso

de construcción de las máquinas para asegurarse de que el espíritu sea

benévolo.

«Incluso algunos de sus materialistas compatriotas están preparados para aceptar, al menos como una hipótesis de trabajo, que alguna entidad ha… por así decirlo, invadido a HAL. Sasha ha encontrado una buena manera de expresarlo: “El espíritu que mora en la máquina”».

Arthur C. Clarke, 2010: Odisea Dos, 1982

«La doctrina oficial, que se remonta principalmente a Descartes, viene a decir lo siguiente: […] todos los seres humanos cuentan con un cuerpo y una mente. […] Algunos preferirían decir los seres humanos son un cuerpo y una mente, juntos. De ordinario, el cuerpo y la mente de cada uno están unidos, pero después de la muerte su mente podría seguir existiendo y funcionando. […] Lo expuesto es la teoría oficial. Me referiré a ella a menudo, en un tono deliberadamente denigratorio, como “el dogma del espíritu que mora en la máquina”. Espero demostrar que es totalmente falso; no solo en sus aspectos concretos, también por principio».

Gilbert Ryle, El concepto de lo mental, 1949

Hace seis años, en mi artículo anterior1 para

esta colección, analizamos las implicaciones de la capacidad de

observar y ejercer control a escala atómica y molecular; es decir, de la

nanotecnología. A modo de conclusión, planteábamos conjeturas y

numerosas preguntas acerca de la complejidad física y biológica que nos

descubrirá el futuro merced al desarrollo de esta tecnología. Nuestro

argumento era que la complejidad de la naturaleza surgía en

interacciones que tenían lugar a escala atómica: átomos que forman

moléculas; moléculas complejas que, a su vez, derivan en fábricas

moleculares, como las células responsables de la reproducción, y la

formación de sistemas jerárquicos polifacéticos. Las leyes de la física,

como la segunda ley de la termodinámica, siguen vigentes, de modo que

este desarrollo de la complejidad se produce a lo largo de periodos

prolongados y en sistemas de elevada eficiencia energética. El uso del

control nanotecnológico a escala atómica (la escala de la naturaleza) ha

comportado mejoras continuadas en la eficiencia de los sistemas físicos

y la extensión de su uso a la biología y otros campos. Esta capacidad

de tomar el control de la naturaleza mediante la tecnología física

otorga al ser humano la facultad de intervenir benéficamente, pero

también plantea preguntas existenciales sobre el humano y la máquina.

Había ejemplos ilustrativos, como las denominadas máquinas emergentes ,

autómatas capaces de autorreproducirse, cuyo software y hardware se

habían fusionado para formar sistemas vivos; o las máquinas evolutivas,

cuya optimización mediante ingeniería modificaba el constructo

evolutivo. En la actualidad las máquinas computacionales existen como

variedad emergente, al mejorarse a sí mismas a medida que observan y

manipulan más datos, modifican sus ajustes cambiando el modo de usar el

hardware y realizan copias de sí mismas mediante la partición usando

el hardware existente, aunque todavía no se están fabricando, a

excepción de la rudimentaria impresión en 3D. Hoy día son numerosos los

productos químicos y los medicamentos producidos a través de células y

enzimas que hacen las veces de factorías biológicas.

Desde aquel artículo de 2012, las preguntas existenciales que

planteábamos a modo de conclusión no han hecho sino consolidarse. El

rápido desarrollo de las CRISPR (repeticiones palindrómicas cortas

agrupadas y regularmente interespaciadas) y la veloz evolución del

aprendizaje automatizado hacia la inteligencia artificial (IA)2 nos

han conducido a una difícil encrucijada. El presente capítulo, una

reflexión científica y filosófica, pone de relieve las lecciones que nos

han brindado estos años a fin de subrayar la rápida progresión

realizada para, acto seguido, centrarse en las implicaciones futuras que

ya se vislumbran. Analiza cómo los principios de la física han influido

en el progreso y la evolución de la nanotecnología, en qué ámbitos esta

ha tenido éxito y en cuáles no tanto, y por qué razones. Cuando

aparecen nuevas tecnologías que generan cambios a gran velocidad, las

instituciones de la sociedad, al igual que cada uno de sus individuos,

tardan en potenciar sus aspectos positivos y limitar los negativos

mediante unas restricciones (en el ámbito de la comunidad y del

individuo) que aseguren un equilibrio saludable. A modo de ejemplo,

cuando se inventó el ferrocarril moderno, los motores de vapor tendían a

explotar y los trenes tenían accidentes por la ausencia de sistemas de

señalización, pero la sociedad estableció mecanismos de seguridad.

Actualmente, los motores siguen explotando y sigue habiendo accidentes,

pero a una escala que la sociedad considera aceptable. Por otra parte,

todavía estamos trabajando en el control de los plásticos y aún no hemos

podido frenar el cambio climático, lo que ilustra lo mucho que tardan

en responder la sociedad y los individuos a los avances tecnológicos.

Con el mismo ánimo que en el ensayo anterior, el presente artículo

refleja la evolución de las capacidades que, gracias a la

nanotecnología, se atisban en un futuro inminente, así como las

cuestiones de gran calado sobre las cuales la sociedad debe empezar a

reflexionar y actuar.

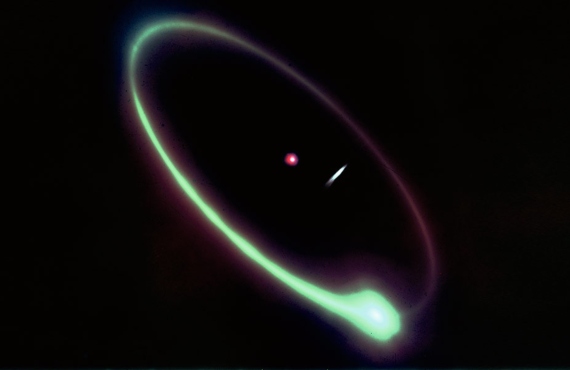

El uso del control nanotecnológico a escala atómica (la escala de la naturaleza) ha comportado mejoras continuadas en la eficiencia de los sistemas físicos y la extensión de su uso a la biología y otros campos, pero también plantea preguntas existenciales sobre el humano y la máquina

La última década ha sido testigo del empleo de la nanotecnología en

muchas aplicaciones pasivas de ámbito general. En tanto material basado

en la variedad de propiedades únicas al alcance de materiales

específicos gracias a fenómenos a pequeña escala, el elemento

nanotecnológico tiene un uso cada vez más generalizado en muchos

productos, aunque con un coste económico bastante elevado. Sus

aplicaciones van desde las relativamente sencillas hasta otras bastante

complejas. Por ejemplo, los revestimientos aportan robustez y una

resistencia elevada ante la corrosión y el desgaste y se aplican a los

implantes médicos (como los estents, las válvulas y los marcapasos,

entre otros). También se utilizan los revestimientos en superficies que

requieren más resistencia en entornos difíciles: desde

máquinas-herramienta hasta grandes superficies metálicas. Dado que el

pequeño tamaño de un material modifica las propiedades ópticas, esta

tecnología ha posibilitado aplicaciones que van desde usos generalizados

pero triviales, como las cremas solares, hasta otros mucho más

sofisticados, como las intervenciones por vía óptica en sistemas vivos y

físicos. Algunas mejoras mecánicas, como las debidas a los nanotubos,

se han integrado en el arsenal de compuestos de bajo peso. Por otra

parte, las posibilidades a nanoescala y su consiguiente uso en las

superficies han permitido mejoras en la filtración de virus y bacterias.

Asimismo, las baterías utilizan la porosidad y las propiedades

superficiales para mejorar las características de uso: la densidad

energética y la retención de la carga, entre otras; y la proliferación

de automóviles eléctricos y del almacenamiento de electricidad en

baterías promete una utilización a gran escala. La aplicación de

nanotecnología en superficies permite aprovechar la interacción a escala

molecular para la unión y la interacción. En este sentido, este

mecanismo posibilita una localización muy específica en el cuerpo, para

mejorar tanto la detección de problemas como la administración de

medicamentos. En concreto, la observación y eliminación de los

crecimientos cancerosos tiene una presencia cada vez mayor en el arsenal

médico. Esta misma propiedad superficial se utiliza en sensores capaces

de detectar sustancias químicas específicas en el medioambiente. Lo más

relevante del concepto de la máquina evolutiva es su capacidad

(desarrollada mediante ensayos aleatorizados a gran escala basados en la

reproducción de la naturaleza y efectuados sobre los dispositivos, algo

que se conoce como «laboratorio sobre un chip») de distinguir,

comprender y desarrollar una serie de remedios que se pueden administrar

localmente en casos en que los mecanismos biológicos hayan dejado de

funcionar. La investigación contra el cáncer, el verdadero rompecabezas a

que se enfrenta la medicina, se ha beneficiado mucho de la observación e

intervención propiciadas por las herramientas de la nanotecnología,

aunque se trata de un fenómeno muy complejo (el cáncer engloba un

conjunto de numerosas enfermedades diferentes) que está todavía muy

lejos de una solución, a excepción de algunas de sus manifestaciones. El

concepto de máquina evolutiva también ha quedado patente en los métodos

de producción de diversos compuestos, de simples a complejos, que se

han generalizado: desde la conversión del peróxido de hidrógeno en un

oxidante intenso mediante enzimas hasta la vacuna contra el virus del

Ébola producida con plantas de tabaco.

Lo más relevante del concepto de la máquina evolutiva es su capacidad de distinguir, comprender y desarrollar una serie de remedios que se pueden administrar localmente en casos en que los mecanismos biológicos hayan dejado de funcionar

Hay que reconocer que gran parte de este uso de la nanotecnología se

ha centrado en aplicaciones cuyo coste es una preocupación secundaria y

las propiedades específicas son lo bastante atractivas para hacer

deseable el producto. Se nos plantea, pues, un obstáculo: el coste de

fabricación sigue siendo un problema. Otra dificultad es el ya

tradicional problema del exceso de entusiasmo que impulsa la cultura del

mercado: pese a las expectativas, el grafeno, los nanotubos y otras

tecnologías de este tipo todavía no han conseguido implantarse a gran

escala. Un ejemplo de dicha cultura de mercado es el ascensor espacial,

basado en los nanotubos de carbono, que despertó el interés popular: la

termodinámica establece la probabilidad de errores, por ejemplo, en el

montaje; y, pese a que los nanotubos de pequeño tamaño pueden mostrar

una resistencia formidable, a partir de una longitud determinada la

existencia de un solo defecto puede tener repercusiones graves. Por lo

tanto, los ascensores espaciales siguen siendo ciencia ficción.

Con todo, hay un ámbito en el que el obstáculo económico se supera a

un ritmo bastante asombroso. En las aplicaciones centradas en el ser

humano, la evolución de la electrónica en la industria de la información

(informática y comunicación), la reducción de costes y la

generalización del uso de la nanotecnología han sido espectaculares. En

este sentido, el teléfono móvil, ya convertido en teléfono inteligente

con acceso a internet y reproducción de vídeo, ha sido una herramienta

de transformación increíblemente beneficiosa para los desfavorecidos del

tercer mundo.

La naturaleza del archivo de los datos y el acceso a los mismos ha

cambiado gracias a las memorias y los recursos computacionales a

nanoescala, situados cada vez más en un «no lugar» muy remoto al que nos

referimos con el eufemismo de «la nube». Asimismo, accedemos a esta

gracias a una serie de avances propiciados por la tecnología a

nanoescala en las comunicaciones, ya sean inalámbricas u ópticas, y con

los dispositivos a nuestro alcance. Los vídeos, los mensajes de texto,

la comunicación instantánea y la difusión rápida de información son algo

cotidiano. Por su parte, los electrodomésticos y dispositivos

electrónicos, de pequeño o gran tamaño, están interconectados y

controlados en un internet de las cosas que conforma un tejido en

expansión tanto en casa como en el trabajo, con objetivos como reducir

el consumo de energía, mejorar la salud o ahorrar al ser humano algunas

tareas cotidianas.

La disponibilidad de información y la capacidad de derivar

inferencias de ella han puesto el aprendizaje automático, también

conocido como inteligencia artificial, en primer plano. Los datos se

pueden analizar y las decisiones se pueden tomar automáticamente de un

modo rudimentario, en el sentido de la máquina emergente. La combinación

de la IA con la robótica (es decir, el uso físico de dicha información)

también se está desplazando poco a poco de las fábricas a las

aplicaciones personales que, como la conducción automática, aúnan la

captación sensorial, la inferencia, el control y el manejo. Todo ello

constituye un uso activo y representa un carácter tan emergente como

evolutivo.

La computación cuántica es otra área con una progresión formidable en

la última década. Para efectuar sus cálculos, la computación cuántica

se basa en la superposición entrelazada de información accesible a

escala cuántica, que es posible a escala nano. Es

muy distinta del estilo tradicional de computación determinista, basado

en los bits clásicos; clásicos en el sentido de que se dividen

exclusivamente entre «0» y «1» lógicos (booleanos). Podemos transformar

estos bits mediante funciones computacionales: un «0» en «1», por

ejemplo, a través de un inversor; o una colección de ceros y unos (es

decir, un número) en otro número, mediante la función que elijamos.

Sumar o multiplicar es una operación funcional de este tipo y, en cada

etapa de la computación, estos ceros y unos se transforman de un modo

determinista. Esto es, en la computación clásica, por lo general, no se

puede volver al punto de partida una vez efectuada una transformación,

puesto que hay información que se va descartando en el proceso: el

producto de una multiplicación suele tener múltiples combinaciones de

multiplicandos y multiplicadores, que tras la operación no se pueden

deducir del resultado.

Los bits cuánticos, en calidad de estados entrelazados superpuestos,

en cambio son muy diferentes. Un sistema con un único bit cuántico

consiste en una superposición de «0» y «1». No sabemos cuál de ellos es,

solo que es uno de los dos; para saber si es «0» o «1», tendremos que

medirlo. Un sistema con dos bits cuánticos puede ser un sistema

entrelazado, donde los dos bits están interconectados. Por ejemplo,

podría ser una superposición en que, si el primero es un 0, el segundo

es un 1, pero si el primero es un 1, el segundo es un 0: esto es una

superposición entrelazada. Solo al efectuar una medición podemos

descubrir si se trata de la combinación «01» o de la combinación «10».

En un sistema compuesto de un gran número de bits cuánticos, estos

pueden formar muchas más conexiones de este tipo, que se pueden

manipular mediante la computación (sin medir el resultado), de forma que

sigan existiendo el entrelazamiento y sus transformaciones. Mientras se

efectúa esta computación, sin haber observado el resultado, es posible

retrotraerse hasta el punto inicial, porque no se ha descartado

información alguna. Por lo tanto, la computación sigue adelante y no

conocemos el resultado hasta que llevamos a cabo una medición, que sí

nos devuelve al modo clásico. Esta capacidad —y las transformaciones que

permite sin renunciar al entrelazamiento y sus consiguientes

posibilidades (a diferencia del modo clásico, que las descarta)— otorga a

la computación cuántica propiedades superiores a las de la computación

clásica. En la actualidad existen sistemas de 50 bits cuánticos, lo que

representa casi el umbral en que la computación cuántica empieza a

superar las capacidades de la computación clásica. Son potencialmente

resolubles ya numerosos problemas complejos, como en la criptografía

(que no en vano fue la primera razón para aplicar este enfoque), pero

también otros interesantes y de índole más práctica: por ejemplo,

comprender las moléculas y sus interacciones para desarrollar su

complejidad con vistas a descubrir nuevos medicamentos. A la hora de

calcular, 50 bits cuánticos representan una complejidad mucho mayor. Si

tenemos en cuenta que, en la diversidad de interacciones a la escala más

reducida, la naturaleza se caracteriza por un comportamiento cuántico y

que el comportamiento cuántico coincide, a una escala mayor y por el

principio de correspondencia, a un comportamiento clásico (es decir, un

resultado estadísticamente muy probable), entonces la computación

cuántica representa una manera, recién descubierta, de simular cómo

computa la propia naturaleza: ha nacido un nuevo tipo de computación.

La

evolución en la AI, la robótica, la autonomía y la combinación de la

maquinaria emergente la evolutiva son, en gran medida, comparables a los

cambios surgidos con la invención de la imprenta y del transporte

mecanizado

Estos cambios de tanta amplitud y relevancia, aún en su fase

naciente, son en gran medida comparables a los surgidos con la invención

de la imprenta y del transporte mecanizado. La imprenta democratizó el

aprendizaje y la difusión de información. Por su parte, el transporte

mecanizado hizo más pequeño el mundo y facilitó la distribución de

bienes. Ambos tuvieron un papel decisivo a la hora de permitir un modo

más eficiente (tanto en tiempo como en energía y en otros aspectos) de

impulsar el progreso humano. Al mismo tiempo, los libros también

transmiten atrocidades y los medios de transporte son una práctica

herramienta tanto para los terroristas como para la represión estatal.

Sin embargo, la sociedad ha encontrado maneras de limitar estos efectos

negativos y sigue encontrando nuevas maneras de limitarlos a medida que

nacen nuevas mutaciones. Las nuevas tecnologías también tienen atributos

nocivos. En este sentido, los instrumentos de comunicación móvil y la

ubicuidad de la disponibilidad de información nos han cambiado: nos

alejan de un pensamiento y una articulación detenidos y de mayor alcance

y modifican nuestra reacción ante cualquier información (debido a la

confianza en la letra impresa que nos han inculcado). Los mercados

financieros, las interacciones sociales e incluso nuestras relaciones

familiares muestran algunas consecuencias de la ubicuidad de acceso

propiciada por la tecnología a nanoescala. Los drones, como máquinas que

permiten matar sin mancharnos las manos de sangre, son omnipresentes en

los conflictos y, gracias a la explotación de la tecnología,

trivializan la muerte y el destino humano.

La computación cuántica es un área con una progresión formidable en la última década. Hoy son potencialmente resolubles numerosos problemas complejos, como en la criptografía, pero también de índole más práctica: por ejemplo, comprender las moléculas y sus interacciones para desarrollar su complejidad con vistas a descubrir nuevos medicamentos

Esta evolución en la IA, la robótica, la autonomía y la combinación

de la maquinaria emergente y la evolutiva plantea preguntas de gran

calado. Además, la sociedad carece de los conocimientos, aunque sea

rudimentarios, necesarios para abordar racionalmente, desde una

perspectiva filosófica y científica, muchos de los problemas que sin

duda surgirán (igual que aparecieron en anteriores puntos de inflexión

desencadenados por la tecnología).

Me gustaría analizar esta transición estudiando las posibilidades de

esta era en ciernes e integrando reflexiones que abarquen desde su punto

de partida hasta su punto de destino, con pensamientos que hagan de

puente entre la dimensión física y la dimensión natural de la

nanotecnología.

La

combinación de la AI con la robótica (es decir, el uso físico de dicha

información) también se está desplazando poco a poco de las fábricas a

las aplicaciones personales

La segunda ley de la termodinámica, formulada por primera vez por

Sadi Carnot en 1824, establece que, en un sistema aislado, la entropía

siempre crece. La entropía, en términos simplificados, es una medida de

aleatoriedad. Según dicha ley, en ausencia de entrada de energía y

materia exterior a un sistema, el sistema evolucionará hacia una

aleatoriedad total; agotará todas sus capacidades. Este estado de máxima

aleatoriedad constituye un equilibrio termodinámico. Este argumento,

inicialmente empírico, cuenta ahora con unos fundamentos estadísticos

concretos y es la razón por la cual los procesos naturales tienden a

avanzar en una determinada dirección, al igual que el paso del tiempo.

Por el contrario, nuestro mundo (el natural y el que hemos creado) tiene

un grado muy alto de organización, además de la capacidad de llevar a

cabo cosas verdaderamente interesantes: los átomos se agrupan en

moléculas; a su vez, las moléculas van ganando complejidad; algunas

moléculas muy complejas, como los ribosomas (formados por ARN y partes

de proteína) se convierten en controladores y efectúan funciones de

transcripción y transmisión de mensajes que son esenciales para la

creación de proteínas; aparecen las células (con miles de variedades en

el caso de los humanos) y se forman los órganos, que se desarrollan

hasta desembocar en la diversidad de las creaciones de la naturaleza. La

jerarquía resultante de este emparejamiento organizado dio lugar a una

máquina emergente viva. Por su parte, nuestro sistema social, al igual

que los sistemas de computación, gobierno o finanzas, también constituye

una maquinaria de este tipo: componentes que se combinan con otros de

acuerdo con una ortodoxia organizada y dotada de muchas capacidades. El

vector hacia la aleatoriedad termodinámica que establecía la segunda ley

se ha evitado gracias al flujo entrante de materia y energía, de manera

que se ha generado una diversidad interesante.

Esta es la apariencia de la complejidad que adopta la forma de una

jerarquía, que Herbert Simon caracteriza mediante una interesante

parábola en su ensayo The Architecture of Complexity [La arquitectura de la complejidad],3 que

habla de los relojeros Hora y Tempus. Ambos fabricaban relojes hechos

de 1.000 pequeñas piezas individuales. Tempus elaboraba sus relojes

juntando todas las piezas de una vez, pero, si le interrumpían (por

ejemplo, con una llamada de teléfono), debía reconstruirlos enteros, con

sus 1.000 piezas. Cuanto más éxito cosechaban sus relojes entre los

clientes, más llamadas recibía y, por lo tanto, más se retrasaba en la

fabricación. Los relojes de Hora eran igual de buenos, pero los

fabricaba mediante una jerarquía de ensamblajes parciales. El primer

grupo de ensamblajes utilizaba 10 piezas en cada uno; a continuación, se

utilizaban 10 ensamblajes parciales para formar un ensamblaje parcial

más grande; y así sucesivamente. Aunque al principio se hacían la

competencia, Tempus acabó trabajando para Hora. Con una probabilidad de 1

entre 100 de una interrupción durante el proceso de ensamblaje, Tempus

tenía que dedicar un promedio de 4.000 veces más de tiempo a producir un

reloj. Con cada interrupción, Tempus tenía que empezar desde el

principio, pero Hora solo tenía que rehacer parte del camino. La

jerarquía hacía posible el éxito de Hora en este rudimentario sistema

complejo.

La moraleja de esta parábola, en términos de termodinámica

(generalizable, además, a nuestro mundo físico y natural), es que la

complejidad surgió de un ensamblaje de piezas que, en general, puede ser

aleatorio. La probabilidad de culminar una construcción a partir de un

pequeño número de elementos que se ensamblan para formar un conjunto

estable, inicialmente simple, pero cada vez más complejo a medida que se

desarrolla la jerarquía, es mayor que la probabilidad de ensamblar un

gran número de elementos de una vez. Por otra parte, aparecen nuevas

propiedades en el producto final y, posiblemente, en los ensamblajes

parciales intermedios. Por supuesto, esta es una descripción muy

simplista y susceptible de muchas objeciones, pero lo importante es que

surgió una estructura organizativa gracias al flujo de entrada de

energía y piezas al sistema y a la existencia de formas intermedias

estables que reducían la entropía. Con el tiempo suficiente, la

naturaleza también forma jerarquías basadas en formas intermedias

estables que descubre. Aparece así la negentropía: un descenso

(negativo) de la entropía desde el estado de agotamiento, es decir,

desde su máximo. Esta es la historia de cómo surgió la vida.

En su libro de 1967, The Ghost in the Machine [El espíritu que mora en la máquina] (es la tercera vez que aparece esta expresión),4 Arthur

Koestler denomina este proceso «el efecto Jano»: los nodos de esta

jerarquía son como el dios romano del mismo nombre, que tenía una cara

que miraba hacia la parte dependiente y otra que miraba hacia el ápice.

Este eslabón y la proliferación de eslabones como estos, asociados a sus

inusuales propiedades, son clave para las propiedades emergentes del

conjunto.

No obstante, la termodinámica plantea más limitaciones, que se

manifiestan en la confluencia de la energía, la entropía y los errores.

Todo sistema complejo está hecho de un gran número de subconjuntos

jerárquicos, y un sistema que emplee objetos a nanoescala está sometido a

estas restricciones en el proceso de su construcción. Para reducir los

errores, debe haber una reducción considerable de la entropía, pero,

como un proceso de reducción tal requiere usar más energía, se generará

calor. Por lo tanto, para ser sostenible (es decir, para evitar el

sobrecalentamiento aun cuando el flujo de energía mantenga el sistema en

funcionamiento), requiere una eficiencia energética elevada, limitar la

cantidad de energía que se transforma y mantener los errores bajo

control. En este sentido, la necesidad de desplegar tanta energía en

cada etapa hace que el sistema adolezca de una insaciable hambre de

energía, una consecuencia termodinámica que influye negativamente en la

computación y la comunicación. Las turbinas gigantes que convierten la

energía en electricidad, desde el movimiento mecánico de las aspas hasta

el flujo de corriente voltaica, deben ser extremadamente eficientes, de

modo que solo un pequeño porcentaje (como mucho) de la energía se

pierda; y todo ello, para una turbina, que no es un sistema tan

complejo. Sin embargo, la computación y la comunicación todavía no han

aprendido esta lección.

Con las CRISPR se abren las puertas al descubrimiento de medicamentos, la prevención de las enfermedades genéticas y cardíacas y las afecciones sanguíneas y la modificación de las propiedades de las plantas

La naturaleza ha encontrado una manera inteligente de evitar este

problema. Pensemos en la compleja máquina biológica que es el ser

humano. Los procesos de desarrollo o reemplazo tienen lugar de forma

individual y en volúmenes muy pequeños (a nanoescala), en paralelo a la

escala del número de Avogadro. Toda esta transcripción, transmisión de

mensajes, generación de proteínas y de células, etcétera, requiere

energía, pero la naturaleza evita el problema del error mediante la

introducción de mecanismos de autorreparación. La rotura y la formación

de estos vínculos consumen muy poca energía (10-100 kBT, donde kBT constituye

una buena medida del orden de energía en un movimiento térmico). Los

errores escalan de manera exponencial con estos prefactores. Con una

energía de 10 kBT, una de cada 100.000 etapas de

desarrollo (por ejemplo, cada etapa de extracción y copia de un

elemento) tendrá un error, que deberá ser detectado. La máquina

desarrolladora deberá, pues, retroceder, hasta el último estado correcto

conocido y reconstruir dicho vínculo; en cierto modo, es como la

llamada a Tempus y Hora, pero en la que Hora solo tiene que reiniciar la

fabricación desde un estado intermedio. La naturaleza consigue hacerlo

bastante bien: a diario, el cuerpo humano recicla su peso corporal en

ATP (adenosina trifosfato, la molécula de la transformación de energía),

a fin de permitir la síntesis química, la propagación de impulsos

nerviosos y la contracción de los músculos. La comprobación y reparación

posibilita este grado de complejidad, pese a las restricciones

energéticas.

¿Qué relación guarda esta explicación sobre la nanotecnología con el

«espíritu oculto»? A modo de ilustración, me gustaría poner en relación

dos tecnologías nuevas de esta década: las CRISPR y la IA actual.

CRISPR es la abreviación de un método de edición de genes que se

sirve de una proteína de origen natural (Cas9) y de ARN-guía específicos

para alterar los genes portadores e insertar en ellos las secuencias

deseadas. La intervención del ARN-guía complementando una secuencia de

ADN foráneo posibilita que la proteína Cas9 desenmarañe la hélice de ADN

de la secuencia y cree un corte en dos cadenas, que después la enzima

reparadora volverá a empalmar mediante la inserción del ADN experimental

deseado. La secuencia del ARN-guía es relativamente barata de diseñar,

su eficiencia es alta y la proteína es inyectable. Además, permite hacer

mutar múltiples genes de una vez. Este proceso se puede efectuar en el

núcleo de una célula, en células madre, en embriones e, incluso, en un

contexto extracelular. Se trata de una herramienta de edición genética

que permite intervenir en el diseño del genoma. Cabe reiterar, en todo

caso, que la termodinámica nos enseña que siempre habrá errores (cuya

probabilidad será inversamente proporcional a la energía empleada), de

modo que los sistemas de baja energía necesitan sistemas de

autocorrección. Aun así, pueden escaparse fallos muy esporádicos. Las

CRISPR son de ayuda precisamente en este apartado, con los errores

naturales del mundo natural: un Jano defectuoso (un error en la

construcción del sistema al modo de Hora) tiene arreglo.

Por tanto se abren las puertas al descubrimiento de medicamentos, la

prevención de las enfermedades genéticas y cardíacas y las afecciones

sanguíneas y la modificación de las propiedades de las plantas;5 tenemos

un buen ejemplo en los tomates que pierden los pedículos (la parte que

une el fruto a la planta), los cuales reciben la señal de morir y

soltarse cuando el tomate está lo bastante maduro. Lo que a un sistema

complejo de la naturaleza le llevaría muchas generaciones, mediante el

cultivo de mejora de las plantas o la cría de especies vivas, se puede

conseguir en una o unas pocas generaciones. Gracias a la intervención

humana, ha nacido una máquina emergente-evolutiva y, por consiguiente,

se pueden diseñar nuevos miembros del reino animal.

La segunda tecnología que abordaremos es la del aprendizaje

automático, que hoy en día evoluciona hacia una inteligencia artificial.

Dado que los dispositivos electrónicos han reducido su tamaño

considerablemente y que se han desarrollado nuevas arquitecturas

(algunas dotadas de rudimentarias formas de autoevaluación y

autorreparación), con niveles todavía mayores de densidad e integración,

ahora contamos con recursos de supercomputación sobre la mesa de

nuestra casa y también en la nube. Hoy en día, esta ingente capacidad de

selección y manipulación de datos basta para que los algoritmos

programados descubran patrones, encuentren vínculos entre estos y,

también, pongan en marcha otras tareas que planteen preguntas para

contribuir a poner a prueba la validez de las inferencias y explorar en

busca de más datos cuando no baste con los disponibles. Desde la

perspectiva humana, la información consiste en asociaciones compactas.

La fotografía de un perro contiene muchos datos en los píxeles e,

incluso, es posible asociarla a una medida de información científica

(una especie de negentropía). En todo caso, los humanos, al ver la

fotografía, asociarán dicha información a la imagen de un perro, pero,

más concretamente, a un perro golden retriever bien cuidado y quizá

también la asociarán a la idea de que los perros de esta raza tienen

tendencia al cáncer a causa de la cría selectiva, etcétera. Buena parte

de esta información puede estar asociada al perro a modo de pequeños

elementos de conocimiento, como, por ejemplo, la idea de que los perros

no se llevan bien con los gatos y que los perros fueron domesticados

(también mediante la cría selectiva) durante la fase en que los humanos

eran cazadores-recolectores. A medida que nos alejamos más y más del

perro como patrón (los perros evolucionaron a partir de los lobos), la

capacidad de una máquina física se va debilitando a falta de una

conexión entre dominios de información muy diferentes que puedan

combinarse en forma de conocimiento. Para un humano, este problema no es

tan grave. Si esta información fáctica sobre el lobo y el perro formara

parte de la máquina como contenido, sería una buena cosa, pero si

quisiéramos encontrar dicha conexión, habría que hacer preguntas, seguir

el rastro genético, cotejar patrones y tomar otras medidas antes de

poder establecer la conexión correspondiente. El aprendizaje y la

creación de conocimiento del ser humano se producen a través de las

hipótesis y el análisis de los resultados de experimentos y debates, que

desembocan en un consenso. Esta capacidad, teniendo en cuenta que las

máquinas pueden pedir y buscar información, está ya al alcance de la IA,

aunque todavía no se ha conseguido conectar dos campos antes separados,

el espacio y el tiempo (como en la relatividad). Por lo tanto, en los

artículos sobre cómo efectúa la IA la evaluación preliminar de

enfermedades y ayuda a diseñar moléculas y a desarrollar experimentos

con las moléculas de diseño, se abordan tareas bastante complejas de

combinación de patrones en las cuales se conectan datos e información.

Por otra parte, el formidable progreso de la computación cuántica

abre otra serie de posibilidades de gran potencial. Las capacidades

diferenciadas y excepcionales de la computación cuántica

(entrelazamiento incluido) podrían hacer que determinadas conexiones,

que eran invisibles bajo un enfoque clásico, se conviertan en latentes

con un enfoque de mecánica cuántica. Esto implica, potencialmente, que

la naturaleza de las asociaciones y conexiones que el ser humano ve

—como las que Einstein identificó en la relatividad, y que el

aprendizaje automático clásico solo podía ver si ya las había visto

antes— pueden ser desentrañadas por la maquinaria de la computación

cuántica, al constar en forma de datos entrelazados y fuera del alcance

de un enfoque clásico.

Llegados a este punto, es el momento de poner en relación este debate con mis reflexiones sobre termodinámica.

Las CRISPR, como herramienta de modificación genética, fueron el

producto de sustituir los ensayos aleatorizados de la naturaleza por la

intervención humana, porque los científicos ya sabían cómo la respuesta

inmune de las bacterias combate un ADN viral foráneo. En este contexto,

las CRISPR sirven para producir dos cadenas de ARN (ARN-guía) que se

agrupan con la enzima Cas9 para formar un complejo, que, a su vez, ataca

al ADN viral, lo separa y, de este modo, lo desactiva. Por el modo en

que la Cas9 se une al ADN, puede distinguir entre el ADN bacteriano y el

AND viral; esta capacidad constituye una memoria que puede seguir

corrigiendo amenazas futuras, es decir, los errores. En la actualidad ya

hemos establecido vínculos entre el campo de las infecciones virales y

bacterianas y el enorme campo de los procesos naturales que dependen del

genoma; así, un proceso cuya estabilidad ya había demostrado la

naturaleza se ha llevado a otros contextos que, pese a haber sido ya

quizá descubiertos por la naturaleza, tal vez no hayan evolucionado en

el sentido de Wallace y Darwin. Las restricciones de la termodinámica,

tanto en lo referido al consumo de energía como a la necesidad de

estabilidad y corrección de errores, se han cumplido en la aplicación

física de las CRISPR al mundo natural. En consecuencia, ahora el ser

humano puede aplicar este procedimiento a multitud de lugares donde la

naturaleza no ha sabido cómo hacerlo o lo ha intentado sin éxito.

El apartado siguiente aborda la evolución de la computación hasta la

IA que ha vivido nuestra tecnología física, así como las

correspondientes ventajas y desventajas. La reducción del tamaño de los

dispositivos electrónicos físicos significa que buena parte de lo que

ocurre a escala cuántica es importante. El efecto túnel es uno de estos

fenómenos: el hecho de que los electrones respondan a dicho efecto por

la mera presencia de voltajes, y no porque se estén manipulando datos,

trae consigo una producción de calor que no sirve para nada útil. La

reducción de los errores en estos sistemas físicos (aunque todavía sin

la capacidad general de corregir los errores durante las etapas

individuales) comporta que no se pueda reducir la energía utilizada para

manipular los datos. Por otra parte, la cantidad de energía consumida

por un sistema biológico complejo para efectuar una transformación útil

está muchos órdenes de magnitud por debajo de la de un sistema físico

complejo. El cerebro humano consume la misma energía que una bombilla de

20 W, mientras que los sistemas físicos utilizados en el ámbito de la

IA presentan, en caso de almacenamiento local, un consumo de energía

cientos de veces superior, que se multiplica por más centenares aún si

el almacenamiento está en la nube. Por lo tanto, esta ventaja para la IA

ha venido acompañada de un ingente incremento en el consumo de energía,

debido a la termodinámica propia del modo de aplicación de este sistema

complejo.

La naturaleza de las asociaciones y conexiones que el ser humano ve, como las que Einstein identificó en la relatividad, y que el aprendizaje automático clásico solo podía ver si ya las había visto antes, pueden ser desentrañadas por la maquinaria de la computación cuántica, al constar en forma de datos entrelazados y fuera del alcance de un enfoque clásico

El pensamiento y el cerebro humanos constituyen una frontera que

podemos entender en sus componentes, pero no como un conjunto complejo y

asombroso; no conviene olvidar, en este sentido, las enseñanzas de la

parábola de los ciegos y el elefante. En todo caso, hay varias

características respecto a las que los científicos (psicólogos,

científicos de la conducta y neurocientíficos) parecen estar de acuerdo

en sus polifacéticos experimentos. El psicólogo conductista Daniel

Kahneman6 distingue

entre el pensamiento rápido y el lento. El rápido es un pensamiento

correspondiente al sistema 1, que es veloz, heurístico, instintivo y

emocional. Cuando efectúa juicios rápidos, una persona pone en relación

otros contextos con el problema a que se enfrenta. Esta dependencia de

la heurística comporta sesgos y, por lo tanto, errores sistemáticos. El

pensamiento lento corresponde al sistema 2, que es deliberativo y

analítico y, por ende, lento. El cerebro humano, como el de otros pocos

mamíferos, es capaz de imaginar varios «mundos» pasados y futuros para

desarrollar inferencias y respuestas situacionales. El neurocientífico

Robert Sapolsky7

analiza los orígenes de la agresión y la recompensa en términos de lo

que sucede en el cerebro. En mi opinión, en su mayor parte están

relacionados con el pensamiento rápido, puesto que tienden a ser

instintivos. En términos funcionales, el cerebro se puede dividir en

tres partes. La primera capa, común al reino animal, es el núcleo

interior, bastante autónomo y que regula el cuerpo para mantenerlo en

equilibrio. La segunda capa, más reciente en la evolución, se expandió

en los mamíferos y es, en proporción, la más avanzada de los humanos. La

tercera capa, el neocórtex o superficie superior, es la que tiene un

desarrollo más reciente (unos cientos de millones de años,8 hace

relativamente poco tiempo) y tiene, como puntos fuertes, la cognición,

la abstracción, la contemplación y el procesamiento sensorial. La capa 1

también recibe instrucciones de la capa 2 por medio del hipotálamo, y

la capa 3 puede enviar señales a la capa 2, que a su vez las remite a la

1. La amígdala cerebral es una estructura límbica (una capa intermedia)

situada bajo el córtex. En la agresión median la amígdala, el córtex

frontal y el sistema de dopamina cortical. El sistema dopaminérgico (la

generación de dopamina en varias zonas del cerebro) se activa en

previsión de una recompensa, de modo que, en este aspecto en particular,

este sistema complejo se puede entrenar (al estilo pavloviano) e

inducir al aprendizaje mediante experiencias de entrenamiento de

refuerzo o inhibición. Un ejemplo profundo del fallo de esta maquinaria

lo representa Ulrike Meinhof, de la organización terrorista Fracción

Baader-Meinhof del Ejército Rojo, formada en 1968 en Alemania. En 1962,

cuando era periodista, a Meinhof le extirparon un tumor cerebral. En

1976 su autopsia reveló un tumor y un tejido cicatrizal quirúrgico que

dañaba la amígdala cerebral, donde los contextos sociales, las

ansiedades, las ambigüedades, etcétera se combinan para formar una

respuesta de agresión. Gran parte de las tendencias de un humano

dependen de esta maquinaria consistente en la relación entre la capa 3 y

la 2, así como de los «Janos» que contienen. Si no se corrigen, los

errores perniciosos en la manera de pensar y tomar decisiones, en el

ámbito de la inteligencia, tienen una gran importancia. Esto, que es

cierto en la naturaleza, también lo será en la IA.

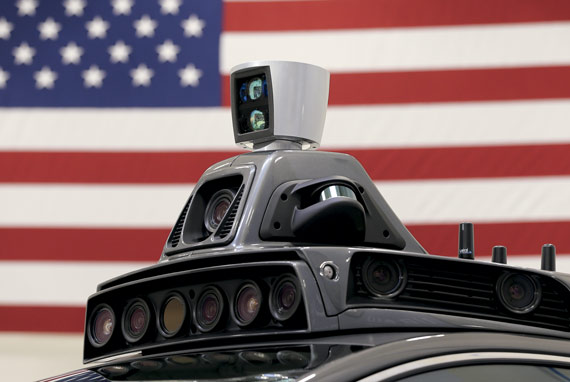

Cámara de techo y sistema de radar del coche autónomo Ford Fusion de Uber durante una demostración de la tecnología de los coches sin conductor celebrada en Pittsburgh, Pensilvania, el 13 de septiembre de 2016

Una vez expuestos los antecedentes del actual estado de las cosas y

efectuado el correspondiente análisis, es el momento de mirar al futuro.

La tecnología, cuando se ha empleado juiciosamente y por el bien

general de la sociedad en su conjunto, ha sido una contribución única

del ser humano a la naturaleza. En los casi dos siglos desde la

invención del motor de vapor, las capacidades tecnológicas se han

desarrollado a un ritmo asombroso.

En este contexto, en las últimas décadas, la nanotecnología ya casi

ha franqueado la gran distancia que separaba lo físico de lo biológico.

Las últimas décadas del siglo XX y las primeras del XXI han

visto nacer muchas herramientas nanotecnológicas que posibilitan un

conocimiento más afinado de los procesos biológicos complejos. A su vez,

ello ha derivado en las increíbles capacidades de manipulación

existentes en la actualidad, que representan una alternativa a los

caminos naturales de la evolución. La IA aporta una capacidad cognitiva

de tipo cerebral. El problema es que dicha capacidad puede aplicarse a

una cantidad de datos asombrosamente mayor que la que ningún humano

pueda contener y, a menudo, está en manos de grandes corporaciones.

La historia de la tecnología nos muestra que la revolución industrial del siglo XIX fue

una revolución en la mecánica que sirvió para automatizar el trabajo

físico. Los actuales cambios que propicia la nanotecnología, por su

combinación de lo biológico y lo físico, los voy a enmarcar en una revolución existencial, porque nos afectan directamente como seres.

La revolución existencial y los cambios y trastornos que es probable

que traiga consigo son de una clase y de una escala que harán inútiles

los esfuerzos posteriores de la sociedad por recuperar el control

(conseguirlo cuesta muchas décadas, ha ocurrido incluso con conflictos

sociales como los derivados del marxismo tras la revolución industrial).

Es necesario ser muy cuidadosos, previsores y juiciosos; de lo

contrario nos enfrentaremos a repercusiones mucho más graves que la

extinción de especies que se está produciendo ya debido a la expansión

desenfrenada de la humanidad y su consiguiente necesidad de recursos.

Son muchos los indicios en este sentido, algunos con una conexión más

profunda que otros. Entre 1965 y 2015, la producción de energía

primaria en el mundo se ha incrementado de 40 PWh a 135 PWh

(petavatios-hora) al año. Es decir, la producción se ha multiplicado por

más de tres en cincuenta años, con el petróleo, el carbón y el gas como

fuentes predominantes de energía. Además, durante el mismo periodo, el

movimiento de energía anual solo en Estados Unidos pasó de unos 8 PWh a

casi 42 PWh; es decir, se quintuplicó. En la actualidad, Estados Unidos

consume, por sí solo, la misma cantidad de energía eléctrica que

consumía el mundo entero hace unos cincuenta años. Además, el consumo de

ese país equivale a una cuarta parte del consumo energético mundial,

aunque la población estadounidense no suponga ni una vigésima parte del

total de la población mundial. Cabe destacar que gran parte de este

incremento en el consumo eléctrico es el resultado de la proliferación

de la computación y la comunicación. El funcionamiento de cada teléfono

móvil inteligente necesita electricidad equivalente al gasto de una

nevera pequeña, que se consume en dispositivos de red y sistemas de

conmutación. Cada búsqueda en la red y cada publicidad emitida gracias a

los algoritmos de aprendizaje automático requieren otra cantidad

equivalente de energía consumida en recursos computacionales. El

calentamiento global es, en el fondo, un problema derivado del consumo

eléctrico, alimentado a su vez por esta estructura de información, con

sus orígenes termodinámicos.

En cuanto al aspecto cognitivo de la capacidad de las máquinas y la

robótica, los coches autónomos constituyen la principal tendencia

actual. Cabe preguntarse si, a medida que mejore dicho aspecto

cognitivo, la gente vivirá más y más lejos de su trabajo y los

automóviles se convertirán en oficinas sobre ruedas o si, por el

contrario, la evolución desembocará en un uso eficiente de los coches,

de modo que recogerán a las personas en lugares preestablecidos y las

llevarán a sus respectivos destinos, lo que hará necesarios menos

automóviles (por su eficiencia y porque solo existirán como servicio

público o vehículo de empresa). Si ocurre esto último, se habrá

encontrado una solución tecnológica para un gran problema que apareció

en nuestra sociedad hace más de cien años, tras la invención del motor

de combustión. Si ocurre lo primero, lo que habrá generado la tecnología

será un nuevo incremento del consumo de energía. En este contexto y en

términos existenciales, es engañosa la generalización continuada del

argumento de que «el medio es el mensaje», porque las empresas

tecnológicas con plataformas computaciolanes y el alcance necesario son,

de hecho, empresas que impulsan publicidad, ideas y estilos de vida

aprovechando su acceso al flujo de interacción social de los individuos.

En cuanto a la alteración biológica, los humanos no han objetado

demasiado a la agricultura modificada genéticamente, que consiste en una

modificación rudimentaria del genoma. La mejora del valor nutricional,

la resistencia a las plagas y el estrés y otras propiedades han tenido

una buena acogida, en especial en Estados Unidos y el tercer mundo. No

se entiende tanto, sin embargo, el cruce de especies y la introducción

de transgénicos foráneos en la naturaleza, tampoco los efectos que tiene

sobre otras especies naturales este constructo artificial que no

procede del proceso evolutivo de la naturaleza. La creciente resistencia

a estas prácticas está asociada también con la invasividad, que conduce

a una reducción de la diversidad. El maíz BT fertiliza otras cosechas y

se convierte en un vector de contaminación cruzada de los genes al

estilo mendeliano. Asimismo, el maíz BT afecta también a algunos

insectos, como ejemplifica el caso de las mariposas monarca. Por lo

tanto, del mismo modo que las bacterias resistentes a los antibióticos a

las que nos enfrentamos hoy en día (en especial en los hospitales del

tercer mundo con la persistencia de la tuberculosis, y en los grandes

hospitales de Estados Unidos), la nueva intervención de diseño en la

biología tendrá consecuencias nocivas. Sin embargo, a día de hoy

carecemos de las capacidades necesarias para visualizar estas posibles

amenazas, de modo que el tema merece un análisis más detenido.

Hablamos, pues, de la introducción de un cambio artificial programado

con precisión en el mundo natural, donde la evolución tiene lugar por

lo común mediante una selección basada en variaciones pequeñas y

heredadas que incrementan la capacidad para competir, sobrevivir y

reproducirse; es decir, mediante interacciones aleatorias naturales que

solo siguen adelante en casos concretos. ¿Qué efecto tendrá la

introducción de cambios artificiales? Conducirá a una prolongación del

proceso natural de evolución, pero, en este caso, tras haber introducido

una entidad no natural. La naturaleza evoluciona muy despacio y a largo

plazo, de modo que minimiza las características dañinas, desde el nivel

muy molecular básico hasta el nivel del sistema complejo, en cada una

de las etapas del ensamblaje. Pese a que el cambio artificial es

portador de una característica específica deseada por el ser humano, es

posible que, como sucede en muchos casos, no cuente con las

características que la naturaleza habría elegido por medio de la

optimización inherente al proceso de evolución natural. La compresión de

la escala temporal y la introducción de una programación específica y

no natural llevan aparejadas unas posibilidades de error elevadas. No en

vano, a diario somos testigos de las funestas consecuencias de dichos

errores en los complejos sistemas de nuestro mundo. Por ejemplo, el

fallo de situar a la persona equivocada en la jerarquía de una

organización conduce al fracaso de esta; y el error de situar el

componente equivocado en un sistema complejo, como el reloj de Hora,

impedirá que el sistema funcione. Se puede conseguir una función

concreta mediante una intervención deliberada, pero es posible que, al

hacerlo, perdamos una función general.

La historia de la tecnología nos muestra que la revolución industrial del siglo XIX fue una revolución en la mecánica que sirvió para automatizar el trabajo físico. Los actuales cambios que propicia la nanotecnología, los voy a enmarcar en una revolución existencial, porque nos afectan directamente como seres

Las CRISPR hacen que las consecuencias de la modificación genética

del mundo natural sean mucho más profundas, porque permiten el cambio

programado de múltiples genes, no solo en las cosechas, sino en todos

sus habitantes, vivos o no. Por añadidura, el efecto de múltiples

cambios simultáneos agrava el riesgo. Un tomate que presente el mismo

tamaño que una hamburguesa, tenga buen sabor, tarde mucho en pudrirse y

crezca en una planta sin pedículos puede ser muy deseable para

McDonald’s, el agricultor o el consumidor, pero, si sus genes se

transmiten a otras especies, entraña riesgos extremos que, en realidad,

ni siquiera son previsibles. Eso es precisamente lo que las

restricciones termodinámicas sobre los procesos de la naturaleza (en

cuanto a la energía, las tasas de error, la corrección de errores, las

mutaciones generacionales y la autoselección) han atenuado durante miles

de millones de años.

Una consecuencia de lo anterior es el potencial de programar algunas

características de nuestros hijos. ¿Quién no quiere que sus hijos sean

más inteligentes y más guapos? Hace cien años la eugenesia gozaba de

inmensa popularidad en los países occidentales (con partidarios como

John Maynard Keynes, Teddy Roosevelt, Bertrand Russell, Bernard Shaw y

Winston Churchill) y trazó un camino que no tardó en culminar en Adolf

Hitler. Entre las bolsas de alta incidencia del síndrome de Asperger se

encuentra Silicon Valley, donde reside un gran número de expertos en

altas tecnologías: un grupo con características específicas y similares

y, por lo tanto, de diversidad reducida. Que el autismo represente un

problema allí no puede sorprender a nadie. Los genes sirven a multitud

de propósitos y de su coexistencia surgen varias características. Los

humanos adquieren sus rasgos (en términos de enfermedades e

inclinaciones, entre otras cosas) a partir de la diversidad. Si

programamos estos aspectos, no podemos saber qué resultados nocivos

podemos provocar y que, además, pueden pasar desapercibidos durante

generaciones.

Otra vía de desarrollo de este enfoque consiste en la combinación de

las CRISPR con la inteligencia artificial, a modo de fusión

emergente-evolutiva. Con los datos suficientes, podría solicitarse una

determinada serie de características en este grupo, utilizar los

algoritmos para diseñar experimentos de CRISPR necesarios para

conseguirlo y, así, se habría diseñado un nuevo ser humano o una nueva

especie. Nada menos.

Como explicaba Leo Rosten, «cuando no sabes hacia qué lugar lleva la

carretera, es indudable que te llevará hasta ese lugar». He aquí la

paradoja existencial.

Lo que me lleva de vuelta al dilema planteado al principio del capítulo. Durante la primera mitad del siglo XX,

movidos por motivaciones similares, aprendimos a crear sustancias

químicas para propósitos concretos, como los pesticidas; y, pese a que

la producción agrícola creció (un resultado deseable), nos enfrentamos

también al problema plasmado en Primavera silenciosa, de Rachel Carson.9 Con el tiempo encontramos maneras de mitigarlo, pero el problema sigue ahí.

El desafío para la sociedad es someter todo esto a un orden

civilizado. Hay que encontrar modos de funcionamiento que permitan la

autorreparación en cada fase de la construcción de los sistemas

complejos. No bastan un enfoque descendente, ni uno ascendente: la

reparación debe operar en cada fase e incidir en el modo de funcionar

tanto de la sociedad como de la tecnología.

El mundo complejo de nuestros días se enfrenta a este dilema existencial, la fusión entre lo emergente y lo evolutivo.

Hemos avanzado hasta dejar atrás el universo de Descartes y Ryle y los grandes fenomenólogos.

Esta maquinaria oculta un espíritu; y los espíritus pueden ser

benévolos o diabólicos. Los benévolos nos beneficiarán enormemente: los

medios de transporte han beneficiado la movilidad, los medicamentos, la

salud y las comunicaciones, nuestra vida social y familiar. Del mismo

modo, la computación ayuda a desarrollar las maravillas y tecnologías

que utilizamos a diario. El ser humano debe entender la tecnología y

darle forma. Si somos capaces de construir sistemas con un conocimiento

claro y razonado sobre qué tipos de emprendimiento humano no son

aceptables, nos guiamos por criterios de relevancia y procedencia y

dotamos de fiabilidad a los sistemas, entonces se podrán conjugar la

educación, la sanidad, la agricultura, las finanzas y todos los demás

elementos esenciales para ser humanos civilizados y ciudadanos del

planeta, por el bien de todos.

Por el contrario, si esta cuestión no se aborda de un modo juicioso, a

escala mundial y otorgando un papel capital al reino de la naturaleza,

la historia humana podría muy bien seguir el mismo camino que exponía

este memorable fragmento de 2010: Odisea Dos, de Clarke:

«El espíritu se había marchado; solo dejó tras de sí unas motas de polvo

juguetonas, que retomaron sus movimientos aleatorios en el aire».

No hay comentarios:

Publicar un comentario