Transformar el conocimiento en salud

El incremento en tres décadas de la esperanza de vida al nacer

durante el siglo XX en numerosos países y regiones de Occidente es el

mejor exponente del valor social de la ciencia y del triunfo de las

políticas públicas de salud sobre la enfermedad. Proseguir en esta

misión, extenderla a las miles de enfermedades raras que continúan sin

tratamiento, llevarla a todos los países y a todos sus ciudadanos es el

desafío de las próximas décadas.

Datos para la «medicina de precisión»

La enfermedad tiene cinco miradas: la del paciente, la del clínico, la del científico, la de la industria y la de las agencias reguladoras. En un primer momento, el paciente experimenta su enfermedad y la atención médica que recibe de una manera única e individual; pero más tarde se produce una relación entre esta individualidad y la comunidad de personas con las que comparte los mismos síntomas. Esta conexión del individuo con su enfermedad ha impulsado lo que la Organización Mundial de la Salud (OMS) define como empoderamiento del paciente «un proceso mediante el cual las personas adquieren un mayor control sobre las decisiones y acciones que afectan a su salud»1 y que debe verse como un proceso tanto individual como colectivo.El clínico, por su parte, no ve en cada paciente un caso único e individual; ha aprendido que no debe vincularse emocionalmente con sus pacientes. Gradualmente dejan de tener un nombre, se convierten en una enfermedad que requiere un diagnóstico preciso y el tratamiento adecuado. Algunos vaticinan que la tecnología reemplazará a un gran porcentaje de los médicos en el futuro. Yo estimo que una parte muy importante de las tareas que realizan en la actualidad estarán robotizadas en el futuro, que se necesitarán equipos médicos de distintas especialidades para proporcionar la atención más precisa a cada paciente y que los datos masivos y la inteligencia artificial serán determinantes para el diagnóstico, pronóstico, tratamiento y seguimiento de la enfermedad. Una mejor tecnología no reemplazará a los médicos, les permitirá hacer mejor su trabajo.

Existe una gran superposición entre los términos medicina de precisión y medicina personalizada. La medicina personalizada es un término más antiguo con un significado similar al de medicina de precisión. Sin embargo, la palabra «personalizada» podría interpretarse como que los tratamientos y las prevenciones se van a desarrollar de forma única para cada individuo. En la medicina de precisión cada paciente sigue sin ser un caso único y la atención se centra en identificar qué enfoques son efectivos para qué pacientes en función de los genes, el metabolismo, el estilo de vida y el entorno de una persona.

Buena parte de las tareas que se realizan hoy estarán robotizadas en el futuro, habrá equipos médicos de distintas especialidades para proporcionar la atención más precisa a cada paciente y los datos masivos y la inteligencia artificial serán determinantes para el diagnóstico, pronóstico, tratamiento y seguimiento de la enfermedadEl concepto de medicina de precisión no es nuevo; los pacientes que reciben una transfusión se han emparejado con donantes según el tipo de sangre durante más de un siglo, lo mismo ocurre con los trasplantes de médula y de órganos desde hace décadas y, más recientemente, con el tratamiento del cáncer de mama, donde el pronóstico y las decisiones de tratamiento se guían principalmente utilizando información molecular y genética de las células tumorales.

Los avances en genética, en metabolismo y la creciente disponibilidad de datos clínicos proporcionan una oportunidad única para hacer posible que la atención con precisión del paciente se convierta en una realidad clínica. La medicina de precisión se basa en la disponibilidad de datos de pacientes y voluntarios sanos a gran escala. Para que la medicina de precisión cumpla sus promesas, cientos de miles de personas deben compartir sus datos genómicos, metabolómicos, sus registros de salud y sus experiencias.

All of Us es un proyecto de investigación que puso en marcha el presidente Barack Obama el 20 de enero de 2015 con estas expresivas palabras: «Esta noche, estoy lanzando un nueva iniciativa en medicina de precisión para acercarnos a curar enfermedades como el cáncer y la diabetes y para darnos a todos acceso a la información personalizada que necesitamos para mantenernos cada uno de nosotros y nuestras familias más saludables».2 Tres años después, en mayo de 2018, este monumental proyecto se puso en marcha con el objetivo de reclutar a más de un millón de voluntarios para que compartan información sobre su salud (historias clínicas, muestras biológicas, encuestas de salud, etcétera) durante muchos años.

Para los científicos, este es un material único. Cuanto más ricas

sean las bases de datos, más precisa será la atención al paciente. Los

datos masivos y la inteligencia artificial están íntimamente ligados:

los datos son los componentes básicos de los algoritmos de aprendizaje,

si se tiene suficiente volumen de datos y se analizan correctamente

pueden aportar una información inconcebible cuando se emplean otras

técnicas. Bancos, compañías como Google y Amazon o empresas eléctricas

utilizan desde hace décadas los datos masivos para mejorar la toma de

decisiones y explorar nuevas oportunidades de negocio.

El empleo de datos masivos en ciencia tampoco es nuevo, los físicos

de partículas y biólogos estructurales fueron pioneros en el desarrollo y

aplicación de los algoritmos que hay detrás de estas tecnologías. En

medicina, los datos masivos tienen el potencial de reducir el coste de

los diagnósticos y tratamientos, predecir brotes epidémicos, evitar

enfermedades prevenibles y mejorar la calidad de vida en general.

Por ejemplo, varios hospitales públicos de París utilizan datos de

una amplia diversidad de fuentes para hacer predicciones diarias y

horarias del número de pacientes que se espera estén en cada hospital.

Cuando un radiólogo solicita una tomografía computarizada, la

inteligencia artificial puede revisar la imagen e identificar los

posibles hallazgos de inmediato, a partir de la imagen y también al

analizar los antecedentes del paciente relacionados con la anatomía

escaneada. Cuando el cirujano tiene que tomar una decisión compleja,

como decidir sobre el momento de la cirugía, si la intervención será

radical o se preservará el órgano, o proporcionar a los pacientes datos

precisos sobre los riesgos potenciales y la probabilidad de mayor

morbilidad y mortalidad, la inteligencia artificial mediante el análisis

de un gran volumen de datos de intervenciones similares puede

proporcionar esta información de forma inmediata.

Naturalmente, han surgido diversas cuestiones legales y éticas

relativas a las condiciones bajo las cuales los investigadores pueden

acceder a las muestras biológicas y a los datos —principalmente cuando

se trata de DNA—, a la propiedad de las muestras biológicas y la

propiedad intelectual derivada de su uso y a cuestiones relacionadas con

los derechos de acceso, confidencialidad, publicación, seguridad y

protección de la información almacenada. Los NIH (National Institutes of

Health) de Estados Unidos han dado muestras de no poca capacidad para

salir de las dificultades que plantean estas cuestiones y alcanzar

acuerdos en tiempos que requieren diálogo y esfuerzo entre todas las

partes implicadas: pacientes, voluntarios sanos, médicos, científicos,

especialistas en aspectos éticos y legales.

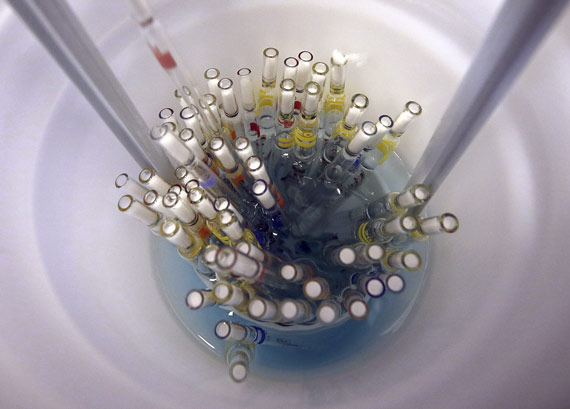

Información genética, proteómica y metabólica; estudios histológicos y

de imagen; del microbioma (el microbiota humano lo integran los miles

de miles millones de células microbianas simbióticas albergadas por cada

persona, principalmente las bacterias intestinales; el microbioma

humano consiste en los genes que estas células albergan); datos

demográficos, clínicos y encuestas de salud son los principales

registros que integran las bases de datos masivos.

«La ciencia son hechos; así como las casas están hechas de piedras,

la ciencia está hecha de hechos; pero un montón de piedras no es una

casa y una colección de hechos no es necesariamente ciencia».3 Son

palabras de Henri Poincaré, advirtiendo de que un conjunto de datos,

por muy grande que sea, no es ciencia; la Real Academia Española define

la ciencia como «el conjunto de conocimientos obtenidos mediante la

observación y el razonamiento, sistemáticamente estructurados y de los

que se deducen principios y leyes generales con capacidad predictiva y

comprobables experimentalmente».4 La

mente humana está organizada de tal forma que insistirá en hallar una

relación entre dos hechos cualquiera que se le presenten; además, cuanto

más distintos sean los hechos —una sinfonía de Gustav Mahler y una

novela de Thomas Mann; datos masivos y una enfermedad— más estimulante

será el esfuerzo de descubrir su relación.

Biología de sistemas

El científico busca mediante la estructuración y el análisis de las

bases de datos el material básico para identificar los conceptos que se

ocultan debajo de su apariencia confusa, como por ejemplo establecer una

distinción precisa entre dos subtipos de una misma enfermedad con

histologías similares pero que responden diferente al tratamiento o

tienen distinto pronóstico. La biología de sistemas es la rama de la

investigación en biología que trata sobre estos temas; es decir,

descifrar la complejidad de los sistemas biológicos. Es una aproximación

holística que se basa en la premisa de que las redes de interacciones

que constituyen un organismo vivo son más que la suma de sus partes.

La biología de sistemas integra múltiples disciplinas —bioquímica,

biología estructural, biología molecular y celular, matemáticas,

bioinformática, imagen molecular, ingeniería, etcétera— para crear

algoritmos que predigan cómo un sistema biológico cambia en el tiempo y

frente a diferentes condiciones —salud versus enfermedad; ayuno versus

alimentación— y desarrollar soluciones a los problemas de salud y

ambientales más acuciantes.

A nivel biológico, el cuerpo humano está formado por múltiples redes

que se integran y comunican a múltiples escalas. Desde nuestro genoma

hasta las proteínas y metabolitos que constituyen las células que

configuran los órganos de nuestros cuerpos, somos fundamentalmente una

red de redes de interacciones que se pueden definir mediante algoritmos.

La biología de sistemas analiza estas redes a través de escalas para

integrar comportamientos en diferentes niveles, formular hipótesis sobre

la función biológica y proporcionar conocimientos espaciales y

temporales sobre los cambios biológicos dinámicos. Para estudiar la

complejidad de la biología no es suficiente comprender solo una parte de

un sistema, hay que entender su totalidad.

El reto al que se enfrenta la biología de sistemas supera cualquier

desafío que haya afrontado hasta ahora la ciencia. Consideremos el caso

del metabolismo; los fenotipos metabólicos —de una célula, un órgano o

un organismo— son los resultados de todas las actividades catalíticas de

las enzimas (las proteínas que catalizan específicamente una reacción

bioquímica del metabolismo) establecidas por las propiedades cinéticas,

la concentración de sustratos, productos, cofactores, etcétera y de

todas las interacciones reguladoras no lineales a nivel transcripcional

(la etapa de la expresión genética en la que la secuencia de ADN es

copiada en una secuencia de ARN), traslacional (el proceso que

decodifica una secuencia de ARN para generar una cadena específica de

aminoácidos y formar una proteína), postraduccional (las modificaciones

covalentes de una proteína después de ser sintetizada que inducen una

gran variedad de cambios estructurales y funcionales) y alostérico (un

cambio en la estructura y actividad de una enzima que resulta de la

unión no covalente con otra molécula en un sitio que es diferente del

centro químicamente activo).

En otras palabras, una descripción metabólica detallada requiere

conocer no solo todos los factores que influyen en la cantidad y el

estado de las enzimas, sino también la concentración de todos los

metabolitos que regulan cada reacción. Como consecuencia, los flujos

metabólicos (el paso de todos los metabolitos a través del conjunto de

todas las reacciones enzimáticas de un sistema a lo largo del tiempo) no

pueden determinarse conociendo únicamente la concentración de

metabolitos o viceversa, conociendo solo todas las interacciones no

lineales de las enzimas.

Para determinar los flujos metabólicos con un cierto grado de

confianza es necesario conocer la concentración de todos los metabolitos

implicados y las cantidades de proteína de todas las enzimas

implicadas, con sus modificaciones postraduccionales, junto a un

detallado modelo computacional de las reacciones que catalizan.

Paralelamente, se requiere un enfoque de biología de sistemas para

integrar grandes conjuntos de datos heterogéneos, como transcriptómica

(el estudio del conjunto completo de transcritos de ARN), proteómica (el

estudio del conjunto completo de proteínas), metabolómica (el estudio

del conjunto completo de metabolitos) y fluxómica (el estudio en el

tiempo del destino de cada uno de los metabolitos y el análisis de las

rutas utilizadas), y construir con ellos un modelo metabólico integral.

Se estima que en el genoma humano hay entre 20.000 y 25.000 genes que

codifican proteínas, de las cuales cerca de 3.000 son enzimas que

pueden dividirse aproximadamente en 1.700 metabólicas y 1.300 no

metabólicas, incluidas las responsables de las modificaciones

postraduccionales de enzimas metabólicas, como las proteínas cinasas,

también llamadas quinasas, que operan como transductores de señales

modificando las propiedades cinéticas de las enzimas metabólicas (de ahí

el nombre de cinasa o quinasa, que deriva del inglés kinetic)

mediante fosforilación (introducir ácido fosfórico en una proteína)

ocupando un lugar central en la regulación del metabolismo. Las enzimas

metabólicas se han asignado a unas 140 rutas metabólicas (conjunto de

reacciones químicas vinculadas catalizadas por enzimas) diferentes.

Este mapa metabólico humano, aunque podría decirse que es la red

celular mejor caracterizada, aún permanece incompleto. Existe una

importante cantidad de metabolitos, enzimas y rutas metabólicas que

todavía no han sido bien caracterizados o que simplemente se desconocen;

incluso en las rutas metabólicas más antiguas, como la glicolisis

(conjunto de reacciones químicas que degradan algunos azúcares, como la

glucosa, obteniendo energía en el proceso), el ciclo de la urea (un

ciclo de cinco reacciones bioquímicas que convierten el amoníaco tóxico

en urea para ser excretado en la orina) y la síntesis de lípidos,

existen muchos huecos sin completar. Los fenotipos metabólicos son,

además, el producto de las interacciones entre una variedad de factores

externos —dietéticos y otros estilos de vida, conservantes,

contaminantes, ambientales, microbianos— que igualmente deben estar

integrados en el modelo.

La biología de sistemas integra múltiples disciplinas —bioquímica, biología estructural, biología molecular y celular, matemáticas, bioinformática, imagen molecular o ingeniería— para crear algoritmos que predigan cómo un sistema biológico cambia en el tiempo y frente a diferentes condiciones

La colección completa de moléculas pequeñas (metabolitos) que se

encuentran en el cuerpo humano —incluidos los lípidos, aminoácidos,

carbohidratos, ácidos nucleicos, ácidos orgánicos, aminas biogénicas,

vitaminas, minerales, aditivos alimentarios, fármacos, productos

cosméticos, contaminantes y cualquier otra sustancia química de pequeño

tamaño que los humanos ingieren, metabolizan o entran en contacto— se

desconoce; se han identificado alrededor de 22.000, aunque se estima que

el metaboloma humano puede superar los 80.000 metabolitos.

Metabolismo y enfermedad

La idea de que la enfermedad produce cambios en los fluidos

biológicos y de relacionar patrones químicos con la salud es muy

antigua. Los «diagramas de la orina», unas tablas en las que se

vinculaban los colores, olores y sabores de la orina —todos ellos

estímulos de naturaleza metabólica— a diversas condiciones médicas se

utilizaron ampliamente en la Edad Media para el diagnóstico de diversas

enfermedades. Si la orina tenía un sabor dulce se diagnosticaba

diabetes, que significa «sifón» (para indicar que los pacientes orinaban

frecuentemente). En 1675 se añadió la palabra mellitus, que significa «miel» (para testificar que era dulce), y en el siglo XIX se

desarrollaron métodos para detectar la presencia de glucosa en la orina

de las personas diabéticas. En 1922, Frederick Banting y su equipo

utilizaron un extracto pancreático que denominaron «insulina» para

tratar con éxito a un paciente con diabetes, un descubrimiento que les

valió el premio Nobel de Medicina un año más tarde; en 1921, Nicolae

Paulescu había demostrado el efecto antidiabético de un extracto de

páncreas que llamó «pancreina», un descubrimiento que patentó en 1922.

El restablecimiento de la homeostasis metabólica (conjunto de

fenómenos de autorregulación que conducen al mantenimiento de la

constancia en la composición de metabolitos y propiedades del medio

interno de una célula, un tejido o un organismo) mediante terapia de

sustitución ha sido empleado con éxito en numerosas ocasiones, como en

la enfermedad de Parkinson, donde el restablecimiento de la

concentración de dopamina mediante el tratamiento con levodopa tiene un

efecto terapéutico incuestionable; un descubrimiento que le valió a

Arvid Carlsson el premio Nobel de Medicina en 2000.

La interrupción del flujo metabólico, sin embargo, no solo afecta a

los metabolitos que se encuentran por debajo de la reacción que está

interrumpida; como si se tratase de una red fluvial, también produce la

acumulación de metabolitos aguas arriba. Por ejemplo, la fenilcetonuria,

una enfermedad metabólica hereditaria rara (se dice que una enfermedad

es rara cuando afecta a menos de una de cada 2.000 personas) causada por

la deficiencia en fenilalanina hidroxilasa (una enzima que convierte la

fenilalanina en el aminoácido tirosina) produce la acumulación de

fenilalanina en la sangre y el cerebro; a concentraciones elevadas, la

fenilalanina es tóxica causando anomalías graves e irreversibles en la

estructura y función del cerebro. El tratamiento en recién nacidos

afectados por este error congénito del metabolismo con una dieta

deficiente en fenilalanina previene el desarrollo de la enfermedad.

Otro ejemplo es la intolerancia hereditaria a la fructosa (IHF), que

aparece como resultado de la deficiencia de aldolasa B, una enzima que

desempeña un papel crucial en el metabolismo de la fructosa y la

gluconeogénesis (la ruta metabólica que conduce a la síntesis de glucosa

a partir de precursores que no son carbohidratos). Las personas

afectadas con IHF desarrollan disfunción hepática y renal después del

consumo de fructosa, que puede conducir a la muerte particularmente

durante la infancia. El único tratamiento de esta enfermedad rara es la

eliminación de la dieta de todas las fuentes de fructosa, tales como la

sacarosa, zumos de frutas, espárragos o guisantes.

Cuando la eliminación de un nutriente de la dieta no es una opción

para el restablecimiento de la homeostasis metabólica, una alternativa

es diseñar chaperonas farmacológicas; pequeñas moléculas que se asocian a

las proteínas mutantes para estabilizarlas y provocar que se comporten

correctamente; de ahí el nombre de «chaperona»: persona que acompaña a

una pareja o a un joven para vigilar su comportamiento.

En el caso de ciertas proteínas, como la uroporfirinógeno III

sintasa, una enzima clave en la síntesis del grupo hemo (el grupo

prostético que forma parte de numerosas proteínas, como la hemoglobina)

cuya deficiencia causa la porfiria eritropoyética congénita, este

enfoque terapéutico ha tenido un éxito llamativo en un modelo

experimental de la enfermedad, apoyando la idea de que las chaperonas

farmacológicas pueden convertirse en poderosas herramientas

terapéuticas.

Terapia génica y edición del genoma

En septiembre de 1990 se llevó a cabo en los NIH el primer

tratamiento de terapia génica (una técnica experimental que emplea genes

para tratar o prevenir enfermedades) para combatir la deficiencia en la

enzima adenosina deaminasa (una enfermedad hereditaria rara que causa

inmunodeficiencia severa) en una niña de cuatro años. En 2016, la

Agencia Europea del Medicamento (EMA) recomendó el uso de esta terapia

en niños con ADA cuando no es posible emparejarlos con un donante de

médula adecuado. Aunque la terapia génica es un tratamiento prometedor

para diversas enfermedades (incluidas enfermedades hereditarias, algunos

tipos de cáncer y ciertas infecciones virales), treinta años después de

los primeros estudios clínicos no está exenta de riesgos y se sigue

investigando para que sea una técnica eficaz y segura. En la actualidad

solo se está usando en enfermedades que no tienen otros tratamientos.

La edición del genoma, o edición de genes, es otra técnica de gran

interés en la prevención y tratamiento de las enfermedades. Se refiere a

un conjunto de tecnologías que permiten agregar, eliminar o alterar el

material genético en lugares específicos del genoma. Se han desarrollado

varios enfoques para la edición del genoma. La FDA aprobó en agosto de

2018 la primera terapia basada en RNA de interferencia (RNAi), una

técnica descubierta hace veinte años que puede ser utilizada para

«silenciar» genes causantes de enfermedades específicas. La más reciente

se conoce como CRISPR-Cas9. Se está investigando su aplicación a

enfermedades hereditarias raras, como la fibrosis quística o la

hemofilia, y también para el tratamiento y prevención de enfermedades

complejas, como el cáncer, las enfermedades cardíacas y las enfermedades

mentales. Como en el caso de la terapia génica y el RNAi, la aplicación

médica de la edición génica no está exenta de riesgos y su resolución

tomará tiempo.

Transformación metabólica

Friedrich Nietzsche, refiriéndose a la filología, decía que «es un

arte respetable, que exige a quienes la admiran que se mantengan al

margen, que se tomen tiempo, que se vuelvan silenciosos y pausados; un

arte de orfebrería, una pericia propia de un orfebre de la palabra, un arte que exige un trabajo sutil y delicado, en el que no se consigue nada si no se actúa con lentitud».5Sustitúyase «orfebre de la palabra» por «orfebre del método científico»,

y esta sugerente frase de Nietzsche es aplicable a la investigación

biomédica. Limitarse a perseguir lo útil, en ciencia, suprime la

imaginación.

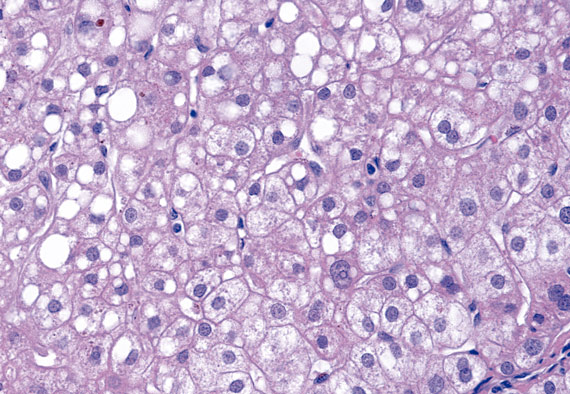

En la década de 1920, Otto Warburg y su equipo hicieron la

observación de que los tumores utilizaban enormes cantidades de glucosa

en comparación con la que consumía el tejido circundante. Además,

observaron que la glucosa se metabolizaba para producir lactato como

fuente de energía (ATP), en lugar de CO2, incluso en

presencia de suficiente oxígeno para la respiración, un proceso que se

conoce como glicolisis anaerobia (ninguna de las nueve reacciones de

esta ruta metabólica que une a la glucosa con el lactato emplea

oxígeno). Este cambio de glicolisis aerobia a anaerobia en los tumores

se conoce con el nombre de «efecto Warburg». El efecto Warburg es una

adaptación metabólica, una ventaja de las células tumorales para crecer;

las células tumorales utilizan los tres átomos de carbono del lactato

para sintetizar los «materiales básicos» de los que están hechos las

células (aminoácidos, proteínas, lípidos, ácidos nucleicos, etcétera) y

generar masa.

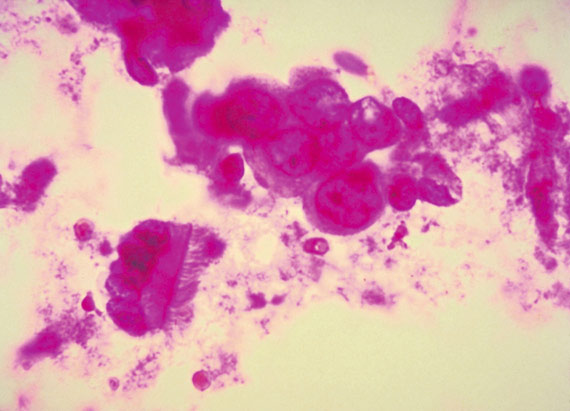

Ahora sabemos que, aunque colectivamente los tumores exhiben un

amplio paisaje de cambios genéticos, las células neoplásicas exhiben un

fenotipo común que se caracteriza por un crecimiento desordenado que

mantiene su potencial invasivo y letalidad. Sostener esta imparable

división celular requiere adaptaciones metabólicas que promuevan la

supervivencia del tumor y destruyan las células normales; esta

adaptación se ha denominado «transformación metabólica». De hecho,

aunque la transformación celular en distintos tipos de tumores surge de

múltiples vías diferentes, los requerimientos metabólicos de las células

tumorales resultante son similares: las células cancerígenas deben

generar energía (ATP), sintetizar los «materiales básicos» para sostener

el crecimiento celular y equilibrar el estrés oxidativo resultante de

su crecimiento imparable.

Debido a estos requerimientos comunes, en la actualidad hay un gran

interés en diseccionar los mecanismos y el impacto de la transformación

metabólica tumoral, con el objetivo de diseñar terapias que bloqueen

estas adaptaciones y sean efectivos para frenar el crecimiento del

cáncer y la metástasis.

En 1948, Sidney Farber y su equipo obtuvieron remisiones en varios

niños con leucemia aguda indiferenciada utilizando aminopterina, un

inhibidor de la enzima dihidrofolato reductasa que cataliza una reacción

necesaria para la síntesis de DNA. Esa molécula fue el predecesor del

metotrexato, un medicamento para el tratamiento del cáncer que se usa

comúnmente en la actualidad.

En la actualidad hay un gran interés en diseccionar los mecanismos y el impacto de la transformación metabólica tumoral, con el objetivo de diseñar terapias que sean efectivas para frenar el crecimiento del cáncer y la metástasis

La era de la quimioterapia comenzó modificando el metabolismo de los

tumores; desde entonces, otros investigadores han descubierto moléculas

capaces de frenar el crecimiento de diversos tipos de cáncer y la

metástasis habiéndose reducido la tasa anual de mortalidad por cáncer un

promedio del 1,4% en mujeres y 1,8% en hombres, desde 1999 hasta 2015

en Estados Unidos (los datos en Europa son similares).

En 1976, después de analizar 6.000 muestras de extractos de hongos,

Akira Endo aisló la mevastatina, una molécula capaz de bloquear la

actividad de la enzima 3-hidroxy-3-metil-glutaril-coenzima A reductasa.

Esta enzima cataliza la reacción limitante en la síntesis de

colesterol. La mevastatina fue la predecesora de la lovastatina, un

medicamento que desde 1984 se emplea comúnmente para el tratamiento de

la hipercolesterolemia. Desde entonces se han descubierto otras

estatinas con mejor perfil de eficacia y seguridad.

La reducción de la concentración de colesterol mediante el

tratamiento con estatinas tiene un efecto terapéutico incuestionable

sobre la aparición de incidentes cardiovasculares; es uno de los

principales factores que han contribuido a la disminución de más del 50%

de las muertes por enfermedad cardiovascular y derrames cerebrales en

las últimas décadas en los países occidentales; los otros dos son los

medicamentos antihipertensivos (la hipertensión es una enfermedad

metabólica resultante del desequilibrio en la homeostasis del agua y

electrolitos, principalmente sodio y potasio) y antidiabéticos.

Conclusión

El incremento en tres décadas de la esperanza de vida al nacer durante el siglo XX en

numerosos países y regiones de Occidente es el mejor exponente del

valor social de la ciencia y del triunfo de las políticas públicas de

salud sobre la enfermedad: el descubrimiento de las vitaminas y la

insulina, el desarrollo de vacunas, los antibióticos, los rayos X, la

cirugía a corazón abierto, la quimioterapia, los antihipertensivos, las

técnicas de imagen, los antidiabéticos, las estatinas, los antivirales o

la inmunoterapia son ejemplos de la productiva colaboración entre la

academia y la industria. En 2015, aprovechando los avances de los

Objetivos de Desarrollo del Milenio, las Naciones Unidas adoptaron los

Objetivos de Desarrollo Sostenible, que incluyen el compromiso de

alcanzar la cobertura universal de salud en 2030. Sin embargo, aún

existen enormes diferencias entre lo que se puede conseguir en salud y

lo que se ha logrado, y el progreso ha sido incompleto y desigual.

Alcanzar este objetivo requiere un esfuerzo integral y continuo que

permita mejorar la calidad de los servicios de atención médica a nivel

mundial.

¿Se podría acelerar el proceso de transformar el conocimiento en

salud? En 1996, James Allison observó que los ratones tratados con un

anticuerpo anti-CTLA-4 (un receptor que regula negativamente la

respuesta de los linfocitos T) rechazaban los tumores; los estudios

clínicos comenzaron en 2001 y en 2011 la FDA aprobó este procedimiento

para tratar el melanoma metastásico, el primer fármaco oncológico basado

en la activación del sistema inmune. Este trabajo le valió a Allison el

Premio Nobel de Medicina en 2018.

Cinco años para finalizar los estudios preclínicos y diez más para

los ensayos clínicos pueden parecer muchos. La investigación preclínica

responde a preguntas básicas sobre el mecanismo de acción y la seguridad

de un medicamento, si bien no sustituye a los estudios sobre las formas

en que el medicamento interactuará con el cuerpo humano. De hecho, los

ensayos clínicos siguen una serie de fases estrictamente regladas por

las agencias del medicamento (EMA, FDA) desde los iniciales de fase 1 y

2, a pequeña escala, a los de fase 3 y 4 a gran escala.

La complejidad del diseño, el incremento del número de pacientes, los

criterios de inclusión, la seguridad, los criterios para demostrar

eficacia y periodos más largos de tratamiento son las principales causas

que han alargado la duración de los ensayos clínicos.

No es exagerado decir que mantener el statu quo obstaculiza

el desarrollo de nuevos fármacos, principalmente en aquellas áreas

terapéuticas más necesitadas. Pacientes, médicos, investigadores,

industria y agencias reguladoras necesitan alcanzar acuerdos para

acelerar el progreso y precisión de los tratamientos. Además, la

industria farmacéutica necesita pensar con mucho cuidado sobre si el

elevado coste de los nuevos tratamientos estuviese dejando al margen de

sus beneficios terapéuticos a una parte importante de la población

general, repercutiendo negativamente en la calidad y esperanza de vida.

La ciencia es una obra social.

Notas

5. Nietzsche, Friedrich (1994): Aurora. Reflexiones sobre los prejuicios morales, Madrid, M. E. Editores, p. 32https://www.bbvaopenmind.com/articulos/transformar-el-conocimiento-en-salud/?fbclid=IwAR0pcUnNsJpRTQjDcNZQCHNwz88Y8kHKvBvLEEPf26enXK6EhjV4oY9idGo

Citar

Mato, J.M., "Transformar el conocimiento en salud", en ¿Hacia una nueva Ilustración? Una década trascendente. Madrid, BBVA, 2018.

- ¿Puede la medicina ser predictiva?

- La biomedicina en el cambio de siglo

- La revolución biológica de la edición genética con tecnología CRISPR

No hay comentarios:

Publicar un comentario