1. Bush, V., «As We May Think», en Atlantic Monthly, n.º 176, julio de 1945, pp. 101-108.

2. Weiser, M., «The Computer for the 21st Century», en Scientific American, vol. 265, n.º 3, septiembre de 1991, pp. 66-75.

3. Paradiso, J. A., «Modular Synthesizer», en Stocker, G. y Schopf, C. (eds.), Timeshift (Actas de Ars Electronica, 2004), Ostfildern-Ruit, Alemania, Hatje Cantz Verlag, 2004, pp. 364-370.

4. Paradiso, J. A., «Electronic Music Interfaces: New Ways to Play», en IEEE Spectrum, vol. 34, n.º 12, diciembre de 1997, pp. 18-30.

5. Paradiso, J. A., «Sensor Architectures for Interactive Environments», en Deleaney, K. (ed.), Augmented Materials & Smart Objects: Building Ambient Intelligence Through Microsystems Technologies, cap. 16, Springer, 2008, pp. 345-362.

6. MacKenzie, D., Inventing Accuracy: a Historical Sociology of Nuclear Missile Guidance, Cambridge, Massachusetts, The MIT Press, 1990.

7. Walter, P. L., «The History of the Accelerometer» (ed. rev.), en Sound and Vibration, enero de 2007, pp. 84-92.

8. Weinberg, H., «Using the ADXL202 in Pedometer and Personal Navigation Applications», en Analog Devices Application Note AN-602, Analog Devices Inc., 2002.

9. Renaudin, V., Yalak, O. y Tomé, P., «Hybridization of MEMS and Assisted GPS for Pedestrian Navigation», en Inside GNSS, enero-febrero de 2007, pp. 34-42.

10. Malinowski, M., Moskwa, M., Feldmeier, M., Laibowitz, M. y Paradiso, J. A., «CargoNet: A Low-Cost MicroPower Sensor Node Exploiting Quasi-Passive Wakeup for Adaptive Asychronous Monitoring of Exceptional Events», en Proceedings of the 5th ACM Conference on Embedded Networked Sensor Systems (SenSys’07), Sídney, Australia, 6-9 de noviembre de 2007, pp. 145-159.

11. Benbasat, A. Y. y Paradiso. J. A., «A Framework for the Automated Generation of Power-Efficient Classifiers for Embedded Sensor Nodes», en Proceedings of the 5th ACM Conference on Embedded Networked Sensor Systems (SenSys’07), Sídney, Australia, 6-9 de noviembre de 2007, pp. 219-232.

12. Bernstein, J., «An Overview of MEMS Inertial Sensing Technology», en Sensors Magazine, 1 de febrero de 2003.

13. Benbasat, A. Y. y Paradiso. J. A., op. cit, pp. 219-232.

14. Ahmad, N., Ghazilla, A. R., Khain, N. M. y Kasi, V., «Reviews on Various Inertial Measurement (IMU) Sensor Applications», en International Journal of Signal Processing Systems, vol. 1, n.º 2, diciembre de 2013, pp. 256-262.

15. Verplaetse, C., «Inertial Proprioceptive Devices: Self-motion-Sensing Toys and Tools», en IBM Systems Journal, vol. 35, n.º 3-4, 1996, pp. 639-650.

16. Paradiso, J. A., «Some Novel Applications for Wireless Inertial Sensors», en Proceedings of NSTI Nanotech 2006, vol. 3, Boston, Massachusetts, 7-11 de mayo de 2006, pp. 431-434.

17. Aylward, R. y Paradiso, J. A., «A Compact, High-Speed, Wearable Sensor Network for Biomotion Capture and Interactive Media», en Proceedings of the Sixth International IEEE/ACM Conference on Information Processing in Sensor Networks (IPSN 07), Cambridge, Massachusetts, 25-27 de abril de 2007, pp. 380-389.

18. Lapinski, M., Feldmeier, M. y Paradiso, J. A., «Wearable Wireless Sensing for Sports and Ubiquitous Interactivity», en IEEE Sensors 2011, Dublín, Irlanda, 28-31 de octubre de 2011.

19. Lapinski, M. T., «A Platform for High-Speed Biomechanical Data Analysis using Wearable Wireless Sensors», tesis doctoral, MIT Media Lab, agosto de 2013.

20. Lightman, K., «Silicon Gets Sporty: Next-Gen Sensors Make Golf Clubs, Tennis Rackets, and Baseball Bats Smarter Than Ever», en IEEE Spectrum, marzo de 2016, pp. 44-49.

21. Para un ejemplo temprano, véase la ficha técnica del Analog Devices AD22365.

22. M. Feldmeier y Paradiso, J. A., «Personalized HVAC Control System», en Proceedings of Internet of Things 2010, Tokio, Japón, del 26 de noviembre al 1 de diciembre de 2010.

23. De Rossi, D. y Lymberis, A. (eds.), «IEEE Transactions on Information Technology», en Biomedicine, Special Section on New Generation of Smart Wearable Health Systems and Applications, vol. 9, n.º 3, septiembre de 2005.

24. Buechley, L., «Material Computing: Integrating Technology into the Material World», en Price, S., Jewitt, C. y Brown, B. (eds.), The SAGE Handbook of Digital Technology Research, Sage Publications Ltd., 2013.

25. Poupyrev, I. Gong, N.-W., S., Fukuhara, M. E., Karagozler, Schwesig, C. y Robinson, K., «Project Jacquard: Interactive Digital Textiles at Scale», en Proceedings of CHI 2016, 7-12 de mayo de 2016, pp. 4.216-4.227.

26. Vinge, V., Rainbow’s End, Nueva York, Tor Books, 2006.

27. Hou, C., Jia, X., Wei, L., Tan, S.-C., Zhao, X., Joanopoulos, J. D. y Fink, Y., «Crystalline Silicon Core Fibres from Aluminium Core Performs», en Nature Communications, vol. 6, febrero de 2015.

28. Chandler, D. L., «New Institute Will Accelerate Innovations in Fibers and Fabrics», en MIT News, 1 de abril de 2016.

29. Vega, K., Beauty Technology: Designing Seamless Interfaces for Wearable Computing, Cham, Suiza, Springer, 2016.

30. Liu, X., Vega, K., Maes, P. y Paradiso, J. A., «Wearability Factors for Skin Interfaces», en Proceedings of the 7th Augmented Human International Conference 2016 (AH ‘16), Nueva York, ACM, 25-27 de febrero de 2016.

31. Vega, K., Jing, N., Yetisen, A., Kao, V., Barry, N. y Paradiso, J. A., «The Dermal Abyss: Interfacing with the Skin by Tattooing Biosensors», documento de trabajo para la conferencia TEI 2017.

32. Mayton, B. D., Zhao, N., Aldrich, M., Gillian, N. y Paradiso, J. A., «WristQue: A Personal Sensor Wristband», en Proceedings of the IEEE International Conference on Wearable and Implantable Body Sensor Networks (BSN’13), 2013, pp. 1-6.

33. Bainbridge, R. y Paradiso, J. A., «Wireless Hand Gesture Capture Through Wearable Passive Tag Sensing», en International Conference on Body Sensor Networks (BSN’11), Dallas, Texas, 23-25 de mayo de 2011, pp. 200-204.

34. Way, D. y Paradiso, J. A., «A Usability User Study Concerning Free-Hand Microgesture and Wrist-Worn Sensors», en Proceedings of the 2014 11th International Conference on Wearable and Implantable Body Sensor Networks (BSN ‘14), IEEE Computer Society, junio de 2104, pp. 138-142.

35. Dementyev, A. y Paradiso, J. A., «WristFlex: Low-Power Gesture Input with Wrist-Worn Pressure Sensors», en Proceedings of UIST 2014, the 27th annual ACM symposium on User interface software and technology, Honolulu, Hawái, octubre de 2014, pp. 161-166.

36. Kao, H.-L., Dementyev, A., Paradiso, J. A. y Schmandt, C., «NailO: Fingernails as Input Surfaces», pendiente de publicación en las Actas de la International Conference on Human Factors in Computing Systems (CHI’15), Seúl, Corea del Sur, abril de 2015.

37. Laibowitz, M. y Paradiso, J. A., «Parasitic Mobility for Pervasive Sensor Networks», en Gellersen, H. W., Want R. y Schmidt A. (eds.), Pervasive Computing, Proceedings of the Third International Conference, Pervasive 2005, Múnich, Alemania, mayo de 2005, Berlín, Springer-Verlag, 2005, pp. 255-278.

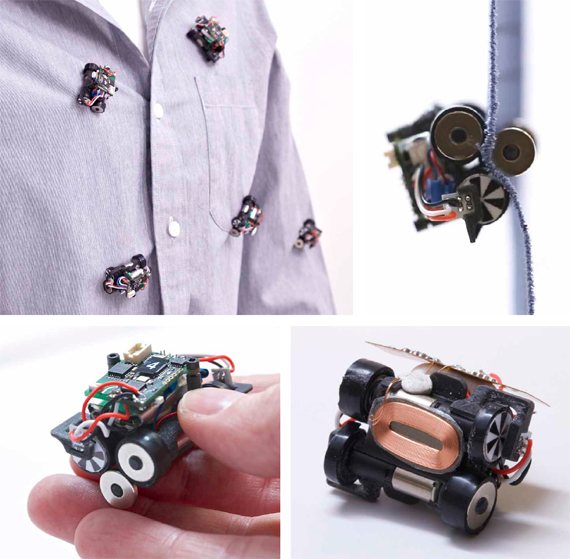

38. Dementyev, A., Kao C.-L., Choi, I., Ajilo, D., Xu, M., Paradiso, J. A., Schmandt, C. y Follmer, S., «Rovables: Miniature On-Body Robots as Mobile Wearables», en Proceedings of ACM UIST 2016, 2016.

39. Orwell, G., 1984, Londres, Secker and Warburg, 8 de junio de 1949.

40. Fossum, E. R., «CMOS Image Sensors: Electronic Camera-On-A-Chip», en IEEE Transactions On Electron Devices, vol. 44, n.º 10, octubre de 1997, pp. 1.689-1.698.

41. Paradiso, J. A., «New Technologies for Monitoring the Precision Alignment of Large Detector Systems», en Nuclear Instruments and Methods in Physics Research, vol. A386, 1997, pp. 409-420.

42. Gokturk, S. B., Yalcin, H. y Bamji, C., «A Time-Of-Flight Depth Sensor-System Description, Issues and Solutions», en Proceedings of the 2004 Conference on Computer Vision and Pattern Recognition Workshop (CVPRW’04), vol. 3, 2004, pp. 35-45.

43. Velten, A., Wilwacher, T., Gupta, O., Veeraraghavan, A., Bawendi, M. G. y Raskar, R., «Recovering Three-Dimensional Shape around a Corner using Ultra-Fast Time-of-Flight Imaging», en Nature Communications, vol. 3, 2012.

44. Lifton, J., Laibowitz, M., Harry, D., Gong, N. W., Mittal, M. y Paradiso, J. A., «Metaphor and Manifestation – Cross Reality with Ubiquitous Sensor/Actuator Networks», en IEEE Pervasive Computing Magazine, vol. 8, n.º 3, julio-septiembre de 2009, pp. 24-33.

45. Laibowitz, M., Gong, N.-W. y Paradiso, J. A., «Multimedia Content Creation using Societal-Scale Ubiquitous Camera Networks and Human-Centric Wearable Sensing», en Proceedings of ACM Multimedia 2010, Florencia, Italia, 25-29 de octubre de 2010, pp. 571-580.

46. Paradiso, J. A., Gips, J., Laibowitz, M., Sadi, S., Merrill, D., Aylward, R., Maes, P. y Pentland, A., «Identifying and Facilitating Social Interaction with a Wearable Wireless Sensor Network», en Springer Journal of Personal & Ubiquitous Computing, vol. 14, n.º 2, febrero de 2010, pp. 137-152.

47. Laibowitz, M., Gong, N.-W. y Paradiso, J. A., op. cit, pp. 571-580.

48. Reben, A. y Paradiso, J. A., «A Mobile Interactive Robot for Gathering Structured Social Video», en Proceedings of ACM Multimedia 2011, octubre de 2011, pp. 917-920.

49. Gillian, N., Pfenninger, S., Russell, S. y Paradiso. J. A., «Gestures Everywhere: A Multimodal Sensor Fusion and Analysis Framework for Pervasive Displays», en Proceedings of The International Symposium on Pervasive Displays (PerDis ‘14), Sven Gehring (ed.), Nueva York, ACM, junio de 2014, pp. 98-103.

50. Bletsas, M., «The MIT Media Lab’s Glass Infrastructure: An Interactive Information System», en IEEE Pervasive Computing, febrero de 2012, pp. 46-49.

51. Greenberg, S., Marquardt, N., Ballendat, T., Díaz-Marino, R. y Wang, M., «Proxemic interactions: the new ubicomp?», en ACM Interactions, vol. 18, n.º 1, enero de 2011, pp. 42-50.

52. Gong, N.-W., Laibowitz, M. y Paradiso, J. A., «Dynamic Privacy Management in Pervasive Sensor Networks», en Proceedings of Ambient Intelligence (AmI) 2010, Málaga, España, 25-29 de octubre de 2010, pp. 96-106.

53. Dublon, G., «Beyond the Lens: Communicating Context through Sensing, Video, and Visualization», tesis de máster, MIT Media Lab, septiembre de 2011.

54. Mayton, B. D., Dublon, G., Palacios, S. y Paradiso, J. A., «TRUSS: Tracking Risk with Ubiquitous Smart Sensing», en IEEE SENSORS 2012, Taipéi, Taiwán, octubre de 2012.

55. Sinha, A. y Chandrakasan, A., «Dynamic Power Management in Wireless Sensor Networks», en IEEE Design & Test of Computers, marzo-abril de 2001, pp. 62-74.

56. Paradiso, J. A. y Starner, T., «Energy Scavenging for Mobile and Wireless Electronics», en IEEE Pervasive Computing, vol. 4, n.º 1, febrero de 2005, pp. 18-27.

57. Boyle, E., Kiziroglou, M., Mitcheson, P. y Yeatman, E., «Energy Provision and Storage for Pervasive Computing», en IEEE Pervasive Computing, octubre-diciembre de 2016.

58. Mitcheson, P. D., Green, T. C., Yeatman E. M. y Holmes, A. S., «Architectures for Vibration-Driven Micropower Generators», en Journal of Microelectromechanical Systems, vol. 13, n.º 3, junio de 2004, pp. 429-440.

59. Ramadass, Y. K. y Chandrakasan, A. P., «A Batteryless Thermoelectric Energy-Harvesting Interface Circuit with ٣٥mV Startup Voltage», en Proceedings of ISSCC 2010, 2010, pp. 486-488.

60. Nishimoto, H., Kawahara, Y. y Asami, T., «Prototype Implementation of Wireless Sensor Network Using TV Broadcast RF Energy Harvesting», en UbiComp’10, 26-29 de septiembre de 2010, Copenhague, Dinamarca, pp. 373-374.

61. Smith, J. R., Sample, A., Powledge, P., Mamishev, A. y Roy, S., «A Wirelessly Powered Platform for Sensing and Computation», en UbiComp 2006: Eighth International Conference on Ubiquitous Computing, Orange County, California, 17-21 de septiembre de 2006, pp. 495-506.

62. Bainbridge, R. y Paradiso, J. A., «Wireless Hand Gesture Capture Through Wearable Passive Tag Sensing», en Proceedings of BSN2011, Dallas, Texas, 23-25 de mayo de 2011, pp. 200-204.

63. Park, R. L., Voodoo Science: The Road from Foolishness to Fraud, Oxford, Oxford University Press, 2001.

64. Warneke, B., Last, M., Liebowitz, B. y Pister, K. S. J., «Smart Dust: Communicating With a Cubic-Millimeter Computer», en IEEE Computer, vol. 34, n.º 1, enero de 2001, pp. 44-51.

65. Lee, Y., «Ultra-Low Power Circuit Design for Cubic-Millimeter Wireless Sensor Platform», tesis doctoral, University of Michigan (Departamento de Ingeniería Eléctrica), 2012.

66. Overbyte, D., «Reaching for the Stars, Across 4.37 Light-Years», en New York Times, 12 de abril de 2016.

68. Mozer, M., «The Neural Network House: An Environment that Adapts to Its Inhabitants», en Proceedings of the American Association for Artificial Intelligence Spring Symposium on Intelligent Environments, Menlo Park, California, 1998, pp. 110-114.

69. Paradiso, J. A., Dutta, P., Gellerson, H. y Schooler, E. (eds.), «Special Issue on Smart Energy Systems», en IEEE Pervasive Computing Magazine, vol. 10, n.º 1, enero-marzo de 2011.

70. Feldmeier, M. y Paradiso, J. A., «Personalized HVAC Control System», en Proceedings of Internet of Things 2010, Tokio, Japón, del 26 de noviembre al 1 de diciembre de 2010.

71. Ibid.

72. Chabanis, G., «Self-Powered Wireless Sensors in Buildings: an Ideal Solution for Improving Energy Efficiency while Ensuring Comfort to Occupant», en Proceedings Of Energy Harvesting & Storage Europe 2011, IDTechEx, 21 y 22 de junio de 2011.

73. Aldrich, M., Zhao, N. y Paradiso, J. A., «Energy Efficient Control of Polychromatic Solid-State Lighting Using a Sensor Network», en Proceedings SPIE (OP10) 7784, San Diego, California, 1-5 de agosto de 2010.

74. Aldrich, M., «Experiential Lighting—Development and Validation of Perception-based Lighting Controls», tesis doctoral, MIT Media Lab, agosto de 2014.

75. Zhao, N., Aldrich, M., Reinhart, C. F. y Paradiso, J. A., «A Multidimensional Continuous Contextual Lighting Control System Using Google Glass», documento elaborado para su presentación en la conferencia 2nd ACM International Conference on Embedded Systems for Energy-Efficient Built Environments (BuildSys 2015), noviembre de 2015.

76. Axaria, A., «INTELLIGENT AMBIANCE: Digitally Mediated Workspace Atmosphere, Augmenting Experiences and Supporting Wellbeing», tesis de máster, MIT Media Lab, agosto de 2016.

77. Levis, P., Madden, S., Polastre, J., Szewczyk, R., Whitehouse, K., Woo, A., Gay, D., Hill, J., Welsh, M., Brewer, E. y Culler, D., «TinyOS: An Operating System for Sensor Networks», en Ambient Intelligence, Berlín, Springer, 2005, pp. 115-148.

78. Gakstatter, E., «Finally, a List of Public RTK Base Stations in the U.S.», en GPS World, 7 de enero de 2014.

80. Elnahrawy, E., Li, X. y Martin, R., «The Limits of Localization Using Signal Strength: A Comparative Study», en Proceedings of the 1st IEEE International Conference on Sensor and Ad Hoc Communications and Networks, Santa Clara, California, octubre de 2004.

81. Maróti, M., Kusy, B., Balong, G., Völgyesi, P., Nadás, A., Molnár, K., Dóra, S. y Lédeczi, A., «Radio Interferometric Geolocation», en Proceedings of ACM SENSYS 2005, noviembre de 2005, pp. 1-12.

82. Belloni, F., Ranki, V., Kainulainen, A. y Richter, A., «Angle-based Indoor Positioning System for Open Indoor Environments», en Proceedings of WPNC, 2009.

83. Greenberg, S., Marquardt, N., Ballendat, T., Díaz-Marino, R. y Wang, M., op. cit, pp. 42-50.

84. Mayton, B. D., Zhao, N., Aldrich, M., Gillian, N. y Paradiso, J. A., «WristQue: A Personal Sensor Wristband», en Proceedings of the IEEE International Conference on Wearable and Implantable Body Sensor Networks (BSN’13), 2013, pp. 1-6.

85. Bolt, R., «“Put-that-there”: Voice and Gesture at the Graphics Interface», en ACM SIGGRAPH Computer Graphics, vol. 14, n.º 3, julio de 1980, pp. 262-270.

86. Froehlich, J., Larson, E., Gupta, S., Cohn, G., Reynolds, M. y Patel, S., «Disaggregated End-Use Energy Sensing for the Smart Grid», en IEEE Pervasive Computing, enero-marzo de 2010, pp. 28-39.

87. Cohn, G., Morris, D., Patel, S. y Tan, D. S., «Your Noise is My Command: Sensing Gestures Using the Body as an Antenna», en Proceedings of CHI 2011, 7-12 de mayo de 2011, pp. 791-800.

88. Gupta, S., Chen, K.-Y., Reynolds, M. S. y Patel, S., «LightWave: Using Compact Fluorescent Lights as Sensors», en Proceedings of UbiComp’11, 2011, pp. 65-70.

89. Chung, J., Donahoe, M., Schmandt, C., Kim, I.-J., Razavai, P. y Wiseman, M., «Indoor Location Sensing Using Geo-Magnetism», en Proceedings of MobiSys’11, del 28 de junio al 1 de julio de 2011, Bethesda, Maryland, pp. 141-154.

90. Zhao, N., Dublon, G., Gillian, N., Dementyev, A. y Paradiso, J. A., «EMI Spy: Harnessing Electromagnetic Interference for Low-Cost, Rapid Prototyping of Proxemic Interaction», documento presentado en la International Conference on Wearable and Implantable Body Sensor Networks (BSN ‘15), junio de 2015.

91. Gong, N.-W., Hodges, S. y Paradiso, J. A., «Leveraging Conductive Inkjet Technology to Build a Scalable and Versatile Surface for Ubiquitous Sensing», en Proceedings of UbiComp’11, 2011, pp. 45-54.

92. Paradiso, J. A., Lifton, J. y Broxton, M., «Sensate Media–Multimodal Electronic Skins as Dense Sensor Networks», en BT Technology Journal, vol. 22, n.º 4, octubre de 2004, pp. 32-44.

93. Dementyev, A., Kao, H.-L. y Paradiso, J. A., «SensorTape: Modular and Programable 3D-Aware Dense Sensor Network on a Tape», en Proceedings of ACM UIST, 2015.

94. Gong, N.-W., Wang, C.-Y. y Paradiso, J. A., «Low-cost Sensor Tape for Environmental Sensing Based on Roll-to-roll Manufacturing Process», en IEEE SENSORS 2012, Taipéi, Taiwán, octubre de 2012.

95. Qi, J., Hong A. y Paradiso J. A., «Crafting Technology with Circuit Stickers», en Proceedings of

the 14th International Conference/Interaction Design and Children (IDC ‘15), 2015, pp. 438-441.

99. Russell, S. y Paradiso, J. A., «Hypermedia APIs for Sensor Data: A Pragmatic Approach to the Web of Things», en Proceedings of ACM Mobiquitous 2014, Londres, Reino Unido, diciembre de 2014, pp. 30-39.

101. Ramsay, D., «LearnAir: toward Intelligent, Personal Air Quality Monitoring», tesis de máster, MIT Media Lab, agosto de 2016.

102. Mittal, M. y Paradiso, J. A., «Ubicorder: A Mobile Device for Situated Interactions with Sensor Networks», en IEEE Sensors Journal, vol. 11, n,º 3, Special issue on Cognitive Sensor Networks, 2011, pp. 818-828.

103. McLuhan, M., Understanding Media: The Extensions of Man, Nueva York, McGraw-Hill, 1964.

104. Lifton, J., Laibowitz, M., Harry, D., Gong, N. W., Mittal, M. y Paradiso, J. A., «Metaphor and Manifestation—Cross Reality with Ubiquitous Sensor/Actuator Networks», en IEEE Pervasive Computing Magazine, vol. 8, n.º 3, julio-septiembre de 2009, pp. 24-33.

105. Véase, por ejemplo, Marquardt, N., Gross, T., Carpendale, S. y Greenberg, S., «Revealing the Invisible: Visualizing the Location and Event Flow of Distributed Physical Devices», en Proceedings of the Fourth International Conference on Tangible, Embedded, and Embodied Interaction (TEI’10), 2010, pp. 41-48.

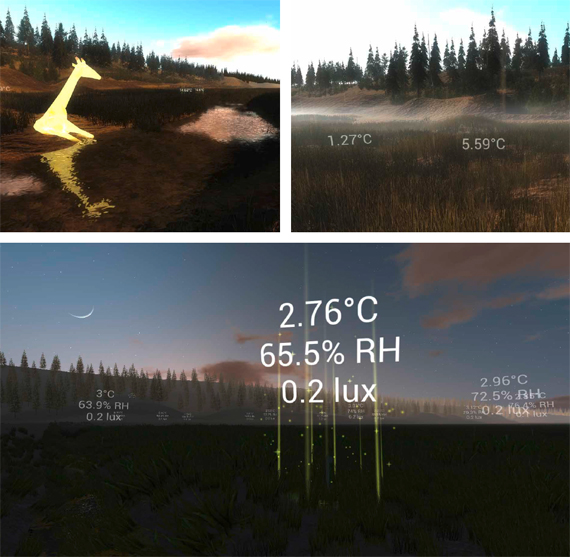

106. Lifton, J. y Paradiso, J. A., «Dual Reality: Merging the Real and Virtual», en Proceedings of the First International ICST Conference on Facets of Virtual Environments (FaVE), LNICST, vol. 33, Berlín, Alemania, Springer, 27-29 de julio de 2009, pp. 12-28.

107. Dublon, G., Pardue, L. S., Mayton, B. D., Swartz, N., Joliat, N., Hurst, P. y Paradiso, J. A., «DoppelLab: Tools for Exploring and Harnessing Multimodal Sensor Network Data», en Proceedings of IEEE Sensors 2011, Limerick, Irlanda, octubre de 2011.

108. Dublon, G. y Paradiso, J. A., «How a Sensor-Filled World Will Change Human Consciousness», en Scientific American, julio de 2014, pp. 36-41.

109. Joliat, N., Mayton, B. D. y Paradiso, J. A., «Spatialized Anonymous Audio for Browsing Sensor Networks Via Virtual Worlds», en The 19th International Conference on Auditory Display (ICAD) (actas de la conferencia), Lodz, Polonia, julio de 2013, pp. 67-75.

111. Duhart, C., «Ambient Sound Recognition» (cap. 8), en Toward Organic Ambient Intelligences—EMMA, tesis doctoral, Université du Havre, Francia, junio de 2016.

112. Lynch, E. y Paradiso, J. A., «SensorChimes: Musical Mapping for Sensor Networks», en Proceedings of the NIME 2016 Conference, Brisbane, Australia, 11-15 de julio de 2016.

113. Russell, S., Dublon, G. y Paradiso, J. A., «HearThere: Networked Sensory Prosthetics Through Auditory Augmented Reality», en Proceedings of the ACM Augmented Human Conference, Ginebra, Suiza, febrero de 2016.

114. Lynch, E. y Paradiso, J. A., op. cit.

115. Cherston, J., Hill, E., Goldfarb, S. y Paradiso, J. A., «Musician and Mega-Machine: Compositions Driven by Real-Time Particle Collision Data from the ATLAS Detector», en Proceedings of the NIME 2016 Conference, Brisbane, Australia, 11-15 de julio de 2016.

116. Teixeira, T., Dublon, G. y Savvides, A., «A Survey of Human-Sensing: Methods for Detecting Presence, Count, Location, Track, and Identity», en ACM Computing Surveys, vol. 5, n.º 1, 2010, pp. 59-69.

117. Paradiso, J. A., Heidemann, J. y Zimmerman, T. G., «Hacking is Pervasive», en IEEE Pervasive Computing, vol. 7, n.º 3, pp. 13-15, julio-septiembre de 2008.

118. Negroponte, N., Being Digital, Nueva York, Knopf, 1995.

119. Mann, S., «Wearable Computing: A First Step Toward Personal Imaging», en IEEE Computer, febrero de 1997, pp. 25-32.

120. Starner, T., «The Challenges of Wearable Computing, Parts 1 & 2», en IEEE Micro, vol. 21, n.º 4, julio de 2001, pp. 44-67.