Mirar al futuro puede dar mucho vértigo, especialmente cuando nos falta información sobre algunas de las disciplinas que prometen una transformación más radical: la genética, la inteligencia artificial o la robótica van a rediseñar nuestro mundo, y será en un plazo más corto que largo. Pero, ¿qué podemos esperar de la sociedad del futuro? A veces es difícil pensar en el mañana sin dejarnos llevar por la influencia de los relatos de ciencia-ficción. ¿Dónde está la frontera? ¿Hasta dónde hemos llegado ya con la tecnología?

En esta práctica obra hemos seleccionado una veintena de expertos internacionales especialistas en algunas de las disciplinas más punteras, para analizar con su ayuda cómo será la transformación tecnológica y a qué campos de nuestra vida afectará: sociedad, ética, medicina, arte… Atrévete a dar el siguiente paso y dale la bienvenida a la vida exponencial con el libro “El próximo paso: la vida exponencial”.

- Habrá una “cuarta edad” (después de la tercera). Osea, que seremos cada vez más longevos. Las fronteras de la ancianidad se desplazan. Así lo asegura el gerontólogo Aubrey De Grey (SENS Research Foundation): es posible revertir el envejecimiento gracias a la biotecnología. Más información +

- Prepárate para convivir con los robots “blandos-inteligentes”. Los nuevos materiales inteligentes permitirán desarrollar una robótica que podrá interaccionar con el ser humano más fácilmente. Esta es la propuesta del profesor Jonathan Rossiter (Universidad de Bristol). Más información +

- Viviremos en un planeta con sistema nervioso electrónico propio, según el profesor Joseph A. Paradiso (MIT Media Lab). La proliferación de sensores dará lugar a un sistema omnisciente que cambiará nuestra percepción del entorno. Más información +

- Es necesaria una nueva definición de inteligencia, ahora que la inteligencia artificial avanza a una velocidad pasmosa. ¿Podremos distinguir entre humanos y máquinas con las herramientas actuales? Kevin Warwick y Huma Shah (Coventry University) explican un famoso experimento con el Test de Turing. Más información +

- ¿Podrá exigir un robot los derechos de autor de su obra? Descubre la respuesta del investigador Ramón López de Mántaras (Instituto de Investigación en Inteligencia Artificial, IIIA) sobre la “creatividad computacional” y los robots como entidades creativas en sí mismos. Más información +

- La llegada de los medios de comunicación “omnipresentes” es lo que pronostican Jay David Bolter (Georgia Institute of Technology, Atlanta, EEUU) y María Engberg (Universidad de Malmö): la “re-mediación” de los medios tradicionales gracias a unas nuevas tecnologías que les permitirán convertirse en ubicuos. Más información+

- La realidad aumentada también es un arte, o al menos, los artistas tienen mucho que decir en los procesos creativos, según sostiene la investigadora y artista Helen Papagiannis. Más información +

- Las emulaciones de cerebro o EMS dominarán la tierra. Robin Hanson (George Mason University) mantiene que en algún momento del próximo siglo la inteligencia artificial dará lugar a la quinta revolución: todas las áreas de nuestra vida diaria se verán radicalmente transformadas. Más información +

Retrato de todos los autores citados en este artículo. Todos participan en el libro “El próximo paso: la vida exponencial” de BBVA OpenMind

- Inteligencia artificial sí, pero solo a nuestro favor. Esta es la tesis que defiende el profesor Stuart Russell (University of California): necesitamos un nuevo enfoque de análisis de la Inteligencia artificial para controlar que su desarrollo solamente buscará nuestro beneficio y no constituirá un riesgo en sí mismo. Más información +

- “Flexiseguridad” es lo que necesitaremos el día de mañana para regular el acceso a los derechos y prestaciones que actualmente vinculamos a la actividad laboral. ¿Qué vamos a hacer cuando los robots trabajen por nosotros? A esa pregunta puede responder el profesor Darrell M. West (Brookings Institution). Más información +

- Dile adiós a tu banco, al menos tal y como lo conoces hoy. Francisco González (Presidente de BBVA) sabe bien que la transformación digital es un proceso ineludible para el sector financiero. ¿Es posible una banca sin bancos? Más información +

- Un mundo sin dinero: un sistema universal de abonos y deudas sustituirá según Chris Skinner (Financial Services Club) a los actuales sistemas de intercambios monetarios y de valor. ¿A qué daremos valor en la sociedad del futuro? ¿Seremos capaces de olvidarnos del valor del dinero? Más información +

- ¿Estamos preparados para la discriminación genética? Steven Monroe Lipkin (Weill Cornell Medical College) cree que secuenciar el genoma de un país entero puede ser muy útil para prevenir y curar enfermedades pero, esta gestión puede ser un arma de doble filo: ¿podré contratar un seguro si tengo una enfermedad genética? Más información +

- Una nueva especie humana “sostenible” y muy tech. Esa es la solución que propone S. Matthew Liao (New York University) para frenar el cambio climático. Podemos actuar sobre nuestro entorno (con una serie de riesgos) o sobre nosotros mismos, y mejorar como especie gracias a la tecnología para convertirnos en habitantes más sostenibles. Más información +

- ¡Respeta mi cerebro! Esta frase puede convertirse según la tesis que sostiene James Giordano (Universidad de Georgetown) en una reclamación pertinente si en el futuro la neurociencia sigue avanzando cada vez más rápido y no nos preocupamos de establecer una neuroética adecuada. Más información +

- La prehistoria del futuro somos nosotros. Para Luciano Floridi (Universidad de Oxford) la cuarta revolución cambiará nuestro mundo tan drásticamente que nosotros seremos a nuestros nietos lo que las últimas tribus del Amazonas son a la sociedad actual: la última generación histórica organizada, en este caso, en Estados. Más información +

- El futuro tecnológico es más seguro que el presente, o al menos, esa podría ser la conclusión derivada de los argumentos de Seán Ó hÉigeartaigh (Centre for the Study of Existential Risk, CSER), que sostiene que hasta ahora hemos estado expuestos a grandes riesgos (armas nucleares) y que en el futuro, sin embargo, la tecnología que viene también proveerá soluciones. Más información +

- Una evolución poshumana más allá de la Tierra. Martin Rees (Institute of Astronomy) cree que será posible una colonización extraterrestre por parte de una especie humana mejorada genéticamente. Sin duda, para el ex presidente de la Royal Society, el siglo en el que vivimos será el más trascendental desde que existe nuestro planeta. Más información +

Dory Gascueña para OpenMind

https://www.bbvaopenmind.com/imprescindible-18-ideas-clave-para-mirar-al-futuro/

El cerebro sensorial aumentado. Cómo conectarán los humanos con el internet de las cosas

Del mismo modo que Vannevar Bush vaticinó los entornos multimedia, el ordenador personal y tantas cosas más en su influyente artículo de 1945,(1) Mark Weiser predijo el internet de las cosas en un artículo de similar trascendencia publicado en 1991.(2) Mientras que el artículo de Bush, que se basaba en extrapolaciones a partir de la tecnología de la Segunda Guerra Mundial, tenía sobre todo un carácter especulativo, Weiser ilustraba el futuro que estaba prediciendo mediante sistemas realmente funcionales que él o sus colegas habían desarrollado (y con los que ya convivían) en Xerox PARC. Con una perspectiva que partía de la interacción persona-ordenador (IPO), Weiser y su equipo analizaban la manera en la que las personas interactuarían con la computación en red distribuida por su entorno y los artefactos que las rodeaban. Aunque ya eclipsada por el llamado «internet de las cosas», gestado en fechas mucho más recientes en instalaciones industriales/académicas apasionadas de la tecnología de la identificación por radiofrecuencia (RFID, por sus siglas en inglés), en plena evolución, la visión de Weiser de una «computación ubicua» encontró aceptación entre muchos de los que entonces trabajábamos en el área de la ciencia computacional relacionada con la interacción humana. Incluso dentro de nuestra misma comunidad y antes de que se impusiera el término «internet de las cosas» (IdC), esta visión podía adoptar muchos nombres y matices a medida que las diferentes facciones intentaban consolidar su propia marca (en el Media Lab lo llamábamos «cosas que piensan» [en inglés, con el juego de palabras «things that think»], mis colegas del Laboratorio de Ciencia Computacional del MIT lo denominaron Project Oxygen, otros «computación omnipresente», «computación ambiental», «ordenador invisible», etcétera), pero sus raíces seguían en la visión primigenia de Mark de lo que a menudo abreviamos como «UbiComp» (por «computación ubicua»).

Fachada del edificio Ray and Maria State Center del Instituto Tecnológico de Massachusetts (MIT, por sus siglas en inglés), obra del premio Pritzker de arquitectura Frank Gehry

Cuando me incorporé al MIT Media Lab en 1993, era un físico especialista en alta energía que trabajaba en detectores de partículas elementales (que se pueden considerar «sensores» extremos) en el entonces recién cancelado Supercolisionador Superconductor y en el Gran Colisionador de Hadrones del CERN, que daba sus primeros pasos. Dado que tenía facilidad por la electrónica ya desde niño y que había estado diseñando y fabricando grandes sintetizadores de música desde principios de la década de 1970,(3) mi primera investigación en el Media Lab implicó la incorporación de nuevas tecnologías en sensores a dispositivos novedosos de interfaz persona-ordenador, que en muchos casos se empleaban para el control de la música.(4) A medida que las tecnologías inalámbricas ganaban en facilidad de integración, el trabajo de mi grupo de investigación desplazó su atención, a finales de la década de 1990, hacia varios aspectos de los sensores inalámbricos y las redes de sensores, siempre con un enfoque antropocéntrico.(5) En la actualidad observamos que la mayor parte de nuestros proyectos sondean vías por las cuales la percepción y las intenciones humanas se puedan conectar de un modo continuo con ese «sistema nervioso» electrónico cuya presencia se consolida a nuestro alrededor. Este artículo aborda la esencia de este tema desde la perspectiva de los sensores, a través de proyectos de mi grupo de investigación que ilustran el modo en que las revoluciones en la capacidad de detección están transformando la conexión del ser humano con su entorno por muchas vías distintas.

Sensores inerciales y prendas inteligentes

Las personas notan la reacción inercial y gravitacional a través de la propiocepción de los miembros y el sentido vestibular del oído interno. Su equivalente electrónico lo constituyen los sensores inerciales, antes empleados para aplicaciones de alto nivel como la navegación aérea y espacial,(6) pero que ahora son ya un bien de consumo. Los acelerómetros basados en sistemas microelectromecánicos (MEMS, por sus siglas en inglés) se remontan a prototipos académicos de 1989 y a chips comerciales procedentes de Analog Devices, de uso extendido en la década siguiente(7) y que, gracias a su técnica exclusiva, les permitía aunar MEMS y electrónica en un solo chip. Todavía demasiado toscos para aplicaciones de navegación más allá de la podometría básica(8) o la navegación a estima por pasos,(9) se están introduciendo en muchos productos de consumo sencillos, como juguetes, teléfonos y dosímetros y sensores de desplazamiento deportivos (en los cuales sirven sobre todo para detectar la actividad) o para interfaces basadas en la inclinación, como al girar una pantalla. De hecho, el acelerómetro es quizás el sensor de uso genérico más extendido del mercado en la actualidad, y estará integrado en casi cualquier dispositivo sujeto a movimiento o vibración, aunque solo sea temporal, para después dejar paso a sensores más elaborados de muy baja tensión (un área que exploramos hace mucho tiempo).(10), (11) Los giroscopios basados en MEMS han avanzado mucho más allá de los originalmente fabricados por el Draper Lab(12) en la década de 1990. Estos también se han consolidado, pero sus elevados costes y su mayor consumo eléctrico (al necesitar un resonador interno con alimentación no han podido bajar de un consumo de corriente del orden de 1 mA y son difíciles de ajustar a un ciclo de trabajo eficiente, ya que tardan un tiempo significativo en arrancar y estabilizarse)() les impiden en gran medida penetrar en el mercado en estos momentos. Sin embargo, se están generalizando en los smartphones, los visores de realidad aumentada, las cámaras e incluso los relojes y las pulseras de gama alta, con fines de detección de gestos, detección de rotación, compensación del movimiento, detección de la actividad, aplicaciones de realidad aumentada, etcétera. Se suelen combinar con magnetómetros que indican la orientación real respecto al terreno a partir del campo magnético del planeta. En cuanto a los acelerómetros triaxiales, están ya presentes por defecto y también ha habido giroscopios triaxiales en producción. Por añadidura, desde 2010 hemos asistido a la aparición de productos comerciales que efectúan las funciones de ambos y proporcionan así una unidad de medición inercial en seis ejes en un solo chip, junto a un magnetómetro en tres ejes (empezando, por ejemplo, por el MPU-6000/6050 de InvenSense, seguido por dispositivos más recientes de esta misma empresa o de STMicroelectronics, Honeywell, etcétera).(14)

El MIT Media Lab ha sido pionero en aplicaciones de sensores inerciales para interfaces de usuario y sensores ponibles(15), y muchas de estas ideas se gestaron en mi grupo hace 20 años.(16) Desde hace una década, aprovechando un proyecto todavía más antiguo que exploraba los sensores inalámbricos ponibles para bailarines,(17) mi equipo ha utilizado sensores de inercia que se llevan puestos para medir los parámetros biomecánicos de los jugadores profesionales de béisbol, en colaboración con médicos del Massachusetts General Hospital.(18) Dado que los atletas pueden efectuar enormes rangos de movimiento, debemos ser capaces de medir las actividades máximas de hasta 120 G y 13.000 °/s, sin dejar de contar con una resolución significativa dentro del rango de movimiento normal de 10 G y 300 °/s. En última instancia, esto implicaría una unidad de medida inercial (UMI) con sensibilidad logarítmica, pero, como todavía no las hay disponibles, hemos integrado componentes inerciales de doble rango en nuestro dispositivo y hemos mezclado ambas señales mediante matemática. Empleamos la conexión de radio, sobre todo, para sincronizar nuestros dispositivos con una tasa de muestreo superior a nuestra tasa de 1 ms y escribimos los datos de continuo en una memoria flash extraíble, lo que nos permite recoger los datos de todo un día de mediciones y analizarlos para determinar las características descriptivas y predictivas del rendimiento atlético.(19) Está surgiendo un sinfín de productos comerciales destinados a recoger datos de actividad atlética en todo un abanico de deportes, desde el béisbol hasta el tenis,(20) y en el futuro incluso los atletas aficionados irán equipados de dispositivos ponibles que les ayudarán a controlar su entrenamiento de un modo automático, individualizado o aumentado.

La potencia de los acelerómetros también ha descendido muchísimo: contamos ya con acelerómetros capacitivos de tres ejes que consumen menos de 1 mA y con acelerómetros de uso especializado (por ejemplo, dispositivos diseñados de origen para mecanismos implantables)(21) con consumos inferiores a 1 μA. Los acelerómetros piezoeléctricos pasivos también han encontrado aplicación en el campo de la computación ubicua.(22)

También se han introducido varios tipos de sensores en los tejidos y la ropa. Pese a que la monitorización de la salud y el ejercicio han sido los principales polos de atracción de los científicos a este campo,(23) se han desarrollado indicadores de tensión sobre tejido, sensores de doblado, sensores de presión, electrodos bioeléctricos, sensores táctiles capacitivos e, incluso, antenas de RFID cada vez más fiables y robustas,(24) lo que ha convertido la ropa en un escenario importante del trabajo en interfaces de usuario. Algunos proyectos recientes de gran notoriedad, como el proyecto Jacquard de Google,(25) bajo el liderazgo técnico de Nan-Wei Gong, exmiembro de mi equipo de investigación, sugieren con rotundidad que la fabricación electrónica de tejido y ropa inteligentes evolucionará hasta superar nichos de mercado restringidos y exclusivos y se generalizará a medida que empiecen a surgir aplicaciones generales, quizás centradas en nuevos tipos de interacción.(26) Asimismo, investigadores de todo el mundo, como mi colega Yoel Fink,(27) del MIT, están replanteándose la naturaleza de lo que hoy entendemos como «hilo» para convertirlo en una fibra de silicona sobre la cual desarrollar la microelectrónica. Consciente de la infinidad de obstáculos que aún quedan en términos de robustez, producción, etcétera, la comunidad investigadora se está movilizando(28) para transformar estas y otras ideas relativas a la electrónica flexible en sustratos funcionales radicalmente nuevos con un impacto potencial en la medicina, la moda y la vestimenta (desde el ocio hasta los trajes espaciales y los entornos militares o peligrosos) e introducir la electrónica en todos los objetos elásticos o maleables.

Más allá de los sistemas ponibles se sitúa la electrónica instalada directamente o incluso pintada sobre la piel. Una reciente investigadora posdoctoral de mi grupo, Katia Vega, es pionera en esta tecnología, encarnada en lo que denomina «tecnología de la belleza».(29) Mediante el uso de maquillaje funcional que toma datos de conductores, sensores y actuadores de iluminación o cambio de color,(30) Katia y sus colegas han elaborado interfaces dérmicas que reaccionan ante los gestos faciales o táctiles y envían mensajes, se iluminan o cambian el color aparente de la piel con un colorete electroactivo. Últimamente, Katia ha explorado aplicaciones médicas, como tatuajes que pueden cambiar de aspecto en función de indicadores transportados por la sangre.(31)

Vivimos en una era que ha empezado a sacar partido a nuestras muñecas desde un punto de vista técnico, como atestiguan los relojes inteligentes ya generalizados. Sin embargo, estos dispositivos suelen consistir en periféricos con pantalla táctil conectados a un smartphone o funcionan como monitores de actividad mejorados como los ya presentes en el mercado desde 2009. Considero que la muñeca adquirirá un papel clave para la interfaz de usuario del futuro, pero no del modo aplicado en los relojes inteligentes de hoy. Es decir, las interfaces del usuario sacarán partido de las UMI en la muñeca y de una localización precisa en interiores para procesar los gestos y señalar:(32) los gestos con los dedos seguirán siendo importantes para la comunicación (puesto que el dedo humano tiene una gran capacidad sensorial y motora), pero en lugar de usar pantallas táctiles detectaremos los gestos dactilares desde sensores integrados en pulseras inteligentes, sin necesidad de mover los brazos. En los últimos años, mi equipo ha desarrollado varios prototipos iniciales de trabajo que lo consiguen. Uno, mediante sensores de RFID pasivos en anillos que se llevan en la articulación distal de los dedos y se monitorizan desde un lector de muñeca,(33) otro mediante una cámara 3D de corto alcance que escruta la palma de la mano, desde la muñeca hasta los dedos,(34) y otro que se sirve de una muñeca que genera imágenes por presión y que puede detectar el desplazamiento de los tendones.(35) Mi pupilo Artem Dementyev y su colaboradora Cindy Kao también han convertido un panel táctil inalámbrico en una uña falsa, dotada de una batería que le permite varias horas de uso continuado(36) y que posibilita la interacción digital en, valga la redundancia, las puntas de los dedos. Por consiguiente, imagino que las personas del futuro, de camino al trabajo en un atestado autobús con piloto automático, no irán con la cabeza gacha mirando su smartphone, sino al frente, al dispositivo que llevan puesto en la cabeza, mientras navegan por sus comunicaciones (en gran medida adaptadas al contexto) gracias al movimiento de los dedos, con ambos brazos inmóviles y pegados al cuerpo.

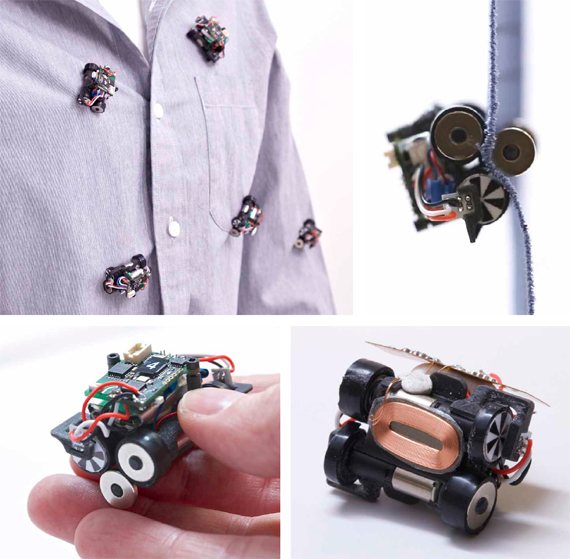

Junto a mi antiguo alumno Mat Laibowitz, introdujimos el concepto de movilidad parásita hace más de una década.(37) Planteábamos que unos nodos sensores de baja potencia podrían recolectar movilidad, y no solo energía, en su entorno, saltando de un agente en movimiento a otro. En la actual era de drones desplegados desde furgonetas de reparto, dicho concepto dista de ser radical. Nuestros ejemplos convertían a las personas en agentes móviles, mientras que los nodos eran pequeños robots que podían «agarrarse» a un individuo de varias maneras (inspirados en las pulgas y las garrapatas, entre otros seres del mundo animal), para después apearse en el lugar de su elección. En época reciente, mi actual pupilo Artem Dementyev, junto a Sean Follmer de Stanford y otros colaboradores, han introducido un enfoque pionero sobre los robots ponibles en sus Rovables.(38) Se trata de robots muy pequeños (por ejemplo, de unos 2 cm) que navegan por la ropa de un usuario y eligen la localización idónea para llevar a cabo una tarea, que puede ir desde la toma de datos médicos a las emisiones visuales dinámicas. Este proyecto propone una forma extrema de colaboración muy estrecha entre persona y robot que podría tener profundas repercusiones.

Cámaras omnipresentes y sensores ubicuos

En 1984, de Orwell,(39) era el gobierno del totalitario Gran Hermano el que ponía las cámaras de vigilancia en cada televisor, pero en la realidad de 2016 son las empresas de electrónica de consumo las que integran cámaras en los receptores de televisión corrientes y en todos los dispositivos móviles. De hecho, las cámaras se están convirtiendo en un bien de consumo habitual y, a medida que se reduzca el consumo de la extracción de características por vídeo mediante un hardware específico y otros sensores de micropotencia determinen la necesidad de tomar una imagen, se harán todavía más comunes como soportes de sensores genéricos integrados. Los primeros chips comerciales CMOS para cámara totalmente integrados procedían de la empresa VVL (que ahora pertenece a STMicroelectronics), de Edimburgo, a principios de la década de 1990.(40) En ese momento, la densidad en píxeles era reducida (valga el ejemplo del VVL Peach con 312 x 287 píxeles) y la principal aplicación comercial de sus dispositivos era la BarbieCam, una videocámara de juguete que vendía Mattel. Fui uno de los primeros usuarios de estas cámaras digitales, que empleé en 1994 para un sistema multicámara de alineamiento de precisión en el Supercolisionador Superconductor.(41) El sistema evolucionó hasta convertirse en el hardware empleado para alinear de un modo continuo y con una precisión de micras el sistema de muones de 40 metros del detector ATLAS del Gran Colisionador de Hadrones del CERN. Esta tecnología estaba bien posicionada para un crecimiento rápido y, hoy en día, las cámaras integradas nos miran desde todas partes, desde los ordenadores portátiles hasta los teléfonos móviles, con resoluciones típicas de montones de megapíxeles, y son responsables de una difusión cada vez más masiva de la fotografía digital. Los circuitos integrados de aplicación específica (CIAE) dedicados al procesamiento básico de imágenes suelen estar integrados o encastrados en las cámaras, lo que aporta una capacidad creciente de procesamiento de vídeo acompañada de un consumo eléctrico en reducción continua. El mercado de los teléfonos móviles ha sido la fuerza impulsora de este empeño, pero cada vez más las instalaciones estáticas (sensores de movimiento, contexto o gestualidad basados en vídeos y situados en casas inteligentes) y la realidad aumentada constituirán una importante aplicación de consumo. Asimismo, la consiguiente necesidad de procesamiento de imágenes integrado supondrá una reducción de la potencia consumida y un incremento de su agilidad. Somos ya testigos de ello en niveles extremos, como en las Microsoft HoloLens recién sacadas al mercado, dotadas de seis cámaras, la mayor parte de las cuales se emplean para un mapeo rápido del entorno, el seguimiento de la ubicación y el registro de imágenes; todo ello en una unidad independiente de realidad aumentada que se lleva en la cabeza, es ligera y está alimentada por batería. Las cámaras 3D también lo están invadiendo todo y se abren paso en el mercado de masas a través de la Microsoft Kinect, creada hace media década alrededor de la luz estructurada. Por otra parte, las cámaras 3D basadas en el denominado «tiempo de vuelo» (cuyos pioneros en los CMOS a principios de los años 2000 fueron los investigadores de Canesta)(42) han evolucionado hasta desplazar, en los últimos tiempos, a los enfoques fundamentados en la luz estructurada. Por su parte, los desarrolladores de todo el mundo se apresuran a reducir lo suficiente el consumo y el volumen de estos dispositivos para integrarlos en los dispositivos móviles corrientes (una versión muy pequeña de este tipo de dispositivos ya se ha integrado en las HoloLens). A medida que se gane precisión en la medición de la velocidad de los píxeles, las aplicaciones que cuentan fotones en la fotografía computacional, como aquellas en las que trabaja mi colega Ramesh Raskar, del Media Lab, prometen dar lugar a nuevas aplicaciones revolucionarias y capaces de, por ejemplo, reducir el nivel de difusión y ver lo que hay a la vuelta de las esquinas.(43)

Mi grupo de investigación empezó a explorar esta introducción de las cámaras ubicuas hace más de una década, con especial atención a aplicaciones que relacionan la información de vídeo con datos simultáneos de sensores ponibles. Nuestros estudios iniciales estaban basados en una plataforma llamada Portals,(44) con unos dispositivos especiales formados por una cámara integrada que transmitía a un procesador híbrido TI DaVinci DSP/ARM, rodeado de un núcleo de sensores básicos (de movimiento, audio, temperatura/humedad y proximidad por infrarrojos) y combinado con un transceptor ZigBee RF. Dispersamos 45 de estos dispositivos por todo el complejo del Media Lab, interconectados por la red por cable del edificio. Sobre esta base creamos la aplicación SPINNER,(45) que etiquetaba los vídeos de cada cámara con los datos de cualquier sensor ponible cercano. El sistema SPINNER se apoyaba en la idea de poder solicitar información a la base de datos de vídeos con parámetros de un nivel superior, utilizando los datos de los sensores para constituir un espacio de información social o afectiva.(46) A partir de este espacio, se intenta formular una petición secuencial de información a modo de narrativa sencilla que implica a sujetos humanos dotados de dispositivos ponibles. Mediante este sistema, los clips de vídeo de grandes bases de datos que contuvieran cientos de horas de metraje se seleccionarían de un modo automático para ajustarse mejor a las horas especificadas en la petición, con lo que producirían vídeos editados que los observadores considerarían coherentes.(47) Este trabajo, que sin quererlo apuntaba al futuro de la telerrealidad, tenía su punto de mira más allá, ya que trataba de permitir que las personas usaran sistemas de sensores mediante peticiones e interacciones relevantes desde el punto de vista humano.

En lugar de intentar extraer historias a partir de la actividad en un ambiente pasivo, un proyecto en el que participó nuestro equipo concibió una cámara interactiva con el objetivo de obtener historias estructuradas a partir de las personas.(48) Con el formato de pequeño robot móvil, Boxie llevaba una cámara HD en uno de sus ojos; deambulaba por nuestro edificio y, si se quedaba atascado, solicitaba ayuda cuando se acercaba alguien. Entonces, mediante una serie de preguntas, pedía a la persona en cuestión que efectuara varias tareas (por ejemplo, trasladarlo a otra parte del edificio o explicarle qué se hace en la zona del edificio en la que ha sido encontrado), de modo que producía un vídeo indexado fácil de editar para conseguir algo así como un documental sobre los individuos que conviven con el robot.

En los próximos años, con la reducción del coste de las pantallas de vídeo de gran superficie (con el potencial de imprimirlas con rodillos) y su mejor integración en redes con capacidad de respuesta, veremos cómo se generaliza el despliegue de pantallas en todos los ámbitos. La información dirigida a nosotros se manifestará de la manera más conveniente (por ejemplo, en unas gafas inteligentes o en una pantalla cercana), de modo que, sin duda alguna, sacarse un teléfono del bolsillo y ejecutar una aplicación pronto será cosa del pasado. Para explorar esta perspectiva, mi equipo inició el proyecto Gestures Everywhere (gestos por doquier),49 que daba uso a los grandes monitores situados sobre todas las zonas públicas de nuestro complejo de edificios.50 Al contar ya con RFID para identificar a los portadores de tarjetas de identificación codificadas, añadimos un conjunto de sensores y una cámara Kinect 3D a cada emplazamiento con pantalla. Cuando alguien se aproximaba a una pantalla, era identificado mediante RFID o reconocimiento por vídeo y la información más relevante sobre este aparecía en pantalla. Desarrollamos un marco de reconocimiento para la cámara Kinect que analizaba con detenimiento algunos gestos genéricos de las manos (por ejemplo, los que indican «siguiente», «con más detalle», «aléjate», etcétera), lo que permitía a los usuarios entablar una interacción básica con sus propios datos sin tocar la pantalla ni tener que sacar un dispositivo móvil del bolsillo. De hecho, las interacciones proxémicas51 alrededor de pantallas inteligentes ubicuas serán comunes en la próxima década.

La plétora de cámaras que diseminamos por nuestro edificio en el transcurso de nuestro proyecto SPINNER despertaron preocupación sobre la privacidad (a este respecto, es interesante que las cámaras Kinect de Gestures Everywhere no suscitaran la misma reacción: o bien los residentes no las consideraban cámaras o bien se estaban haciendo a la idea de la visión ubicua). En consecuencia, instalamos un interruptor de corriente muy visible en cada portal que permitía apagarlas con facilidad. Sin embargo, es una solución muy artificial y, además, en un futuro nuestro entorno cercano sencillamente albergará demasiadas cámaras y sensores invasivos de otro tipo que apagar. Estos dispositivos deben regirse por protocolos seguros y verificables que guíen el flujo de datos de un modo dinámico y adecuado para responder a las exigencias de privacidad del usuario. Diseñamos un pequeño dispositivo inalámbrico que controlaba nuestros portales para estudiar posibles soluciones a estos problemas.(52) Emitía una señal a sus aledaños que desactivaba de un modo dinámico la transmisión de audio y vídeo de las proximidades y otras características derivadas en función de las preferencias de privacidad declaradas por el usuario; el dispositivo contaba con un gran botón de emergencia que se podía pulsar en cualquier momento cuando se deseaba privacidad inmediata, de modo que bloqueaba el audio y el vídeo emitidos por portales cercanos.

En lugar de bloquear toda la emisión de vídeo en directo, hemos probado a eliminar de la imagen de vídeo a la persona que desea privacidad. Mediante la información aportada por sensores ponibles, podemos identificar con mayor facilidad a la persona apropiada en la imagen(53) y fundirla con el fondo de la imagen. También estamos estudiando una iniciativa opuesta: el uso de sensores ponibles para detectar parámetros ambientales que indiquen condiciones de riesgo potencial para los trabajadores de la construcción y renderizarlos (visualizarlos) de diferentes modos sobre una emisión de vídeo en tiempo real, para destacar a los trabajadores en una situación de peligro más aguda.(54)

Gestión de la energía

La energía necesaria para captar y procesar ha descendido de un modo constante. Tanto los sensores en sí como los sistemas con sensores integrados han sacado todo el partido de la electrónica de bajo consumo de potencia y de la gestión inteligente de la potencia.(55) De un modo similar, la microgeneración (o «recolección») de energía, antaño una curiosidad muy innovadora, se ha convertido en un empeño generalizado con ecos a lo largo y ancho de la comunidad de los sensores integrados.(56), (57) El modo apropiado de microgenerar depende en gran medida de la naturaleza de la reserva de energía ambiental. En general, en entornos habitados las celdas solares tienden a ser la mejor elección (proporcionan más de 100 µA/cm2 en interiores, en función de los niveles lumínicos, etcétera). En otros contextos, los microgeneradores por vibración y termoeléctricos se pueden emplear en presencia de niveles suficientes de vibración o transferencia de calor (por ejemplo, en vehículos o sobre el cuerpo),(58), (59) al tiempo que la aplicación de microgeneradores de radiofrecuencias de ambiente(60) ha dejado de ser infrecuente. En la mayoría de aplicaciones prácticas que restringen el volumen y el área superficial, no obstante, una batería integrada puede constituir una mejor solución, a tenor de la vida útil esperada del dispositivo y teniendo en cuenta que la limitada potencia que proporciona el microgenerador puede resultar muy restrictiva para el consumo de corriente de la electrónica. Otra solución consiste en proyectar haces de energía magnética o de radiofrecuencia sobre sensores sin baterías, como en los sistemas de RFID. Popularizados en nuestra comunidad gracias al WISP de Intel(61) (usado por mi equipo para los anteriormente mencionados anillos detectores del movimiento dactilar),(62) empezaron a surgir los sistemas comerciales alimentados por radiofrecuencia (por ejemplo, Powercast, WiTricity, etcétera), aunque cada uno tiene sus lagunas (como una potencia limitada o una elevada densidad del flujo magnético). Hoy en día, de hecho, en los cafés de moda es habitual encontrar «discos» inductivos que, cuando están encima de las bobinas primarias encastradas debajo de la mesa, sirven para cargar los teléfonos móviles; a su vez, algunos teléfonos móviles cuentan con bobinas de carga integradas bajo la carcasa, pero apenas se usan, dado que es más práctico usar un cable/conector USB, que se encuentra en cualquier parte y, a diferencia de los dispositivos inductivos proximales, permite cargar en cualquier posición. En mi opinión, debido a su practicidad perfectible, su alto nivel de desperdicio de energía (de especial relevancia en nuestros tiempos de ahorro) y los potenciales problemas para la salud (sobrevalorados en gran medida,(63) pero más importantes para los portadores de un marcapasos, etcétera), la transferencia inalámbrica de energía se limitará sobre todo a aplicaciones específicas o de baja potencia, como los sensores microenergéticos sin acceso a la luz necesaria para la energía fotovoltaica y, quizás, armarios o estanterías especiales para poner a cargar nuestros dispositivos ponibles en casa.

La popularización del interés por la microgeneración de energía ha precipitado la concepción de un abanico de circuitos integrados dedicados a gestionar y regular las aportaciones instantáneas de energía que estos aparatos suelen producir (por ejemplo, grandes proveedores de circuitos integrados como Linear Technology y Maxim), de modo que tal vez se haga realidad el sueño de integrar en un solo chip la microgeneración, la regulación de potencia, los sensores, el procesamiento y, tal vez, la función inalámbrica (al menos para el funcionamiento con ciclos de trabajo extremadamente reducidos o en entornos con grandes acumulaciones de energía ambiental). De hecho, el sueño de un «polvo inteligente» o smart dust(64) se ha hecho realidad en algunos prototipos iniciales, como el conjunto de obleas creado por la Universidad de Míchigan que emplea la cámara que lleva incorporada como microgenerador óptico de energía.(65) Este campo ganará todavía más importancia con la iniciativa recientemente anunciada de producir los sensores en enjambre, con pesos de alrededor de 1 g y acelerados por láser, para el proyecto Star Wisp, destinado a la exploración interestelar de alta velocidad.(66)

Aunque el público comúnmente a menudo confunde la microgeneración de energía con las fuentes de energía sostenibles,(67) la cantidad de energía microgenerable en entornos habitados convencionales es muy inferior a la necesaria para lograr una verdadera contribución a las necesidades energéticas de la sociedad. Por otra parte, los sistemas de sensores de muy baja potencia, quizás aumentados por la microgeneración energética, minimizan o eliminan la necesidad de cambiar las baterías, de manera que reducen los gastos generales de despliegue y, por tanto, fomentan la penetración de los sensores ubicuos. La información derivada de estos sensores integrados puede, pues, emplearse para minimizar de un modo inteligente el consumo de energía en entornos construidos, lo que promete un grado de conservación y utilidad fuera del alcance de los actuales termostatos y controles de iluminación discretos.

Los trabajos de este tipo, que se remontan a la Smart Home (casa inteligente) de Michael Moser,(68) se han convertido en los últimos tiempos en algo así como el foco de atención de los círculos dedicados a la computación ubicua, ya que varios de los grupos de investigación han emprendido proyectos sobre gestión inteligente y adaptativa de la energía mediante sensores omnipresentes.(69) En mi grupo, por ejemplo, mi entonces pupilo Mark Feldmeier utilizó cantilevers piezoeléctricos de bajo coste basados en chips para crear un detector de actividad de pulsera que integra un dispositivo microenergético (antes de la llegada de las pulseras de ejercicio comerciales) y un monitor ambiental para un controlador de climatización.(70) Más allá de los sistemas comerciales introducidos a posteriori, como el famoso termostato Nest, un dispositivo ponible brinda una perspectiva en primera persona y más directa del confort que un sensor estático colocado en una pared, además de que es móvil por naturaleza, de modo que puede ejercer su control de la climatización en cualquier habitación u oficina habilitada para ello. Gracias al procesamiento analógico, este integrador continuo de actividad funciona a menos de 2 μA, lo que permite a nuestro dispositivo (además de sus otros componentes, que también miden y transmiten la temperatura, la humedad y el nivel lumínico en intervalos de un minuto) funcionar durante más de dos años con una pequeña batería de botón, pese a actualizarse una vez por minuto cuando está dentro del alcance de nuestra red. En esencia, los datos de este dispositivo de pulsera han servido para captar la «sensación de confort» del usuario y adaptar el sistema de climatización de nuestro edificio al confort de las personas presentes en este, en función de lo inferido de los datos procedentes del sensor ponible, discriminados de acuerdo con las etiquetas «caliente» y «frío» procedentes de la pulsación de los botones del dispositivo. Estimamos que el sistema de climatización regido por nuestro sistema consumía cerca del 25% menos de energía y que sus usuarios sentían una mejora significativa del grado de confort.(71) En los últimos tiempos, otros actores, como Schneider Electric, en Grenoble,(72) han desarrollado sensores similares de tipo inalámbrico y microenergético, pero se utilizan en una ubicación fija. La unidad de Schneider, que mide la temperatura, la humedad y los niveles de CO2 minuto a minuto y carga las lecturas mediante una red ZigBee, está alimentada por una pequeña célula solar; un día de luz normal de interior basta para alimentar este dispositivo durante un máximo de cuatro semanas (sin ir más lejos, la duración típica de las vacaciones en Francia).

El control de la iluminación es otra aplicación que puede beneficiarse de la computación ubicua. Pero no solo para la gestión de la energía, también para responder al reto para la interfaz del usuario que plantean los sistemas de iluminación actuales. Pese al sinfín de posibilidades de actuación de los fluorescentes y las luces en estado sólido, por lo general en red y controlados por vía digital, la interfaz humana sufre sus consecuencias, ya que la iluminación (en especial, la comercial) suele estar gestionada por crípticos paneles de control que convierten la selección de la iluminación deseada en una tarea, cuando menos, farragosa. Por consiguiente, echamos en falta la desaparición del sencillo interruptor de la luz, y mi grupo ha iniciado una serie de proyectos encabezados por mi estudiante Nan Zhao y por los exalumnos Matt Aldrich y Asaf Axaria para recuperarlo, aunque en formato virtual. Una de las vías sondeadas implica utilizar el retorno de un pequeño sensor de la luz incidente capaz de aislar la contribución de cada luz próxima a la iluminación total que llega al sensor, así como estimar la luz externa, no sujeta a control.(73) Nuestro algoritmo de control, basado en un sencillo programa lineal, puede efectuar un cálculo dinámico de qué distribución óptima en términos de energía proporcionará la iluminación deseada en la ubicación del sensor. En efecto, representa el regreso del interruptor de luz local encarnado en un pequeño dispositivo inalámbrico.

Nuestro trabajo continuo en esta área lleva la idea más lejos, con la incorporación de cámaras mediante la distribución de sensores de luz reflejada. Asimismo, puede proporcionar funciones que se podrían utilizar para el control interactivo de la iluminación. A partir de un análisis de componentes principales, hemos derivado un conjunto de ejes de control continuo para la iluminación distribuida, adecuados a la percepción humana(74) y que permiten un ajuste fácil e intuitivo de la iluminación en red. Del mismo modo, estamos haciendo funcionar este sistema a partir de los sensores ponibles de las gafas Google Glass, ajustando automáticamente la potencia lumínica para optimizar la iluminación de aquellas superficies y objetos que mira el usuario, así como derivando datos de contexto para la iluminación general; por ejemplo, es posible una transición sin saltos desde la iluminación apropiada para trabajar hasta una iluminación para ocasiones informales o sociales.(75) Nuestro trabajo más reciente en este campo también incorpora grandes pantallas (destinadas a gozar de una presencia ubicua) que modifican tanto sus imágenes o vídeo como su sonido e iluminación para mejorar el estado emocional o de atención del usuario en función de lo que detectan los sensores ponibles y las cámaras cercanas(76) y devolverlo a niveles sanos y productivos.

Radio, ubicación, «rastros» y medios sensibles

La última década ha sido testigo de una enorme expansión de los sensores inalámbricos, con su consiguiente impacto en la actual computación ubicua. Las técnicas de trazado de circuitos impresos de señal mixta han permitido generalizar la integración de radios de silicio en la misma placa que unos procesadores de alta capacidad, lo que ha abierto las puertas a una gran cantidad de circuitos impresos de radio inteligentes y fáciles de usar, que en su mayoría admiten estándares muy extendidos, como ZigBee regido por 802.15.4. Empresas como Nordic, TI/Chipcon y, más recientemente, Atmel, por ejemplo, fabrican dispositivos de uso habitual en esta familia. Pese a que existe una plétora de estándares inalámbricos relevantes para los sensores y que optimizan las diferentes aplicaciones (por ejemplo, ANT para funcionamiento en ciclos de trabajo reducidos, DASH-7 de Savi para la implementación de cadenas de suministros, WirelessHART para el control industrial, Bluetooth Low Energy para dispositivos de consumo, LoRaWAN para dispositivos de IdT de mayor alcance y variantes de wifi de baja potencia), ZigBee puede presumir de una larga trayectoria como estándar de comunicación por radiofrecuencia de baja potencia. Por otra parte, los módulos de sensores equipados con ZigBee son fáciles de conseguir y pueden funcionar con sistemas operativos derivados de la investigación en redes de sensores (tan antiguos, por ejemplo, como TinyOS)(77) o admitir el código de aplicaciones desarrolladas a medida. El funcionamiento multisalto se incluye por defecto en el protocolo de enrutado de ZigBee, pero las limitaciones en términos de batería suelen imponer el uso de fuentes externas de alimentación para los nodos de enrutado. Pese a que podría estar a punto de ser reemplazado por protocolos de desarrollo más reciente (como los anteriormente enumerados), mi equipo ha basado la mayor parte de sus instalaciones ambientales y estáticas en series (pilas) de protocolos ZigBee.

La ubicación en exteriores, con un margen de varios metros, es un campo dominado por el GPS durante mucho tiempo, pero los GPS diferenciales brindan una ubicación más precisa. Estos pronto serán mucho más comunes gracias a dispositivos recientes de bajo coste como las radios RTK (por las siglas en inglés de «cinemática en tiempo real») integradas en dispositivos GPS.78 La ubicación en interiores es otra historia: resulta mucho más complicada, ya que las construcciones desvían la señal del GPS, y los ambientes interiores presentan líneas de visión limitadas y un exceso de trayectorias múltiples. Al parecer no hay una tecnología de ubicación indiscutiblemente superior en todas las situaciones de interior (como atestiguan los resultados de las últimas conferencias IPSN [por las siglas en inglés de «procesamiento de la información en las redes de sensores»] de la Indoor Location Competition [concurso de localización en interiores] que Microsoft celebra cada año),79 pero el creciente esfuerzo de desarrollo que se le dedica deja entrever que la ubicación precisa en interiores pronto será una función habitual de los dispositivos ponibles, móviles y de consumo.

Las redes que funcionan con 802.15.4 (o, en este caso, 802.11) suelen ofrecer una capacidad de ubicación limitada basada en la RSSI (por las siglas en inglés de «intensidad de la señal de recepción») y la calidad del enlace radioeléctrico. Estas técnicas fundamentadas, en esencia, en la amplitud, sufren un nivel de error considerable a causa del comportamiento dinámico y complejo de la radiofrecuencia en interiores. Con información suficiente de múltiples estaciones base y sacando partido del estado anterior y de otras restricciones, se dice que estos sistemas de «huella digital» pueden localizar nodos móviles en interiores con una precisión de hasta 3 o 5 m.(80) Los sistemas de radiofrecuencia basados en el tiempo de vuelo prometen hacerlo mucho mejor. Se ha mostrado que, mediante el uso inteligente de los impulsos de fase diferencial de la radiofrecuencia en radios que transmiten al mismo tiempo en exteriores, se puede localizar una red de nodos eléctricos con una precisión de hasta 3 cm a una distancia de un campo de fútbol americano,(81) mientras que las antenas direccionales consiguen una precisión mínima de cerca de 30 cm con el sistema HAIP de Nokia,(82) por ejemplo. Sin embargo, la tecnología que está ganando terreno en la ubicación precisa y de bajo peso por radiofrecuencia es la banda superancha de baja potencia (UltraWideBand), que consiste en la sincronización precisa de impulsos de radio cortos de 5-8 GHz y que promete una precisión cercana al centímetro. Hace ya algún tiempo que hay disponibles productos comerciales de gama alta (por ejemplo, Ubisense para la ubicación en interiores y las radios de Zebra Technologies para la ubicación en instalaciones del tamaño de un estadio deportivo), pero los nuevos chipsets de empresas como DecaWave y Qualcomm (mediante su radio Peanut, en proceso de evolución) indican que esta tecnología pronto podría estar presente en todo. A su vez, la posibilidad futura de poder localizar con un margen de error de algunos centímetros tendrá repercusiones profundas (como ejemplos evidentes tenemos el geoperimetraje y las interfaces(83) de proximidad, pero esta capacidad influirá en todo).

Un ejemplo aportado por Brian Mayton, miembro de mi equipo, a partir de esta tecnología, era la pulsera WristQue.(84) Dotada de: 1) un sistema preciso de ubicación en interiores (mediante Ubisense), 2) una unidad de medida inercial completa en nueve ejes y 3) sensores para aplicar los sistemas de iluminación y climatización inteligentes anteriormente explicados. WristQue permite también el control de dispositivos, para lo que basta señalarlos y hacer un gesto con el brazo. Señalar algo es un modo intuitivo de comunicación humana y ha sido objeto de estudio por los sistemas basados en cámaras desde que se desarrolló el sistema antiguo Put That There (pon eso allí) en el MIT Media Lab durante la década de 1980.(85) No obstante, como WristQue conoce la posición de la muñeca con una precisión de centímetros gracias a la ubicación por radio (que pronto será ubicua) y el ángulo de la muñeca gracias a la UMI (calibrada para adaptarse a la distorsión magnética local), podemos extrapolar con facilidad el vector del brazo para determinar qué señala un usuario, sin necesidad de cámaras.

Las diferentes ubicaciones muestran también marcas electromagnéticas características o «rastros», que se pueden detectar mediante unos sencillos sensores capacitivos, inductivos, ópticos y de radiofrecuencia. Estas marcas proceden de las emisiones parásitas de las líneas eléctricas y de varias emanaciones locales de la iluminación modulada corriente y de otros equipos eléctricos. Asimismo, el cableado y la estructura de los edificios pueden influir en estas señales. Estas señales de fondo son portadoras de información relevante sobre el consumo de energía y el contexto (por ejemplo, qué aparato está haciendo qué y cuánta corriente está consumiendo), así como sobre la ubicación (dado que estas emanaciones de campo cercano o de radio limitado se atenúan enseguida). Los sistemas que explotan estas señales pasivas de fondo, por lo general mediante un proceso de aprendizaje automático informatizado, se han puesto últimamente de moda en la investigación en computación ubicua, con aplicaciones en campos como la gestión no intrusiva de cargas eléctricas,(86) el seguimiento de manos a través de los muros(87) y la inferencia de gestos alrededor de lámparas fluorescentes.(88) Los sensores magnéticos de corriente continua también se han empleado para ubicar con precisión a personas dentro de edificios, ya que la orientación espacial del campo magnético terrestre cambia de un modo notable en función de la posición en el edificio.(89)

Mi equipo se ha servido del uso de ruido electrónico de ambiente en dispositivos ponibles para analizar las características de un captador de acoplamiento capacitivo y, de este modo, identificar qué dispositivos se tocan e inferir sus modos de funcionamiento.(90) Nan-Wei Gong, entonces mi pupila, y yo mismo (en colaboración con Microsoft Research en el Reino Unido) desarrollamos un suelo-sensor electromagnético multimodal con los captadores y los circuitos básicos impresos mediante rodillos, un procedimiento poco costoso.(91) Las celdas detectoras en red presentes en cada franja podían hacer un seguimiento de las personas que caminan sobre ellas mediante la inducción capacitiva de un zumbido de ambiente de 60 Hz, así como trazar la ubicación de un teléfono GSM activo o de un transmisor de campo cercano, gracias a sus emanaciones. Este es un ejemplo reciente de lo que hemos denominado medios sensibles:(92) en esencia, la integración de redes de sensores de baja potencia en materiales comunes para otorgarles capacidades sensoriales, es decir, una «piel electrónica» con potencial de mejora. Nuestro trabajo más reciente en este campo ha producido la Sensor Tape,(93) un rollo de sensores integrados y en red sobre un sustrato flexible en forma de cinta adhesiva común. Aunque nuestra cinta sensora tiene muchos metros de largo, puede desenrollarse, cortarse y volver a empalmarse como sea necesario, así como adherirse a un objeto o superficie a voluntad para servir de sensor (nuestra cinta actual integra dispositivos como UMI y sensores de proximidad a un paso de cerca de 1 pulgada para distribuir su orden y orientación). También hemos probado a fabricar una cinta sensora con capacidad de utilizar sensores impresos y recibir alimentación pasiva,(94) lo que le permite la adhesión a superficies inaccesibles y materiales de construcción, para después recuperar la información por vía inalámbrica mediante lectores de comunicación de campo cercano (NFC, por sus siglas en inglés). Cuando los sensores no se pueden imprimir, también se pueden aplicar como pegatinas con un adhesivo conductor, como las creadas en primicia por mi estudiante Jie Qi y el graduado del Media Lab Andrew Bunnie Huang para aplicaciones educativas y de manualidades(95) con sus kits Chibitronics disponibles para su venta al público.

Agregar y visualizar datos de sensores diversos

Hemos sido testigos del auge de la circulación de datos de sensores en tiempo real por nuestras redes. Del mismo modo, la rápida expansión de los sensores inteligentes a todas las escalas no debería tardar en propiciar el predominio de la información de sensores en tiempo real en el tráfico de red. En estos momentos, la información de estos sensores está bastante compartimentada; por ejemplo, el vídeo se usa en las videoconferencias, la telefonía y las webcams, los datos de tráfico se muestran en las webs de tráfico, etcétera. Uno de los principales desafíos al que se enfrenta nuestra comunidad es derribar los muros entre estos nichos y desarrollar sistemas y protocolos que conecten, sin fisuras, estas categorías para formar un entorno virtual de sensores en el cual todos los datos relevantes se combinen y fusionen de modo dinámico. Son varias las iniciativas que han empezado a tantear estas ideas de unificación de datos. Los sistemas basados en SensorML, Home Plug & Play y DLNA, por ejemplo, se han orientado a facilitar la transmisión de datos entre varias aplicaciones. Pachube (ahora Xively)(96) es un sistema exclusivo que permite a sus suscriptores subir sus datos a un amplio fondo común que, a continuación, puede ponerse a disposición de muchas aplicaciones diferentes. No obstante, estos protocolos adolecen de un éxito limitado por varias razones, como el afán de poseer todos los datos de uno y ponerles precio o la falta de aceptación entre los fabricantes. Algunas iniciativas recientes, como AllJoyn,(97) liderada por Qualcomm, o la alianza entre Open Interconnect (lanzada por Intel) e IoTivity,(98) tienen su punto de mira más centrado en el internet de las cosas y menos dominado por la electrónica de consumo. En lugar de esperar a que maduren estos protocolos un tanto farragosos, mi pupilo Spencer Russell ha desarrollado el nuestro, denominado CHAIN-API.(99), (100) CHAIN es un sistema de tipo RESTful (por las siglas en inglés de «transferencia de estado representacional») que reconoce la web y está basado en estructuras de datos JSON, de modo que es fácil de escrutar mediante herramientas en general disponibles para las aplicaciones web. Una vez que accede a internet, los datos del sensor se cuelgan en la red, se describen y se enlazan con otros datos de sensores en CHAIN. A través de CHAIN, las aplicaciones pueden recolectar datos procedentes de los sensores del mismo modo que hoy en día recopilan información estática de la red. Así, los datos relacionados entre sí pueden descentralizarse y residir en varios servidores (considero que en un futuro no habrá una única entidad «poseedora» de nuestros datos, porque estarán repartidos). Los recolectores surcarán sin cesar los datos enlazados en protocolos como CHAIN, calculando el estado y estimando otros parámetros derivados de los datos, lo que será a su vez subido en CHAIN como otro «sensor virtual». A modo de ejemplo, mi pupilo David Ramsay ha puesto en práctica un sistema llamado LearnAir,(101) en el cual ha empleado CHAIN para desarrollar un protocolo para cargar datos desde sensores de calidad del aire y conformar un marco de aprendizaje automático. Este sistema corrige, calibra y extrapola dichos datos mediante la correcta combinación de: 1) datos ubicuos procedentes de sensores de bajo coste y 2) parámetros medidos a escala general que puedan influir en su estado (por ejemplo, la información meteorológica), fundamentando el resultado con datos de sensores de alta calidad (por ejemplo, con certificación EPA) que dependen de su proximidad. Gracias al auge de la ciencia ciudadana en los últimos años, sensores de varios niveles de calidad recogerán datos de todo tipo y en todas partes. En lugar de llegar a conclusiones potencialmente erróneas a partir de datos engañosos, LearnAir apunta a un futuro en el cual datos de todo tipo y de calidad variable se combinarán de un modo dinámico y bien regulado para permitir a las personas contribuir a un cuerpo abierto y común de datos que incorpore todos los datos del modo más adecuado.

Los navegadores correspondientes a los datos de sensores ubicuos y multimodales desempeñarán un papel de primer orden, por ejemplo, en la configuración y depuración de estos sistemas y en la gestión de edificios o instalaciones. En todo caso, una capacidad de búsqueda ágil sobre datos de sensores multimodales promete la llegada de aplicaciones nuevas y revolucionarias sobre las que apenas podemos especular en este momento. Una interfaz adecuada para este sistema de sensores artificiales apunta a la creación de algo así como una omnisciencia digital, que puede aumentar en gran medida la consciencia de una persona en términos temporales y espaciales. Sería, pues, una interesante puesta en práctica de los medios electrónicos que McLuhan caracterizaba como una extensión del sistema nervioso humano.

Denominamos este proceso Cross Reality(104) o realidad cruzada, es decir, un entorno omnipresente y aumentado en todos los aspectos, en el cual los datos de sensores se manifiestan con fluidez en mundos virtuales en los que se puede navegar de un modo intuitivo. Pese a que algunos investigadores se han dedicado a añadir sus datos de sensores a estructuras observables mediante Google Earth,(105) nosotros hemos usado el motor de un juego en 3D para navegar por los datos procedentes de nuestro propio edificio. Dado que los motores de juegos están concebidos para brindar eficiencia en los gráficos, la animación y la interacción, se adaptan a la perfección al desarrollo de este tipo de sensores cuya labor se enmarca en edificios (nuestro trabajo anterior utilizaba el entorno comunitario de realidad compartida SecondLife,(106) lo que resultaba muy restrictivo en relación con nuestros objetivos).

Nuestro actual sistema, denominado DoppelLab,(107) bajo la dirección de mi estudiante Gershon Dublon, visibiliza centenares de diversos sensores y fuentes de información relacionados con nuestro edificio a través de animaciones que aparecen en un mundo virtual común. Al navegar en DoppelLab podemos observar el funcionamiento del sistema de climatización del edificio, ver cómo se desplazan las personas por el edificio (gracias a las tarjetas con RFID y los sensores de movimiento), leer los mensajes públicos de Twitter que envían desde sus despachos e, incluso, ver en tiempo real los partidos de tenis de mesa que se juegan en una mesa virtual.(108) Asimismo, hemos incorporado a DoppelLab la navegación auditiva, que genera fuentes de audio espacializadas; es decir, proceden de micrófonos situados por todo nuestro edificio y se identifican de acuerdo con la posición del usuario en el edificio virtual. Por razones de privacidad, algunas pequeñas partículas sonoras (granos) aleatorias se invierten o se borran directamente en el nodo sensor, lo que hace que las conversaciones resulten imposibles de interpretar (siempre suena como si se hablara en una lengua extranjera), pero los efectos vocales, las risas, el ruido de los grandes grupos y los ruidos por el paso de personas (por ejemplo, los avisos de los ascensores, la gente que abre puertas, etcétera) se transmiten casi intactos.109 Ejecutar DoppelLab con un audio espacializado de este tipo otorga al usuario la sensación de ser un fantasma, anclado a la realidad de un modo vago y tentador, con la impresión y las sensaciones de estar allí, pero ajeno a sus detalles. Como niño criado a finales de la década de 1960, en tiempos de McLuhan, este concepto me fascinaba, de manera que, siendo escolar ya conecté una serie de micrófonos situados a cientos de metros de distancia de los mezcladores y amplificadores de mi cuarto. Por aquel tiempo, a pesar de la gran influencia de las películas de espías entonces de moda, no tenía ninguna intención de fisgar en los asuntos de los demás. Sencillamente me fascinaba la idea de generalizar la presencia e integrar el sonido exterior remoto en mezclas estéreo dinámicas de ambiente que más tarde escucharía durante horas y horas. DoppelLab y el entorno DoppelMarsh descrito a continuación han elevado este concepto a un nivel que nunca habría podido concebir en mi analógica juventud.

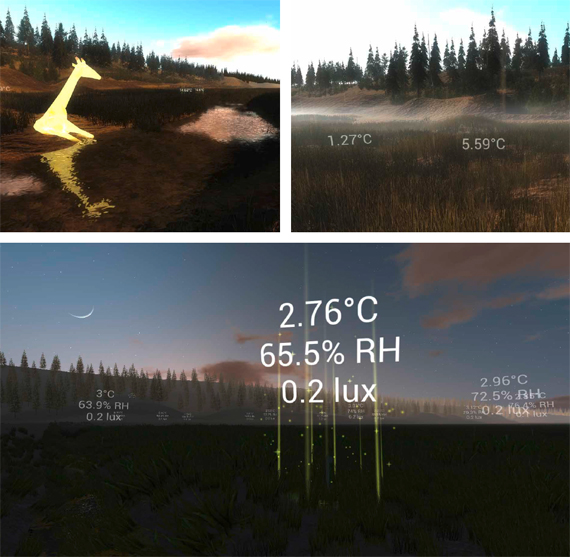

Renders de Don Derek Haddad del paisaje virtual de Tidmarsh hechos con la aplicación DoppelMarsh, que muestra datos de sensores en tiempo real a modo de texto superpuesto, densidades de lluvia y niebla virtuales que replican la sensación atmosférica (arriba a la derecha), un animal virtual «alimentándose» de datos generados por sensores para ilustrar visualmente el historial del entorno (arriba a la izquierda) y un nodo sensor que sube datos al atardecer (abajo)

Teníamos planeado hacer evolucionar DoppelLab por muchos caminos tangenciales; por ejemplo, por la vía de la interacción bidireccional que permite a los visitantes virtuales manifestarse también en nuestro espacio real de diferentes maneras mediante pantallas y actuadores distribuidos. Sin embargo, en su mayor parte, nuestros actuales esfuerzos en esta línea de investigación se han desplazado al exterior, a una ciénaga sin uso de unas 240 hectáreas antes dedicadas a los arándanos, llamada Tidmarsh y situada en Plymouth, Massachusetts, una hora al sur del MIT.(110) Se está restaurando este terreno para recuperar su estado natural como humedal y, para documentar el proceso, hemos instalado centenares de sensores inalámbricos que miden una serie de parámetros, como la humedad, la temperatura, la conductividad y la humedad del suelo, los movimientos cercanos, la calidad atmosférica y del agua, el viento, el sonido, la calidad de la luz, etcétera. Con nuestro protocolo inalámbrico de baja potencia derivado de ZigBee y cargando la información en CHAIN, estos sensores, diseñados por mi pupilo Brian Mayton, tienen una duración de dos años con pilas AA (enviando datos cada 20 segundos) o infinita cuando se alimentan mediante una pequeña célula solar. También contamos con 30 fuentes de audio en tiempo real a partir de una serie de micrófonos distribuidos por Tidmarsh, con los cuales estamos explorando nuevas aplicaciones de audio espacializado, reconocimiento de animales salvajes en tiempo real mediante aprendizaje profundo,(111) etcétera.

Además de emplear este rico y denso archivo de datos para analizar el progreso de la recuperación del paraje en colaboración con científicos ecólogos, también usamos el flujo de datos en tiempo real colgados en CHAIN para crear una visualización valiéndonos del motor de un juego. En el marco de este DoppelMarsh, un usuario puede flotar a través de un paisaje virtual resintetizado (actualizado automáticamente mediante la información recogida por las cámaras, de modo que la apariencia virtual se adapte a los cambios estacionales y climáticos del mundo real) y ver la información de los sensores encarnada en gráficos, animaciones y música relativos a la ubicación. Los sonidos de DoppelMarsh proceden tanto de los micrófonos instalados (configurados en el espacio de acuerdo con la posición virtual del usuario) como de la música generada por los datos de los sensores (por ejemplo, los dispositivos cercanos nos comunican con voz la temperatura, la humedad, la actividad, etcétera). Hemos desarrollado un sistema para componer música sobre los datos de Tidmarsh(112) y, hasta ahora, hemos organizado cuatro mapeos musicales, que pronto serán más.

Mediante nuestro Tidmarsh virtual hemos creado una nueva vía para sentir a distancia el paisaje real sin renunciar a parte de la estética real. En DoppelMarsh se puede flotar por terreno pantanoso que hasta ahora era muy difícil de transitar (y sin sufrir las picaduras de insectos, antes aseguradas), oyendo lo que captan los micrófonos cercanos y viendo animaciones metafóricas procedentes de sensores en tiempo real (incluida la flora y la fauna que proporcionan datos a determinados sensores, de manera que su apariencia y comportamiento reflejan el historial de temperatura, humedad, etcétera, en esa área). Asimismo, estamos desarrollando una «prótesis sensorial» para aumentar la experiencia de visitantes a la finca Tidmarsh. Gracias al desarrollo de HearThere,(113) un sistema de auriculares que detecta la posición/orientación por conducción ósea, estimaremos dónde o sobre qué están centrando su atención los usuarios, gracias a un abanico de sensores ponibles, y amplificaremos de un modo apropiado el sonido de los micrófonos o sensores relacionados o cercanos. Cuando miran hacia la orilla opuesta de un riachuelo, por ejemplo, los usuarios pueden oír el audio de los micrófonos y sensores situados en la otra orilla, pero si vuelven la vista hacia el agua oirán el sonido de los hidrófonos y sensores sumergidos en ella; es más, si centran la vista en un tronco equipado con acelerómetros sensibles, podrán incluso oír cómo los insectos agujerean su interior. En el futuro, todas la interfaces de usuario utilizarán así la atención: la información pertinente se nos presentará del modo más adecuado y se basará en nuestro foco de atención para mejorar la percepción y no distraernos.

Creo que los artistas están desempeñando un papel crucial a la hora de determinar cómo se nos presenta el mundo aumentado. En la actualidad podemos disponer, en cualquier parte, de grandes fuentes de datos procedentes de la vida cotidiana, y cada vez es más fácil obtener las herramientas para darles una estructura. En semejante contexto, artistas, compositores y diseñadores esculpirán los entornos y las realizaciones que nos brindan esta información para crear una obra relevante para el ser humano. De hecho, un mantra habitual ahora en mi grupo de investigación es que «el big data (obtención y análisis de datos masivos) es el lienzo para los artistas del futuro», cosa que hemos ilustrado mediante los marcos de creación musical disponibles tanto con los datos de DoppelMarsh(114) como con los datos físicos en tiempo real procedentes del detector ATLAS del Gran Colisionador de Hadrones del CERN.(115) Vislumbro un futuro cercano en el que un compositor pueda crear una pieza a partir de una ciudad inteligente, cuyo tráfico, meteorología, calidad del aire, flujo de peatones, etcétera, se traduzcan en una música que cambie en función de las condiciones y la ubicación de su usuario virtual. Se trata de constructos creativos interminables, siempre cambiantes y que se pueden percibir como algo relacionado con elementos reales que existen en lugares reales, lo que les otorga inmediatez e importancia.

Conclusiones

Durante la última década, la ley de Moore ha democratizado en enorme medida la tecnología de los sensores. El presente capítulo ha abordado algunos de los muchísimos modos de detectar a los humanos y sus actividades.(116) Cada vez son más numerosos los sensores integrados en productos de uso corriente (basta con ver los teléfonos móviles, que se han convertido en las navajas suizas del mundo del sensor y la radiofrecuencia) y el movimiento DIY también ha permitido que los módulos de sensores personalizados sean fáciles de fabricar o comprar a partir de muchos puntos de venta en línea o colaborativos.(117) En consecuencia, esta década ha sido testigo de un ingente incremento de datos diversos que afluyen a la red. Sin duda, esta tendencia continuará en los años futuros y nos planteará el gran reto de sintetizar dicha información por muchas vías, como los grandes motores de contexto basados en la nube, los sensores virtuales y el aumento artificial de la percepción humana. Estos avances no solo prometen abrir la puerta a una verdadera computación ubicua, sino que también apuntan a una redefinición radical de cómo sentimos la realidad y que hará que la actual división de nuestra atención entre los teléfonos móviles y el mundo real parezca pintoresca y arcaica.

Entramos en un mundo en el cual la información de sensores ubicuos del espacio que nos rodea se propagará por varios niveles de lo que hoy denominamos «la nube», para después proyectarse sobre nuestro entorno físico y lógico a modo de información contextual que guiará los procesos y las aplicaciones que se manifiesten a nuestro alrededor. No nos sacaremos los teléfonos del bolsillo para desviar nuestra atención hacia una interfaz de usuario táctil, más bien encontraremos la información distribuida entre dispositivos que llevaremos puestos y pantallas de ambiente de nuestro alrededor. Los ordenadores se convertirán antes en un compañero que en la experiencia derivada de ejecutar una aplicación. En sus escritos de hace décadas, mi colega Nicholas Negroponte, fundador y director del Media Lab, describió esta relación como la de un «mayordomo electrónico».(118) A día de hoy, la veo como una prolongación de nosotros mismos y no como la encarnación de un «otro». Nuestra relación con la computación será mucho más íntima a medida que se materialice el reinado de los dispositivos ponibles. En estos momentos, toda la información está a nuestro alcance en dispositivos que nos rodean, basta el toque de un dedo o pronunciar una frase. Pronto llegará directa a nuestros ojos y oídos cuando entremos en la era de los dispositivos ponibles (algo que ya previeron a mediados de la década de 1990 los entonces estudiantes del Media Lab Steve Mann(119) y Thad Starner,(120) que vivían en una versión anticipada de este mundo). Esta información estará regida por el contexto y la atención, no por la petición directa, y en gran medida será precognitiva, al presentarse antes de que formulemos preguntas directas. De hecho, en este futuro las fronteras del individuo serán muy difusas. Los humanos hemos ido forzando estos límites desde los albores de la sociedad. Primero compartíamos información mediante la historia oral, luego nuestros horizontes mentales se ampliaron con la escritura y, después, con la imprenta, que eliminaba la necesidad de retener de memoria la información textual y nos permitía, en su lugar, recurrir a señales para navegar por archivos más grandes. En el futuro, cuando vivamos y aprendamos en un mundo profundamente surcado por redes de dispositivos ponibles y, en última instancia, implantables, la manera en que nuestra esencia e individualidad se repartirá entre las neuronas orgánicas y aquello en lo que se haya convertido el ecosistema de información planteará una frontera fascinante que promete redefinir la humanidad.

Agradecimientos

El trabajo del MIT Media Lab que se describe en el presente capítulo ha sido obra de mis estudiantes de doctorado, investigadores posdoctorales y colaboradores visitantes a lo largo de la última década. Muchos han sido citados por su nombre de un modo explícito en este texto y otros figuran en los artículos y tesis mencionados. Animo al lector a consultar las referencias facilitadas para acceder a más información sobre estos proyectos, acompañada de una explicación más concienzuda del trabajo relacionado. Mi agradecimiento a los patrocinadores del MIT Media Lab por su apoyo a estos esfuerzos.

Notas

1. Bush, V., «As We May Think», en Atlantic Monthly, n.º 176, julio de 1945, pp. 101-108.

2. Weiser, M., «The Computer for the 21st Century», en Scientific American, vol. 265, n.º 3, septiembre de 1991, pp. 66-75.

3. Paradiso, J. A., «Modular Synthesizer», en Stocker, G. y Schopf, C. (eds.), Timeshift (Actas de Ars Electronica, 2004), Ostfildern-Ruit, Alemania, Hatje Cantz Verlag, 2004, pp. 364-370.

4. Paradiso, J. A., «Electronic Music Interfaces: New Ways to Play», en IEEE Spectrum, vol. 34, n.º 12, diciembre de 1997, pp. 18-30.

5. Paradiso, J. A., «Sensor Architectures for Interactive Environments», en Deleaney, K. (ed.), Augmented Materials & Smart Objects: Building Ambient Intelligence Through Microsystems Technologies, cap. 16, Springer, 2008, pp. 345-362.

6. MacKenzie, D., Inventing Accuracy: a Historical Sociology of Nuclear Missile Guidance, Cambridge, Massachusetts, The MIT Press, 1990.

7. Walter, P. L., «The History of the Accelerometer» (ed. rev.), en Sound and Vibration, enero de 2007, pp. 84-92.

8. Weinberg, H., «Using the ADXL202 in Pedometer and Personal Navigation Applications», en Analog Devices Application Note AN-602, Analog Devices Inc., 2002.

9. Renaudin, V., Yalak, O. y Tomé, P., «Hybridization of MEMS and Assisted GPS for Pedestrian Navigation», en Inside GNSS, enero-febrero de 2007, pp. 34-42.

10. Malinowski, M., Moskwa, M., Feldmeier, M., Laibowitz, M. y Paradiso, J. A., «CargoNet: A Low-Cost MicroPower Sensor Node Exploiting Quasi-Passive Wakeup for Adaptive Asychronous Monitoring of Exceptional Events», en Proceedings of the 5th ACM Conference on Embedded Networked Sensor Systems (SenSys’07), Sídney, Australia, 6-9 de noviembre de 2007, pp. 145-159.

11. Benbasat, A. Y. y Paradiso. J. A., «A Framework for the Automated Generation of Power-Efficient Classifiers for Embedded Sensor Nodes», en Proceedings of the 5th ACM Conference on Embedded Networked Sensor Systems (SenSys’07), Sídney, Australia, 6-9 de noviembre de 2007, pp. 219-232.

12. Bernstein, J., «An Overview of MEMS Inertial Sensing Technology», en Sensors Magazine, 1 de febrero de 2003.

13. Benbasat, A. Y. y Paradiso. J. A., op. cit, pp. 219-232.

14. Ahmad, N., Ghazilla, A. R., Khain, N. M. y Kasi, V., «Reviews on Various Inertial Measurement (IMU) Sensor Applications», en International Journal of Signal Processing Systems, vol. 1, n.º 2, diciembre de 2013, pp. 256-262.

15. Verplaetse, C., «Inertial Proprioceptive Devices: Self-motion-Sensing Toys and Tools», en IBM Systems Journal, vol. 35, n.º 3-4, 1996, pp. 639-650.

16. Paradiso, J. A., «Some Novel Applications for Wireless Inertial Sensors», en Proceedings of NSTI Nanotech 2006, vol. 3, Boston, Massachusetts, 7-11 de mayo de 2006, pp. 431-434.

17. Aylward, R. y Paradiso, J. A., «A Compact, High-Speed, Wearable Sensor Network for Biomotion Capture and Interactive Media», en Proceedings of the Sixth International IEEE/ACM Conference on Information Processing in Sensor Networks (IPSN 07), Cambridge, Massachusetts, 25-27 de abril de 2007, pp. 380-389.

18. Lapinski, M., Feldmeier, M. y Paradiso, J. A., «Wearable Wireless Sensing for Sports and Ubiquitous Interactivity», en IEEE Sensors 2011, Dublín, Irlanda, 28-31 de octubre de 2011.

19. Lapinski, M. T., «A Platform for High-Speed Biomechanical Data Analysis using Wearable Wireless Sensors», tesis doctoral, MIT Media Lab, agosto de 2013.

20. Lightman, K., «Silicon Gets Sporty: Next-Gen Sensors Make Golf Clubs, Tennis Rackets, and Baseball Bats Smarter Than Ever», en IEEE Spectrum, marzo de 2016, pp. 44-49.

21. Para un ejemplo temprano, véase la ficha técnica del Analog Devices AD22365.

22. M. Feldmeier y Paradiso, J. A., «Personalized HVAC Control System», en Proceedings of Internet of Things 2010, Tokio, Japón, del 26 de noviembre al 1 de diciembre de 2010.

23. De Rossi, D. y Lymberis, A. (eds.), «IEEE Transactions on Information Technology», en Biomedicine, Special Section on New Generation of Smart Wearable Health Systems and Applications, vol. 9, n.º 3, septiembre de 2005.

24. Buechley, L., «Material Computing: Integrating Technology into the Material World», en Price, S., Jewitt, C. y Brown, B. (eds.), The SAGE Handbook of Digital Technology Research, Sage Publications Ltd., 2013.

25. Poupyrev, I. Gong, N.-W., S., Fukuhara, M. E., Karagozler, Schwesig, C. y Robinson, K., «Project Jacquard: Interactive Digital Textiles at Scale», en Proceedings of CHI 2016, 7-12 de mayo de 2016, pp. 4.216-4.227.

26. Vinge, V., Rainbow’s End, Nueva York, Tor Books, 2006.

27. Hou, C., Jia, X., Wei, L., Tan, S.-C., Zhao, X., Joanopoulos, J. D. y Fink, Y., «Crystalline Silicon Core Fibres from Aluminium Core Performs», en Nature Communications, vol. 6, febrero de 2015.

28. Chandler, D. L., «New Institute Will Accelerate Innovations in Fibers and Fabrics», en MIT News, 1 de abril de 2016.

29. Vega, K., Beauty Technology: Designing Seamless Interfaces for Wearable Computing, Cham, Suiza, Springer, 2016.

30. Liu, X., Vega, K., Maes, P. y Paradiso, J. A., «Wearability Factors for Skin Interfaces», en Proceedings of the 7th Augmented Human International Conference 2016 (AH ‘16), Nueva York, ACM, 25-27 de febrero de 2016.

31. Vega, K., Jing, N., Yetisen, A., Kao, V., Barry, N. y Paradiso, J. A., «The Dermal Abyss: Interfacing with the Skin by Tattooing Biosensors», documento de trabajo para la conferencia TEI 2017.

32. Mayton, B. D., Zhao, N., Aldrich, M., Gillian, N. y Paradiso, J. A., «WristQue: A Personal Sensor Wristband», en Proceedings of the IEEE International Conference on Wearable and Implantable Body Sensor Networks (BSN’13), 2013, pp. 1-6.

33. Bainbridge, R. y Paradiso, J. A., «Wireless Hand Gesture Capture Through Wearable Passive Tag Sensing», en International Conference on Body Sensor Networks (BSN’11), Dallas, Texas, 23-25 de mayo de 2011, pp. 200-204.

34. Way, D. y Paradiso, J. A., «A Usability User Study Concerning Free-Hand Microgesture and Wrist-Worn Sensors», en Proceedings of the 2014 11th International Conference on Wearable and Implantable Body Sensor Networks (BSN ‘14), IEEE Computer Society, junio de 2104, pp. 138-142.

35. Dementyev, A. y Paradiso, J. A., «WristFlex: Low-Power Gesture Input with Wrist-Worn Pressure Sensors», en Proceedings of UIST 2014, the 27th annual ACM symposium on User interface software and technology, Honolulu, Hawái, octubre de 2014, pp. 161-166.

36. Kao, H.-L., Dementyev, A., Paradiso, J. A. y Schmandt, C., «NailO: Fingernails as Input Surfaces», pendiente de publicación en las Actas de la International Conference on Human Factors in Computing Systems (CHI’15), Seúl, Corea del Sur, abril de 2015.

37. Laibowitz, M. y Paradiso, J. A., «Parasitic Mobility for Pervasive Sensor Networks», en Gellersen, H. W., Want R. y Schmidt A. (eds.), Pervasive Computing, Proceedings of the Third International Conference, Pervasive 2005, Múnich, Alemania, mayo de 2005, Berlín, Springer-Verlag, 2005, pp. 255-278.

38. Dementyev, A., Kao C.-L., Choi, I., Ajilo, D., Xu, M., Paradiso, J. A., Schmandt, C. y Follmer, S., «Rovables: Miniature On-Body Robots as Mobile Wearables», en Proceedings of ACM UIST 2016, 2016.

39. Orwell, G., 1984, Londres, Secker and Warburg, 8 de junio de 1949.