Cuando el pasado se hace futuro: la física en el siglo XXI

Aunque no se han producido últimamente en la física

revoluciones como las que tuvieron lugar durante el primer cuarto del

siglo XX, las semillas plantadas entonces han continuado germinando y

necesitando de nuevos desarrollos. De algunos de estos desarrollos se

ocupa este artículo; a la cabeza de ellos, los descubrimientos del bosón

de Higgs y de la radiación gravitacional. Al ahondar en ellos se hace

patente la necesidad de tratar también otros apartados, en los que la

física muestra su unidad con la astrofísica y la cosmología: materia

oscura, agujeros negros y multiuniversos. Se repasa, asimismo, la

situación en la teoría de cuerdas y en la supersimetría, así como en el

entrelazamiento cuántico, con las aplicaciones de este a las

comunicaciones seguras (criptografía cuántica), para terminar con la

presencia e importancia de la física en un mundo científicamente

interdisciplinar.

La física es considerada como la reina de las ciencias del

siglo XX, y lo es con justicia pues durante esa centuria se produjeron

dos revoluciones que modificaron drásticamente sus fundamentos e

introdujeron cambios socioeconómicos profundos: la de las teorías

especial y general de la relatividad (Albert Einstein 1905, 1915) y la

de la física cuántica, a la que, al contrario que en el caso de la

relatividad, no es posible asignar un único progenitor, al ser el

esfuerzo mancomunado de un extenso conjunto de científicos. Ahora bien,

sabemos que las revoluciones —ya sean en ciencia, en política o en

costumbres— poseen efectos de largo alcance, que aunque seguramente no

serán tan radicales como los que propiciaron las rupturas iniciales,

conducen más tarde a desarrollos, a descubrimientos o maneras de

entender la realidad, antes insospechadas. Así sucedió con la física una

vez que se completasen las nuevas teorías básicas, que en el caso de la

física cuántica quiere decir la mecánica cuántica (Werner Heisenberg,

1925; Paul Dirac, 1925 y Erwin Schrödinger, 1926). En el mundo

einsteiniano surgió enseguida la cosmología relativista, que pudo acoger

bien en su seno, como uno de los modelos de universo posibles, el

descubrimiento experimental de la expansión del Universo (Edwin Hubble,

1929). Fue, sin embargo, en el contexto de la física cuántica donde las

«consecuencias-aplicaciones» resultaron más prolíficas; fueron, de

hecho, tantas que se puede decir, sin exagerar, que cambiaron el mundo.

Los ejemplos en este sentido son demasiados para enumerarlos aquí;

baste, sin embargo, mencionar algunos: la construcción de una

electrodinámica cuántica (c. 1949), la invención del transistor (1947)

—al que bien se puede denominar «el átomo de la globalización y de la

sociedad digital»—, el desarrollo de la física de partículas elementales

(posteriormente denominada «de altas energías»), de la astrofísica, de

la física nuclear y del estado sólido (o «de la materia condensada»).

La segunda mitad del siglo XX asistió a la consolidación de estas

ramas de la física, pero podemos preguntarnos si, finalmente, dejaron de

aparecer novedades importantes y todo se redujo a meros desarrollos, lo

que Thomas Kuhn calificó en su libro de 1962 The Structure of Scientific Revolutions,

como «ciencia normal». El concepto de «ciencia normal», me apresuro a

señalar, es complejo y puede conducir a error: el desarrollo de los

fundamentos —del «núcleo duro», si utilizamos la terminología

introducida por Kuhn— de un paradigma científico, esto es, la «ciencia

normal», puede abrir nuevas puertas al conocimiento de la naturaleza,

algo que sin duda posee una importancia de primer orden. En el presente

artículo, en el que trato de la década 2008-2018, veremos que así

sucedió en algún caso, y en fechas —la segunda década del siglo XXI— ya

bastante alejadas de los «años revolucionarios» de comienzos del siglo

XX.

El descubrimiento del bosón de Higgs

Uno de los acontecimientos más celebrados en la física de la última

década ha sido la confirmación de una predicción teórica hecha hacía

casi medio siglo: la existencia del bosón de Higgs. Veamos de donde

procedía esa predicción.

La física de altas energías experimentó un avance extraordinario con

la introducción de unas partículas para las que se terminó aceptando el

nombre propuesto por uno de sus introductores, Murray Gell-Mann: quarks,

cuya existencia fue propuesta teóricamente en 1964, además de por

Gell-Mann, por George Zweig. Hasta su aparición se pensaba que protones y

neutrones eran estructuras atómicas inquebrantables, realmente básicas,

y que la carga eléctrica asociada a protones y electrones era una

unidad indivisible. Los quarks no obedecían a esta regla, ya que se les

asignó cargas fraccionarias. De acuerdo a Gell-Mann y Zweig, los

hadrones, las partículas sujetas a la interacción fuerte, están formados

por dos o tres especies de quarks y antiquarks, denominados u (up;

arriba), d (down; abajo) y s (strange; extraño), con, respectivamente,

cargas eléctricas 2/3, –1/3 y –1/3 la del electrón (de hecho, los

hadrones pueden ser de dos tipos: bariones —protones, neutrones e

hiperones— y mesones, partículas cuyas masas tienen valores entre la del

electrón y la del protón). Así, un protón está formado por dos quarks u

y uno d, mientras que un neutrón está formado por dos quarks d y por

otro u; son, por consiguiente, estructuras compuestas. Posteriormente,

otros físicos propusieron la existencia de tres quarks más: charm (c;

1974), bottom (b; 1977) y top (t; 1995). Para caracterizar esta

variedad, se dice que los quarks tienen seis tipos de «sabores»

(flavours); además, cada uno de estos seis tipos puede ser de tres

clases, o colores: rojo, amarillo (o verde) y azul. Y para cada quark

existe, claro, un antiquark. (Por supuesto, nombres como los anteriores

—color, sabor, arriba, abajo…— no representan la realidad que asociamos

normalmente a tales conceptos, aunque puede en algún caso existir una

cierta lógica en ellos, como sucede con el color.)

En definitiva, los quarks tienen color pero los hadrones no: son

blancos. La idea es que solo las partículas «blancas» son observables

directamente en la naturaleza, mientras que los quarks no; ellos están

«confinados», asociados formando hadrones. Nunca podremos observar un

quark libre. Ahora bien, para que los quarks permanezcan confinados

deben existir fuerzas entre ellos muy diferentes de las

electromagnéticas o de las restantes. En palabras de Gell-Mann (1995, p.

200): «Así como la fuerza electromagnética entre electrones está

mediada por el intercambio virtual de fotones, los quarks están ligados

entre sí por una fuerza que surge del intercambio de otros cuantos: los

gluones [del inglés glue, pegar], llamados así porque hacen que los

quarks se peguen formando objetos observables blancos como el protón y

el neutrón».

Aproximadamente una década después de la introducción de los quarks,

se desarrolló una teoría, la cromodinámica cuántica, que explica por qué

los quarks están confinados tan fuertemente que nunca pueden escapar de

la estructuras hadrónicas que forman. El nombre cromodinámica

—procedente del término griego cromos (color)— aludía al color de los

quarks, y el adjetivo «cuántica» a que es compatible con los requisitos

cuánticos. Al ser la cromodinámica cuántica una teoría de las partículas

elementales con color, y al estar este asociado a los quarks, que a su

vez tratan de los hadrones, las partículas sujetas a la interacción

fuerte, tenemos que la cromodinámica cuántica describe esta interacción.

Con la electrodinámica cuántica y la cromodinámica cuántica, se

disponía de teorías cuánticas para las interacciones electromagnética y

fuerte. Además, se disponía de una teoría de la interacción débil (la

responsable de procesos radiactivos como la radiación beta, la emisión

de electrones en procesos nucleares), pero esta tenía problemas. Una

versión más satisfactoria para una teoría cuántica de la interacción

débil llegó cuando en 1967 el estadounidense Steven Weinberg y el año

siguiente el paquistaní (afincando en Inglaterra) Abdus Salam

propusieron independientemente una teoría que unificaba las

interacciones electromagnética y débil. Su modelo incorporaba ideas

propuestas en 1960 por Sheldon Glashow. Por estos trabajos, Weinberg,

Salam y Glashow compartieron el Premio Nobel de Física de 1979; esto es,

después de que, en 1973, una de las predicciones de su teoría —la

existencia de las denominadas «corrientes neutras débiles»— fuese

corroborada experimentalmente en el CERN, el gran laboratorio europeo de

altas energías.

La teoría electrodébil unificaba la descripción de las interacciones

electromagnética y débil, pero ¿no sería posible avanzar por la senda de

la unificación, encontrando una formulación que incluyese también a la

interacción fuerte, descrita por la cromodinámica cuántica? La

respuesta, positiva, a esta cuestión vino de la mano de Howard Georgi y

Glashow, que introdujeron en 1974 las primeras ideas de lo que se vino

en denominar Teorías de Gran Unificación (GUT).

Gracias al conjunto formado por las anteriores teorías, se dispuso de

un gran marco teórico para entender de qué está formada la naturaleza.

Un marco teórico con una extraordinaria capacidad predictiva. De acuerdo

con él, se acepta por una parte que las partículas elementales

pertenecen a uno de los dos siguientes grupos: bosones o fermiones,

según su espín sea entero o fraccionario (el fotón es un bosón y el

electrón un fermión), que obedecen a dos estadísticas (maneras de

«contar» agrupaciones de partículas de la misma especie) diferentes: la

estadística de Bose-Einstein y la estadística de Fermi-Dirac. Por otra

parte, se tiene que toda la materia del Universo está formada por

agregados de tres tipos de partículas elementales: electrones y sus

parientes (las partículas denominadas muón y tau), neutrinos (neutrino

electrónico, muónico y tauónico) y quarks, además de por los cuantos

asociados a los campos de las cuatro fuerzas que reconocemos en la

naturaleza (recordemos la dualidad onda-corpúsculo, que significa que en

la física cuántica una partícula se puede comportar como un campo y

viceversa): el fotón para la interacción electromagnética, las

partículas Z y W (bosones gauge) para la débil, los gluones para la

fuerte y, aunque la gravitación aún no se ha incorporado a ese marco,

los, supuestos, gravitones para la gravitacional. El subconjunto formado

por la cromodinámica cuántica y la teoría electrodébil (esto es, el

sistema teórico que incorpora las teorías relativistas y cuánticas de

las interacciones fuerte, electromagnética y débil) es especialmente

poderoso si tenemos en cuenta el balance predicciones-comprobaciones

experimentales. Es denominado «Modelo estándar». Ahora bien, un problema

con este modelo era que para explicar el origen de la masa de las

partículas elementales que aparecen en él era preciso que existiese una

nueva partícula, un bosón, cuyo campo asociado impregnaría todo el

espacio, «frenando», por decirlo de alguna manera, a las partículas que

tienen masa, mostrando estas, mediante su interacción con el campo de

Higgs, dicha masa (explica, en particular, la gran masa que poseen los

bosones gauge W y Z, y también la masa nula de los fotones, ya que no

interactúan con el bosón de Higgs). La existencia de semejante bosón fue

prevista teóricamente en tres artículos publicados en 1964, en el mismo

volumen de la revista Physical Review Letters: el primero estaba

firmado por Peter Higgs, el segundo por François Englert y Robert Brout y

el tercero por Gerald Guralnik, Carl Hagen y Thomas Kibble. A la

partícula en cuestión se le adjudicó el nombre de «bosón de Higgs».

Uno de los acontecimientos más celebrados en la física de la última década ha sido la confirmación de una predicción teórica hecha hacía casi medio siglo: la existencia del bosón de Higgs

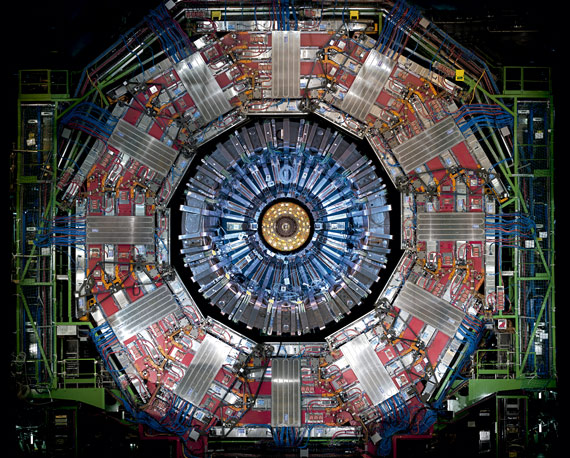

Para que esa supuesta partícula se pudiera detectar hacía falta un

acelerador de partículas que alcanzase energías lo suficientemente

elevadas para producirla. No se dispuso de semejante máquina hasta

muchos años después de que se propusiera su existencia. Fue en 1994

cuando el CERN aprobó la construcción de ese acelerador, el Large Hadron

Collider (LHC; Gran Colisionador de Hadrones). El que debía ser el

mayor acelerador de partículas del mundo sería un anillo de 27

kilómetros, rodeado de 9.600 imanes de diverso tipo, 1.200 de ellos

dipolos superconductores que funcionan a 271,3 grados Celsius bajo cero,

una temperatura más baja que la del espacio exterior (se consigue con

la ayuda de helio líquido). En el interior de ese anillo, guiados por el

campo magnético producido por «la escolta» de electroimanes, se

acelerarían, en sentidos opuestos, dos haces de protones a velocidades

próximas a la de la luz. Cada uno de los dos haces circularían en tubos

diferentes, mantenidos en un vacío extremo, hasta que alcanzasen la

energía prevista, momento en el que se harían colisionar. La teoría

decía que en algunas de esas colisiones se producirían bosones de Higgs.

Un grave problema era que este bosón se desintegra prácticamente de

manera inmediata en otras partículas; era preciso, por consiguiente,

disponer de detectores especialmente sensibles. Los que se diseñaron y

construyeron para el LHC, denominados ATLAS, CMS, ALICE y LHCb,

constituyen gigantescos monumentos a la tecnología más avanzada.

Finalizada la construcción, el primer haz de protones, de prueba, se

hizo circular por el LHC el 10 de septiembre de 2008. El 30 de marzo de

2010 se producían las primeras colisiones entre protones, a una energía

total de 7·1012 eV (esto es, 7 tera-electronvoltios; TeV), energía nunca

antes alcanzada por un acelerador de partículas. Fue, finalmente, el 4

de julio de 2012 cuando el CERN anunció públicamente que se había

detectado una partícula con una masa de, aproximadamente, 125·109 eV (o

125 giga-electronvoltios; GeV), cuyas propiedades indicaban, con gran

probabilidad, que se trataba del bosón de Higgs (el Modelo estándar no

predice su masa). La noticia fue portada de prácticamente todos los

periódicos y noticiarios del mundo. Casi medio siglo después de haberse

predicho teóricamente, se confirmaba su existencia. No resulta

sorprendente que el Premio Nobel de Física de 2013 fuese otorgado a

Peter Higgs y François Englert, por, según la comunicación oficial de la

Fundación Nobel, «el descubrimiento teórico de un mecanismo que

contribuye a comprender el origen de la masa de partículas subatómicas y

que ha sido confirmada recientemente mediante el descubrimiento de la

partícula fundamental predicha, por los experimentos ATLAS y CMS en el

Large Hadron Collider del CERN».

Evidentemente, semejante confirmación constituía un motivo de

satisfacción, pero no faltaron quienes, con un buen argumento,

manifestaran que habrían preferido un resultado negativo, que no se

encontrase el bosón de Higgs donde la teoría preveía que debía estar

(esto es, con la masa predicha). El físico teórico y divulgador

estadounidense Jeremy Bernstein (2012a, b, p. 33) expresó ese

sentimiento muy poco antes del anuncio del descubrimiento: «Si el LHC

confirma la existencia del bosón de Higgs, marcará el punto final de un

largo capítulo de la física teórica. La historia me recuerda a la de un

compañero francés. Cierto parámetro había sido bautizado con su nombre,

por lo que aparecía con bastante frecuencia en las discusiones sobre las

interacciones débiles. Al final, el parámetro fue medido y el modelo

confirmado en los experimentos. Sin embargo, cuando fui a felicitarle,

lo hallé entristecido porque ya no se hablaría más de su parámetro. Si

el bosón de Higgs no apareciese, la situación se tornaría muy

interesante puesto que nos veríamos ante la imperiosa necesidad de

inventar nueva física».

Sin embargo, el hecho —y el triunfo— es que el bosón de Higgs existe y

se identificó. Pero la ciencia siempre está en movimiento y en febrero

de 2013 el LHC detuvo sus operaciones para que se realizasen los ajustes

necesarios destinados a alcanzar los 13 TeV. El 12 de abril de 2018

comenzó esa nueva etapa con las correspondientes pruebas de colisiones

de protones. Se trata de buscar datos inesperados, que revelen la

existencia de nuevas leyes de la física. Pero por el momento lo que se

puede decir es que el Modelo estándar funciona muy bien, que es uno de

los grandes logros de toda la historia de la física, un logro que, mucho

más que la mecánica y electrodinámica cuánticas —no digamos ya que la

relatividad, especial y general—, ha sido producto de un esfuerzo

colectivo.

Ahora bien, no obstante su éxito el Modelo estándar no es, no puede

ser, «la Teoría final». Por una parte, porque la interacción

gravitacional queda al margen, pero también porque incluye demasiados

parámetros que hay que determinar experimentalmente. Se trata de las,

siempre incómodas pero fundamentales, preguntas del tipo «¿por qué?».

¿Por qué existen las partículas fundamentales que detectamos? ¿Por qué

son cuatro las interacciones fundamentales, y no tres, cinco o solo una?

¿Y por qué tienen estas interacciones las propiedades (como intensidad o

rango de acción) que poseen? En el número de agosto de 2011 de Physics

Today, la revista de la American Physical Society, Steven Weinberg

(2011, p. 33) reflexionaba sobre algunos de estos puntos, y de otros, en

los siguientes términos:

Por supuesto, mucho antes del descubrimiento de que los neutrinos

tienen masa, sabíamos que hay algo más allá del Modelo estándar que

sugiere una nueva física para masas un poco por encima de 1016 GeV: la

existencia de la gravitación. Y también está el hecho de que el

parámetro de acoplamiento de [la interacción] fuerte y los dos de [la

interacción] débil del Modelo estándar, que dependen solamente

logarítmicamente de la energía, parecen converger hacia un valor común a

una energía del orden de entre 1015 y 1016 GeV.

Hay muchas buenas ideas sobre cómo ir más allá del Modelo

estándar, incluyendo la supersimetría y lo que se llamó teoría de

cuerdas, pero todavía no existe ningún dato experimental que las

confirme. Incluso si los gobiernos son generosos con la física de

partículas en un grado fuera de los sueños más atrevidos, puede que

nunca seamos capaces de construir aceleradores que alcancen energías de

entre 1015 y 1016 GeV. Algún día puede que seamos capaces de detectar

ondas gravitacionales de alta frecuencia emitidas durante la época de

inflación en el universo muy temprano, que nos ofrezcan datos de

procesos físicos a muy alta energía. Entre tanto, lo que podemos esperar

es que el LHC y sus sucesores nos proporcionen las claves que tan

desesperadamente necesitamos para superar los éxitos de los últimos cien

años.

Y a continuación, Weinberg se preguntaba: «¿Cuál es la razón de todo

esto? ¿Realmente necesitamos saber por qué existen tres generaciones de

quarks y leptones, o si la naturaleza respeta la supersimetría, o lo que

es la materia oscura? Sí, pienso que sí, porque responder a este tipo

de preguntas es el siguiente paso en un programa para conocer cómo todas

las regularidades de la naturaleza (todo lo que no es un accidente

histórico) se siguen de unas pocas, simples, leyes».

Vemos en esta cita de Weinberg que la energía a las que esa «nueva

física» se debería manifestar con claridad, 1015-1016 GeV, se halla muy

lejos de los 13 TeV, esto es, 13·103 GeV que debe alcanzar el LHC

renovado. Tan lejos está que se entiende perfectamente el comentario de

Weinberg de que «puede que nunca seamos capaces de construir

aceleradores que alcancen esas energías». Pero Weinberg también señalaba

que acaso en la investigación del Universo se pudiesen encontrar formas

de acceder a esos niveles de energía. Él mismo lo sabía muy bien, ya

que en la década de 1970 fue uno de los que más impulsaron la unión de

la física de partículas elementales con la cosmología. Recordemos en

este sentido su libro, The First Three Minutes: A Modern View of the

Origin of the Universe (1977), en el que se esforzaba por divulgar la

ayuda mutua que podrían obtener —que de hecho obtuvieron— cosmología y

física de altas energías al estudiar los primeros instantes después del

big bang. Para la física de altas energías aquel «matrimonio de

conveniencias» significó un aire nuevo.

No era, sin embargo, el estilo, las técnicas, que caracterizaron el

empleo de la física de partículas elementales en las décadas de

1970-1990 a las que se refería Weinberg, sino a una muy diferente: las

ondas gravitacionales, o radiación gravitacional. Ahora bien,

independientemente de otras diferencias, el nicho teórico de la

radiación gravitacional no se encuentra en la física cuántica, sino en

la teoría que describe la única interacción que hasta ahora no ha podido

ser amoldada a los requisitos cuánticos, la teoría de la relatividad

general, en la que el mundo de la física básica se confunde con los de

la cosmología y astrofísica. Y en ese mundo plural también se produjo un

avance fundamental en la última década.

La radiación gravitacional existe

Tras años de intensos esfuerzos mentales —cuyo punto de partida fue

1907, cuando identificó como pieza clave para construir una teoría

relativista de la gravitación el denominado «principio de

equivalencia»—, años en los que no infrecuentemente tomó caminos

erróneos, en noviembre de 1915 Albert Einstein completó la estructura de

la que muchos consideran la construcción teórica más hermosa de la

física: la teoría de la relatividad general. Se trata de una teoría

«clásica», esto es, que, como ya apunté, no incluye los principios de la

física cuántica, principios de los que, existe consenso en esto, deben

participar todas las teorías de la física. Aun así, la formulación

relativista de la gravitación einsteiniana ha ido superando todas las

pruebas experimentales que se ha encontrado hasta la fecha. Una de sus

predicciones que más tiempo tardó en confirmarse fue la de que la

aceleración de masas da origen a la emisión de ondas; esto es, la

existencia de radiación gravitacional. Se suele citar 1916 como la fecha

de nacimiento de la predicción de la existencia de estas ondas, año en

el que Einstein publicó un artículo en el que concluía que efectivamente

existían. Sin embargo, aquel trabajo tenía las suficientes limitaciones

como para que Einstein volviese al asunto años después. En 1936 preparó

con un colaborador, Nathan Rosen, un manuscrito que titularon «¿Existen

ondas gravitacionales?», en el que ahora llegaban a la conclusión de

que no existían. No obstante, aquel trabajo contenía errores, y en la

versión final publicada (Einstein y Rosen, 1937) ya no se rechazaba la

posibilidad de ondas gravitacionales.

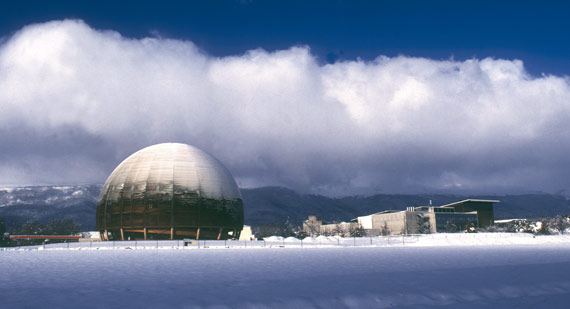

El

Gran Colisionador de Hadrones (LHC) es el mayor acelerador de

partículas del mundo, con un anillo de 27 km, rodeado de 9.600 imanes,

de los cuales 1.200 funcionan a 271,3 grados Celsius bajo cero, una

temperatura más baja que la del espacio exterior

El problema de si realmente existían las ondas gravitacionales, esto

es, de detectarlas, se mantuvo durante décadas. Nadie intentó con más

empeño y durante tanto tiempo —a partir de 1960— detectarlas como Joseph

Weber, de la Universidad de Maryland. De hecho, llegó a creer que había

conseguido detectarlas, aunque no era cierto. Su montaje experimental

consistía en un cilindro de aluminio de un metro de diámetro y 3,5

toneladas de peso, al que acoplaba aparatos de cuarzo piezoeléctrico

para detectar las posibles distorsiones que se produjesen en el cilindro

cuando lo atravesase una onda gravitacional. Cuando se compara aquel

instrumental con el que finalmente se utilizó para su detección, no

podemos sino maravillarnos del entusiasmo e ingenuidad de Weber, quien

falleció en 2000 sin conocer que la empresa que había guiado su vida

profesional era correcta. Así es la ciencia, una tarea en la que, salvo

excepciones, los problemas no suelen ser resueltos mediante el trabajo

de un solo científico y en la que no faltan los errores. Una tarea,

además, larga.

El 11 de febrero de 2016 un representante de LIGO anunció que habían detectado ondas gravitacionales y que estas correspondían al choque de dos agujeros negros, lo que de paso significaba una nueva confirmación de la existencia de estas singulares entidades cósmicas

Ha sido durante la última década cuando finalmente se detectó la

radiación gravitacional, que implica detectar distorsiones del tamaño de

una pequeña fracción de un átomo. La detección (Abbott et al., 2016) se

produjo gracias a un sistema estadounidense denominado LIGO (por sus

siglas inglesas, Laser Interferometric Gravitational wave Observatories

[Observatorio de Interferometría Láser de ondas de Gravedad]), compuesto

de dos observatorios separados por 3.000 kilómetros (esta duplicidad

permite identificar señales falsas, producidas por efectos locales), uno

en Livingston (Louisiana) y el otro en Hanford (Washington). La idea es

utilizar sistemas interferométricos de dos brazos perpendiculares y en

condiciones de vacío con un recorrido óptico de 2 o 4 kilómetros, para

detectar las ondas gravitacionales a través de los minúsculos

movimientos que estas deben producir en los espejos al pasar por allí.

El 11 de febrero de 2016, un representante de LIGO anunció que habían

detectado ondas gravitacionales y que estas correspondían al choque de

dos agujeros negros, lo que de paso significaba una nueva confirmación

de la existencia de estas singulares entidades cósmicas. Aunque no

participó en esa primera detección (no tenía entonces la sensibilidad

necesaria; estaba siendo mejorada), existe otro gran observatorio

interferométrico dedicado a la detección de radiación gravitacional:

Virgo. Originado en una colaboración europea entre seis países (Italia y

Francia, los principales, más Holanda, Hungría, Polonia y España) y

ubicado cerca de Pisa, Virgo tiene acuerdos con LIGO; de hecho, en el

artículo «fundacional», después del encabezamiento de autores, B. P.

Abbot et al., aparece «LIGO Scientific Collaboration and Virgo

Collaboration». Pronto Virgo se unió a las investigaciones; lo hizo a

partir de la segunda ronda de observaciones el 1 de agosto de 2017.

La detección de la radiación gravitacional ha significado que se ha

abierto una nueva ventana al estudio del Universo, una ventana que se

irá ensanchando según vaya mejorando la tecnología y se establezcan más

observatorios del tipo de LIGO y Virgo. Se trata de una situación

comparable a la que tuvo lugar en la década de 1930, cuando, a partir de

los experimentos pioneros de Karl Jansky, la radioastronomía (la

astronomía basada en ondas radio, con longitud de onda en el rango de

unos cuantos centímetros a unos metros) amplió radicalmente nuestro

conocimiento del cosmos, hasta entonces dependiente únicamente del

estrecho margen de longitudes de onda del espectro electromagnético que

reconoce el ojo humano. De hecho, no se ha tardado demasiado en avanzar

en tal senda: el 16 de octubre de 2017 LIGO y Virgo (Abbott et al.,

2017) anunciaron que el 17 de agosto de ese año habían detectado la

radiación gravitacional procedente del choque de dos estrellas de

neutrones de entre 1,17 y 1,60 masas la del Sol (recordemos que una

estrella de neutrones es una estrella extremadamente densa y muy pequeña

—de un radio del orden de los diez kilómetros—, asimilable a una

especie de núcleo gigante formado únicamente por neutrones unidos por la

fuerza de la gravedad). Particularmente interesante es que 1,7 segundos

después de que se recibiese la señal, el telescopio espacial «Fermi» de

la NASA detectó —otros observatorios lo hicieron más tarde— rayos gamma

procedentes de la misma región del espacio en la que se había producido

ese choque cósmico. Analizando esa radiación, se ha observado que en la

colisión de las dos estrellas se produjeron elementos químicos como

oro, plata, platino o uranio, cuyos «lugares de nacimiento» se

desconocían hasta el momento. La detección de las ondas gravitacionales

muestra también una de las características de la denominada Big Science:

el artículo, «Observation of Gravitational Waves from a Binary Black

Hole Merger», en el que se anunció su descubrimiento, publicado en

Physical Review Letters (B. P. Abbott et al., 2016) coincidiendo con el

anuncio del día 11, está firmado por 1.036 autores, procedentes de 133

instituciones (de sus 16 páginas, seis están dedicadas a la lista de

esos autores e instituciones).

En 2017 se reconocía la importancia del hallazgo de LIGO adjudicando

el Premio Nobel de Física a, la mitad, Rainer Weiss, responsable de la

invención y desarrollo de la técnica de interferometría láser empleada, y

la otra mitad a Kip Thorne, físico teórico especialista en relatividad

general, que en 1975 diseñó junto a Weiss las líneas directrices futuras

del proyecto, con el que ha seguido asociado siempre, y Barry Barish,

quien se unió al proyecto en 1994, reorganizándolo como director. (En

2016 el galardón se adjudicó a David Thouless, Duncan Haldane y Michael

Kosterlitz, quienes utilizando técnicas procedentes de la topología, una

rama de la matemática, consiguieron demostrar que existen estados,

«fases», de la materia antes desconocidos, en, por ejemplo,

superconductores y superfluidos, que pueden existir en láminas delgadas,

algo que se suponía imposible, explicando, asimismo, el mecanismo —una

«transición de fase»— que hace que la superconductividad desaparezca a

temperaturas elevadas.)

Agujeros negros y agujeros de gusano

Que la primera detección de radiación gravitacional en LIGO

procediera del choque de dos agujeros negros, es también digno de

resaltar. En cierto que por entonces existían numerosas pruebas de la

existencia de esos objetos astrofísicos tan sorprendentes (la primera

evidencia en ese sentido llegó en 1971, procedente de observaciones

tomadas por instrumentos instalados en un satélite que Estados Unidos

puso en órbita el 12 de diciembre de 1970, y en la actualidad ya se han

identificado muchos más, entre otros los existentes en numerosos núcleos

de galaxias, incluyendo la nuestra, la Vía Láctea). Conviene recordar

que en la década de 1970 muchos científicos especialistas en relatividad

general pensaban que los agujeros negros no eran sino «fantasmas

matemáticos» de algunas soluciones de la teoría einsteiniana que había

que descartar; al fin y al cabo, las ecuaciones de una teoría física que

describe un dominio de la realidad pueden albergar soluciones que no se

dan en la Naturaleza, el caso, por ejemplo, de la cosmología

relativista, que incluye múltiples universos posibles. Pero ha resultado

que los agujeros negros sí existen, aunque no comprendamos todavía

aspectos tan fundamentales como a donde va a parar la masa que engullen.

Quienes más hicieron por defender que los agujeros negros son

consecuencias inevitables de la relatividad general y que, por

consiguiente, debían existir, fueron Stephen Hawking y Roger Penrose,

este formado inicialmente como matemático puro, en una serie de trabajos

publicados en la década de 1960. A ellos se unieron después otros

científicos, entre ellos John A. Wheeler (por cierto, director de la

tesis doctoral de Thorne), quien acuñó el término «agujero negro».

Hawking, que falleció en 14 de marzo de 2018, pudo, por consiguiente,

conocer que la nueva confirmación de la teoría de la relatividad

general, a cuyo desarrollo dedicó tantos esfuerzos, aportaba otra prueba

de la existencia de los agujeros negros. Teniendo en cuenta que nadie

—ni siquiera Penrose o Wheeler (este también desaparecido)— había

aportado más a la física de los agujeros negros (en 1973, en la que se

considera su aportación más distinguida, Hawking presentó un trabajo en

el que sostenía que los agujeros negros no son tan «negros», que emiten

radiación y que, por tanto, pueden terminar desapareciendo, aunque muy

lentamente, algo todavía no comprobado), tal vez, si los estatutos de la

Fundación Nobel permitiesen que sus Premios los recibiesen no tres como

máximo, sino cuatro personas, él habría sido un buen candidato. Pero la

historia es como es, no como algunos quisieran que fuera.

En la cita de Weinberg que apareció anteriormente, este manifestaba

que «algún día puede que seamos capaces de detectar ondas

gravitacionales de alta frecuencia emitidas durante la época de

inflación en el universo muy temprano, que nos ofrezcan datos de

procesos físicos a muy alta energía». Ese tipo de ondas gravitacionales

aún no se han detectado, pero acaso lo sean pronto, pues ¿no se

observaron ya las denominadas «arrugas en el tiempo», esto es, las

minúsculas irregularidades en el fondo cósmico de radiación de

microondas de las que surgieron las complejas estructuras, como las

galaxias, que ahora existen en el Universo (Mather et al., 1990; Smoot

et al., 1992)? Fue, recordemos, gracias a un satélite, el Cosmic

Background Explorer (COBE), puesto en órbita, a 900 kilómetros de

altura, en el otoño de 1989. Entre tanto, el futuro de la astrofísica de

la radiación gravitacional promete grandes novedades. Una de ellas,

podría ser la identificación de entidades cosmológicas igual de

sorprendentes que los agujeros negros: los «agujeros de gusano», nombre

también acuñado por John Wheeler. Expresado de manera sencilla, los

agujeros de gusano son «atajos» en el Universo, una especie de puentes

que conectan diferentes lugares de este. Puede, por ejemplo, que la

distancia entre dos puntos del Universo sea, digamos, de treinta

años-luz (un año-luz es, recordemos, la distancia que recorre un rayo de

luz en un año), pero si, debido a la curvatura del universo, del

espacio-tiempo, existiera un atajo, un puente, entre esos puntos, la

distancia siguiendo este nuevo camino sería otra, acaso mucho menor, dos

años-luz, por ejemplo. De hecho, la posibilidad de que existieran esas

entidades cosmológicas surgió poco después de que Albert Einstein

completase la teoría de la relatividad general: en 1916, un físico de

Viena, Ludwig Flamm, encontró una solución de las ecuaciones de Einstein

en las que aparecían esos «puentes» espacio-temporales. Sin embargo, el

trabajo de Flamm apenas recibió atención, y diecinueve años más tarde

Einstein junto a uno de sus colaboradores, Nathan Rosen, publicaba un

artículo en el que representaban el espacio físico como formado por dos

«hojas» idénticas que entraban en contacto a lo largo de una superficie

que llamaban «puente». Ahora bien, en lugar de pensar en atajos

espaciales —la idea rayaba, creían, en lo absurdo— interpretaban ese

puente como una partícula.

Quienes más hicieron por defender que los agujeros negros son consecuencias inevitables de la relatividad general y que, por consiguiente, debían existir, fueron Stephen Hawking y Roger Penrose en una serie de trabajos publicados en la década de 1960

Décadas más tarde, cuando la teoría de la relatividad general

abandonó el intemporal hogar de la matemática en el que se encontraba

enclaustrada y, gracias a los avances tecnológicos, demostró su utilidad

para entender el cosmos y sus contenidos, se exploró la idea de esos

atajos. Uno de los resultados que se obtuvieron entonces fue que de

existir, lo hacen durante un tiempo muy breve; son, como si dijéremos,

ventanas que se abren durante un intervalo de tiempo tan pequeño que no

se puede mirar por ellas, o, traducido a la posibilidad de viajar por

ellos, que no da tiempo a utilizarlos para ir de un punto del Universo a

otro, para atajar. En un espléndido libro, Black Holes and Time Warps

(1994), Kip Thorne explicó esta propiedad de los agujeros de gusano,

pero al mismo tiempo contó que en 1985 recibió una llamada de su amigo

Carl Sagan, que estaba terminando de escribir la novela que

posteriormente sería también película, Contact (1985). Sagan, que no

sabía mucha relatividad general, quería que la heroína de su historia,

la astrofísica Eleanor Arroway (Jodie Foster en la película), viajase

rápidamente de un lugar del Universo a otro penetrando en un agujero

negro. Thorne sabía que esto no era posible, pero para ayudar a Sagan

pensó en sustituir el agujero negro por un agujero de gusano: «Cuando un

amigo necesita ayuda», escribió en su libro (Thorne 1994, 1995, pp. 450

y 452), «uno está dispuesto a buscarla en cualquier parte». No

obstante, estaba todavía el problema de la muy efímera vida de estos.

Para resolverlo, para mantener abierto el agujero de gusano el tiempo

necesario, introdujo la idea de que Arroway utilizase «un material

exótico» dotado de una serie de características que, más o menos,

detallaba. «Quizá», señalaba Thorpe, «el material exótico puede

existir». Resultó que otros (Stephen Hawking entre ellos) habían llegado

a la misma conclusión y, de hecho, la cuestión de si los agujeros de

gusano pueden estar abiertos más tiempo del que se dedujo inicialmente

ha dado origen a estudios relacionados con ideas que tienen sentido en

la física cuántica, como las fluctuaciones del vacío: considerar el

espacio como si fuera, a escala ultramicroscópica, un líquido en

ebullición.

Otra posibilidad que se ha barajado recientemente procede de un grupo

de cinco científicos de las Universidades de Lovaina, Autónoma de

Madrid-Consejo Superior de Investigaciones Científicas y Waterloo, que

publicaron un artículo en Physical Review D (Bueno, Cano, Goelen, Hertog

y Vercnocke, 2018) en el que plantearon la posibilidad de que la

radiación gravitacional detectada por LIGO que se interpretó como

procedente de la colisión de dos agujeros negros, tenga un origen muy

diferente: la colisión de dos agujeros de gusano que rotan. La idea de

estos investigadores se basa en que en torno a los agujeros negros

existe una frontera, un horizonte de sucesos, que hace que las ondas

gravitacionales producidas en un choque como el detectado en 2016 se

«apaguen», cesen, en un intervalo de tiempo muy breve. Según estos

científicos, esto no sucedería si se tratase de agujeros de gusano, en

los que no existen tales horizontes de sucesos, y en los que se deberían

producir «ecos», reverberaciones de las ondas. Tales ecos no se han

detectado, pero bien pudo ser porque la instrumentación no era capaz de

hacerlo, o no estaba preparada para ello. He aquí un problema a resolver

en el futuro.

Multiuniversos

Considerar seriamente la idea de que pueden existir «puentes» en el

espacio-tiempo, agujeros de gusano, puede parecer sumergirse en un mundo

en el que la ciencia se confunde con la ciencia-ficción, pero la

historia de la ciencia nos ha mostrado que a veces la naturaleza

sorprende más que la mente humana más imaginativa. ¿Quién sabe, por

consiguiente, si objetos como los agujeros de gusano pueden existir?

Recurriendo de nuevo a la radioastronomía, recordemos que antes de su

advenimiento ningún científico imaginó que pudieran existir estructuras

astrofísicas como los púlsares o los cuásares. Incluso el mismo Universo

como entidad diferenciada puede terminar perdiendo su más acusada

característica: la unicidad. A lo largo de la última década, cada vez se

ha considerado más seriamente una posibilidad que surgió como una

manera para entender el colapso de la función de onda, esto es, el que

en mecánica cuántica sea la observación la que finalmente decide cuál de

todos los estados posibles de un sistema, que coexisten antes de esa

observación, se hace realidad (y cuál es la probabilidad de que ocurra

esto). Que es posible pensar en otros términos, es algo que hizo un

joven físico que estaba trabajado en su tesis doctoral: Hugh Everett

III. Al contrario que a la mayoría de sus contemporáneos, la

interpretación de Copenhague de la mecánica cuántica, tan favorecida por

el influyente Niels Bohr, no le convenció, en especial la extraña

mezcla entre los mundos clásicos y cuánticos: la función de onda sigue

su camino cuántico, hasta que se realiza una medida, que pertenece al

mundo de la física clásica; entonces se produce el mencionado colapso de

la función de onda. Everett pensaba que semejante dicotomía entre una

descripción cuántica y una clásica constituía una «monstruosidad

filosófica».1

Lo que propuso, en consecuencia, fue prescindir del postulado del

colapso de la función de onda y tratar de incluir al observador en la

función de onda.

No es fácil explicar en pocas palabras la teoría que elaboró Everett;

de hecho, el director de su tesis doctoral, John Wheeler, tuvo

dificultades para aceptar todo su contenido, induciéndole a varias

revisiones de su trabajo inicial, incluyendo recortar la primera versión

que escribió de su tesis y limitar la fuerza de algunas de sus

aserciones aunque, por otra parte, reconoció su valor. Me limitaré a

citar un pasaje del artículo que Everett III (1957) publicó en Reviews

of Modern Physics y que coincide con la versión final de su tesis

doctoral (obtuvo su Ph. D en abril de 1957). Se lee en él (Everett III,

1957; Barret y Byrne, eds., 2012, pp. 188-189):

De esta manera llegamos a la siguiente imagen: a lo largo de

toda la secuencia de procesos de observación, solamente existe un

sistema físico que representa el observador, aunque no existe un único

estado para el observador […] Sin embargo, existe una

representación en términos de una superposición […] Por consiguiente,

con cada observación (o interacción) sucesiva, el estado de observador

«se desdobla» [branches] en un número de estados diferentes. Cada rama

[branch] representa un resultado diferente de la medición y los

autoestados correspondientes para el estado objeto-sistema. Todas las

ramas existen simultáneamente en la superposición tras una secuencia

dada de observaciones.

En esta última cita nos encontramos lo que se convertiría en la

característica más representativa de la teoría de Everett. Pero esa

característica no la promovió él, sino Bryce DeWitt. Fue, en efecto,

DeWitt quien rescató y modificó la teoría de Everett, convirtiéndola en

«la interpretación de los muchos mundos» (o multiuniversos), el título

de una recopilación de trabajos de Everett que DeWitt y Neill Graham

editaron en 1973: The Many-Worlds Interpretation of Quantum Mechanics

(DeWitt y Graham, eds., 1973). Antes, DeWitt (1970) había publicado un

atractivo, y a la postre influyente, artículo en Physics Today en el que

presentaba la teoría de Everett bajo el sugerente título de «Mecánica

cuántica y realidad». Recordando aquel escrito, DeWitt señaló

(DeWitt-Morette, 2011, p. 95): «El artículo de Physics Today estaba

escrito deliberadamente en un estilo sensacionalista. Introduje una

terminología («desdoblamiento» [splitting], múltiples «mundos»,

etcétera) que fueron inaceptables para algunas personas y a la que un

cierto número objetó porque, como mínimo, carecían de precisión». Las

ideas, la versión de la teoría de Everett implícita en la presentación

de DeWitt, y la que se ha mantenido con cierto florecimiento en los

últimos tiempos, es la de que la función de onda del Universo, la única

que realmente tiene sentido según Everett, se desdobla con cada proceso

de «medida», originando mundos, universos, que a su vez se desdoblan en

otros, en una secuencia imparable e infinita.

En el artículo de Physics Today, DeWitt (1970, p. 35) escribió que

«ningún experimento puede mostrar la existencia de “otros mundos”» y que

«sin embargo, la teoría tiene el mérito pedagógico de sacar a la

palestra muchos de los problemas fundamentales y proporcionar así una

base útil de discusión». Durante mucho tiempo (en los últimos años la

situación está cambiando), la idea de los multiuniversos fue poco

valorada, cuando no considerada poco menos que ridícula, pero quién sabe

si en el futuro será posible imaginar algún experimento que pueda

someter a prueba la idea de si existen otros universos. Y, puestos a

imaginar, si en ellos —en el caso de que existiesen— las leyes de la

física serían las que se cumplen en el Universo nuestro, o serían otras;

claro que si fuesen otras, ¿cómo identificarlas?

Materia oscura

Hasta finales del siglo XX se pensaba que, aunque quedase aún mucho

que averiguar sobre sus contenidos, estructura y dinámica, se sabía de

qué estaba compuesto el Universo: de materia «ordinaria», esa que

constantemente percibimos alrededor de nosotros, constituida a su vez

por las partículas (y radiaciones/cuantos) de las que se ocupa en

particular la física de altas energías. Pero resultó no ser así.

Diversas evidencias experimentales, como el movimiento interno de

algunas galaxias, mostraron que existe una materia de un tipo

desconocido, a la que se denomina «materia oscura»; y que también existe

una «energía oscura», responsable de que el Universo se expanda con

mayor aceleración de la esperada. Los resultados actuales indican que

alrededor del cinco por ciento del Universo está formado por masa

ordinaria, el 27 de materia oscura y el 68 por ciento de energía oscura.

En otras palabras: creíamos que conocíamos eso que llamamos Universo y

resulta que es un gran desconocido, porque no sabemos qué son ni la

materia oscura ni la energía oscura.

En el LHC se tenían esperanzas de detectar un candidato de partículas

de masa oscura, apodadas WIMP (siglas inglesas de Weakly Interacting

Massive Particles [Partículas masivas que interaccionan débilmente]),

cuya existencia predice la denominada «supersimetría», pero el resultado

ha sido negativo. Un experimento específico para intentar detectar

materia oscura utilizó un detector, LUX (Large Underground Xenon),

establecido en el Sanford Underground Laboratory, en el que participaron

alrededor de 100 científicos e ingenieros de 18 instituciones de

Estados Unidos, Europa y, en menor grado, otros países. Situado en una

mina de Dakota del Sur, a 1.510 metros de profundidad, ese detector

contenía 370 kilogramos de xenón líquido ultra puro, con el que se

pretendía detectar la interacción de las partículas que constituyen esa

materia oscura con el xenón. Sin embargo, también en este caso el

resultado de este experimento, iniciado en octubre de 2014 y concluido

en mayo de 2016, fue negativo.

Supersimetría y materia oscura

Desde el punto de vista de la teoría, existe un candidato de

formulación que puede acoger la materia oscura, las «partículas

oscuras», las mencionadas WIMP. Se trata de un tipo especial de

simetría, la «supersimetría», cuya característica más pronunciada es que

a cada partícula de las conocidas le corresponde una «compañera

supersimétrica». Ahora bien, esa compañera «supersimétrica» debe poseer

una propiedad específica: el espín de la partícula supersimétrica debe

ser ½ menor que el de su pareja conocida, es decir, el espín de una será

un número entero y el de la otra semientero, lo que significa que una

será un bosón (partículas con espín entero) y la otra un fermión

(partículas con espín semientero); en este sentido, la supersimetría

establece una simetría entre bosones y fermiones, imponiendo, por

consiguiente, que las leyes de la naturaleza sean las mismas

intercambiando bosones por fermiones, y viceversa. La supersimetría fue

descubierta a comienzos de la década de 1970, siendo una de sus primeras

manifestaciones dentro del contexto de otro tipo de teorías en las que

se han puesto muchas esperanzas para unificar las cuatro interacciones,

esto es, para incorporar la gravitación al mundo cuántico, lo que

significa ir más allá del Modelo estándar: la teoría de cuerdas.2 Un

buen resumen de lo que es la supersimetría lo ha proporcionado uno de

los físicos que se han distinguido por sus trabajos en este campo, David

Gross (2011, pp. 163-164):

Acaso la cuestión más importante a la que se enfrentan los

físicos de partículas, tanto teóricos como experimentales, sea la de la

supersimetría. La supersimetría es un maravilloso concepto teórico. Es

una extensión natural, probablemente única, de las simetrías

relativistas, especial y general, de la naturaleza. Es también una parte

esencial de la teoría de cuerdas; de hecho, la supersimetría se

descubrió en primer lugar en la teoría de cuerdas, siendo generalizada

después a la teoría cuántica de campos […]

En las teorías supersimétricas, para toda partícula existe un

«supercompañero», o «superpartícula» […] Hasta el momento no hemos

observado ninguna superpartícula […] Pero esto no es sorprendente. La

supersimetría podría ser una simetría exacta de las leyes de la

naturaleza, pero que se rompe espontáneamente en el nivel fundamental

del universo. Muchas simetrías que existen en la naturaleza se rompen

espontáneamente. Si la escala de la ruptura de la supersimetría es lo

suficientemente elevada, podríamos no haber visto todavía ninguna de

estas partículas. Si las observamos en el nuevo LHC entonces, de hecho,

descubriremos nuevas dimensiones cuánticas de espacio y tiempo.

La supersimetría posee muchos rasgos bellos. Unifica por medio de

principios de simetría fermiones, quarks y leptones (que son los

constituyentes de la materia), bosones (que son los cuantos de las

interacciones), el fotón, la W, la Z, los gluones de la cromodinámica

cuántica, y el gravitón.

Y después de ofrecer otros ejemplos de las virtudes de la

supersimetría, Gross se refería a la materia oscura: «Finalmente,

extensiones supersimétricas del Modelo estándar contienen candidatos

naturales para los WIMP de la materia oscura. Estas extensiones

contienen de forma natural, entre los compañeros supersimétricos de la

materia ordinaria, partículas que tienen todas las propiedades que se

han supuesto para la materia oscura».

Como apuntaba Gross, los experimentos en el LHC eran un buen

escenario para encontrar esos «compañeros supersimétricos oscuros», que

podrían ser lo suficientemente ligeros como para detectarse en el

acelerador del CERN, pero, incluso en este caso, estaría la dificultad

de detectarlos: ya que no interaccionan ni con la fuerza

electromagnética, por lo que no absorben, reflejan o emiten luz, ni con

la interacción fuerte; esto es, no interaccionan con las «partículas

visibles». Poseen, no obstante, energía y momento (si no, serían

«fantasmas» sin entidad física alguna), lo que constituye una puerta

abierta a que se infiera su existencia aplicando las leyes habituales de

conservación de energía-momento a lo que se ve después de una colisión

entre las partículas que se observan y las WIMP. Sin embargo y como

señalé, hasta el momento no se ha encontrado en el LHC ninguna evidencia

de su existencia. En cualquier caso, el problema de qué es la materia

oscura constituye un magnífico ejemplo de la confluencia entre física

(la física de partículas elementales), cosmología y astrofísica, una

muestra más de que a veces no es posible separar esos campos.

Teorías de cuerdas

Las teorías de cuerdas mencionadas a propósito de la supersimetría,

aparecieron antes que esta. Según la teoría de cuerdas, las partículas

básicas que existen en la naturaleza son en realidad filamentos

unidimensionales (cuerdas extremadamente delgadas) en espacios de muchas

más dimensiones que las tres espaciales y una temporal de las que somos

conscientes; aunque más que decir «son» o «están constituidas» por

tales cuerdas, habría que decir, que «son manifestaciones» de

vibraciones de esas cuerdas. En otras palabras, si nuestros instrumentos

fuesen suficientemente poderosos, lo que veríamos no serían «puntos»

con ciertas características a los que llamamos electrón, quark, fotón o

neutrino, por ejemplo, sino minúsculas cuerdas (cuyos cabos pueden estar

abiertos o cerrados) vibrando.

La primera versión de teoría de cuerdas surgió en 1968, cuando

Gabriele Veneziano (1968) introdujo un modelo de cuerda que parecía

describir la interacción entre partículas sujetas a la interacción

fuerte. El modelo de Veneziano servía únicamente para bosones; esto es,

se trataba de una teoría de cuerdas bosónicas. Exigía, eso sí, un marco

geométrico de 26 dimensiones. Fue Pierre Ramond (1971) quien, en el

trabajo citado en la nota 2

introdujo el concepto de supersimetría, logró la primera extensión de

la idea de Veneziano, de manera que incluyese también «modos de

vibración fermiónicos», que «únicamente» exige espacios de diez

dimensiones. Desde entonces, la teoría de cuerdas (o de supercuerdas),

ha experimentado numerosos desarrollos: existen versiones diferentes,

que parecen confluir en una teoría conocida como Teoría M, que posee 11

dimensiones.3 Sobre estas teorías, Stephen Hawking (2002, pp. 54-57) escribió en uno de sus libros, The Universe in a Nutshell:

Debo decir que, personalmente, me he resistido a creer en

dimensiones adicionales. Pero como soy un positivista, la pregunta

«¿existen realmente dimensiones adicionales?» no tiene ningún

significado para mí. Todo lo que podemos preguntar es si los modelos

matemáticos con dimensiones adicionales proporcionan una buena

descripción del universo. Todavía no contamos con ninguna observación

que requiera dimensiones adicionales para ser explicada. Sin embargo,

hay la posibilidad de que podamos observarlas en el Gran Colisionador de

Hadrones LHC de Ginebra. Pero lo que ha convencido a mucha gente,

incluido a mí, de que deberíamos tomarnos seriamente los modelos con

dimensiones adicionales es la existencia de una red de relaciones

inesperadas, llamadas dualidades, entre dichos modelos. Estas dualidades

demuestran que todos los modelos son esencialmente equivalentes; es

decir, son tan solo aspectos diferentes de una misma teoría subyacente

que ha sido llamada teoría M. No considerar esta red de dualidades como

una señal de que estamos en buen camino sería como creer que Dios puso

los fósiles en las rocas para engañar a Darwin sobre la evolución de la

vida.

De nuevo vemos cuantas esperanzas se depositaron en el LHC,

esperanzas, lo repito, que han resultado insatisfechas, lo que por

supuesto no quiere decir que alguna teoría de cuerdas, formulaciones

entre cuyas virtudes se encuentra la posibilidad de incluir la gravedad

en un contexto cuántico, no sea cierta.4

Desde luego, poseen un atractivo al que los legos en ciencia no han

sido, ni son, inmunes, como demuestra el éxito de libros de divulgación

como el citado de Hawking o el de otro experto en este campo, Brian

Greene (1999), The Elegant Universe. En la comunidad internacional de

físicos (y matemáticos) existen dos grupos claramente diferenciados. Por

un lado, los que piensan que solo en la teoría de cuerdas, en alguna de

sus versiones, se encuentra la posibilidad de cumplir el largamente

deseado sueño de unificar las cuatro interacciones en una gran síntesis

cuántica, yendo así más allá del Modelo estándar y de la relatividad

general, y que será posible encontrar formas de verificar

experimentalmente esa teoría. Y por otro lado, quienes creen que la

teoría de cuerdas recibe mucha más atención de la justificada, al ser

una, por el momento al menos, incomprobable formulación más propia de la

matemática que de la física (ciertamente, la matemática no solo ha dado

mucho a las teorías de cuerdas, sino que también ha recibido mucho; no

es casualidad, por ejemplo, que uno de los más destacados expertos en

teoría de cuerdas, Edward Witten, recibiera en 1990 una de las Medallas

Fields, el máximo reconocimiento para un matemático). Sobre cuál es el

futuro de la teoría de cuerdas, lo mejor es que cite la conclusión de un

libro reciente sobre ellas, debido a un físico especializado en ese

campo, Joseph Conlon (2016, pp. 235-236), profesor de Física Teórica en

la Universidad de Oxford:

¿Qué esconde el futuro para la teoría de cuerdas? Como ha

descrito este libro, en 2015 la «teoría de cuerdas» existe como un gran

número de separadas, cuasi-autónomas comunidades. Estas comunidades

trabajan en una variedad de temas que van desde la matemática pura a la

reunión fenomenológica de datos, y tienen diferentes estilos y emplean

diferentes enfoques. Están en todas partes del mundo. Se trabaja en el

tema en Filadelfia y en Pyonyang, en Israel y en Irán, por personas con

todo tipo de opiniones, apariencia y formación. Lo que tienen en común

es que extraen inspiración, ideas y técnicas de partes de la teoría de

cuerdas.

Está claro que a corto plazo esta situación continuará. Algunas

de esas comunidades florecerán y crecerán al ser revigorizadas con

nuevos resultados, ya sean experimentales o teóricos. Otras se reducirán

al agotar las vetas de las que se nutren. No soy capaz de decir qué

ideas sufrirán uno u otro destino: un resultado experimental puede

agotar viejos temas y crear nuevas comunidades en semanas.

Puedo decir con seguridad que como los resultados matemáticos son

eternos, el papel de la teoría de cuerdas en matemáticas nunca

desaparecerá. Puede reducirse o pasar de moda, pero siempre estará ahí.

La teoría de cuerdas es una estructura consistente de algo, y esa

estructura consistente conduce a una matemática interesante. Estas

partes de la matemática son verdaderas en el mismo indudable sentido que

el resto de la matemática es verdadero, y siempre lo serán

independientemente de lo que cualquier experimento pueda en el futuro

decir sobre las leyes de la física.

En este punto, Conlon se detenía para comparar la dimensión

matemática de la teoría de cuerdas con otras teorías de la física, como

la teoría cuántica de campos o la gravitación, señalando que «aunque

pueden ser acomodadas al lenguaje de la física, en estilo y problemas

están mucho más próximas a los problemas de la matemática. [Tratan] de

cuestiones cuya naturaleza no es empírica y que no necesitan del

experimento para que las respondamos». Ciertamente, es esta una

afirmación que muchos, seguramente la inmensa mayoría de los físicos, no

compartirán.

El ejemplo extraído de la teoría de cuerdas que Conlon presentaba a

continuación era la «Correspondencia AdS/CFT», una formulación teórica

publicada en 1998 por el físico argentino Juan Maldacena (1998) que,

bajo determinadas condiciones que satisfacen lo que se denomina

«principio holográfico» (el Universo entendido como una especie de

proyección holográfica), ayuda a establecer correspondencias entre

ciertas teorías de gravedad cuántica y cualquier teoría conforme de

campos, así como con la cromodinámica cuántica (en 2015, el artículo de

Maldacena era el más mencionado en la física de altas energías, con más

de 10.000 citas). «La validez de la correspondencia AdS/CFT», afirmaba

Conlon, «ha sido comprobada mil veces, pero la naturaleza de estas

pruebas es de cálculo y no tienen que ver con la experiencia». Y

continuaba:

¿Qué [tiene todo esto que decir] sobre este mundo? Es debido a la

sorprendente corrección y coherencia de ideas teóricas de las cuerdas,

como la AdS/CFT, que muchos piensan que la teoría de cuerdas también es

probablemente una teoría correcta de la naturaleza […]

¿Sabremos alguna vez si la teoría de cuerdas es correcta? ¿Son

válidas realmente las ecuaciones de la teoría de cuerdas para este

universo en las escalas más pequeñas posibles?

Todos los que alguna vez han tenido que ver con el tema, tienen

la esperanza de que algún día la teoría de cuerdas avance hacia los

terrenos más luminosos de la ciencia, en los que conjeturas y

refutaciones pugnan entre los teóricos y los experimentalistas como si

fueran pelotas de ping-pong. Esto puede exigir avances teóricos; puede

probablemente necesitar de avances tecnológicos; sin duda requiere de

trabajo duro e imaginación.

El futuro, en definitiva, continúa abierto para la gran esperanza de

una gran teoría que unifique la descripción de todas las interacciones y

que, al mismo tiempo, permita avanzar en el conocimiento de la

estructura más básica de la materia.

Entrelazamiento y criptografía

La mecánica cuántica, lo sabemos muy bien, desafía la imaginación

humana. Con dificultad, por la fuerza de los hechos (sus continuos

éxitos), nos terminamos acostumbrando, al menos la mayoría, a conceptos

como indeterminismo (principio de incertidumbre; Heisenberg, 1927) o

colapso de la función de ondas (que, como ya señalé, viene a decir que

creamos la realidad cuando realizamos observaciones; hasta entonces, esa

realidad no es sino el conjunto de todas las situaciones posibles),

pero resulta que todavía hay más. Otra de esas consecuencias

contraintuitivas de la física cuántica es el entrelazamiento, un

concepto y término (Verschränkung en alemán; entanglement en inglés)

introducido por Erwin Schrödinger en 1935 y vislumbrado también en el

célebre artículo que Einstein publicó ese mismo año junto a Boris

Podolsky y Nathan Rosen. Se trata de la propiedad de que dos partes de

un sistema cuántico están en «comunicación» instantánea, sin importar la

distancia que los separe, de manera que acciones sobre una parte tienen

correlaciones simultáneas en la otra, una propiedad a la que Einstein

se refirió en una carta a Max Born de 1947 como «acción a distancia

fantasmagórica [spukhafte Fernwirkung]».

Pues bien, el entrelazamiento cuántico existe. Y a lo largo de la

última década se han ido acumulando pruebas en este sentido. Una

demostración particularmente sólida la proporcionaron en 2015 tres

grupos de la Universidad de Delft, del National Institute of Standards

and Technology de Estados Unidos y de la Universidad de Viena. En el

artículo que publicaron (Herbst, Scheidl, Fink, Handsteiner, Wittmann,

Ursin y Zeilinger, 2015) demostraron el entrelazamiento de dos,

previamente independientes, fotones, separados 143 kilómetros, los

correspondientes a la distancia entre los detectores que utilizaron,

situados uno en la isla de La Palma y otro en Tenerife.

En la última década se han ido acumulando pruebas de que el entrelazamiento cuántico existe. Una demostración particularmente sólida la proporcionaron en 2015 tres grupos de la Universidad de Delft, del National Institute of Standards and Technology de Estados Unidos y de la Universidad de Viena

En un mundo como el actual, en el que las comunicaciones, vía

internet y otros medios, penetran y condicionan todos los resquicios

sociales, el entrelazamiento constituye un magnífico instrumento para

hacer seguras esas transmisiones, mediante lo que se conoce como

«criptografía cuántica». La base de este tipo de criptografía es un

sistema cuántico formado, por ejemplo, por dos fotones, cada uno de los

cuales se envía a un receptor diferente. Debido al entrelazamiento, si

en uno de esos receptores se efectúa un cambio, este repercute

instantáneamente, sin que exista vínculo entre ellos, en el otro. Y lo

que es particularmente relevante para la seguridad de la transmisión: si

alguien intenta intervenir en la comunicación, tendrá que hacer alguna

medida y esta destruirá el entrelazamiento, introduciendo anomalías en

el sistema que pueden ser detectadas.

Estrictamente, el intercambio cuántico de información se basa en lo

que se conoce como QKD (del inglés Quantum Key Distribution

[Distribución cuántica de claves]).5

Lo importante de este mecanismo es que se envía una clave cuántica que

recibe el receptor entrelazado, que la utiliza para descifrar un

mensaje: las dos partes del sistema comparten una clave secreta que

luego utilizan para cifrar y descifrar mensajes. Los métodos

tradicionales de encriptación se basan en algoritmos asociados a

operaciones matemáticas complejas, que son difíciles de descifrar, pero

desde luego no imposibles de interceptar, algo que sí es imposible, como

he señalado, en la criptografía cuántica.

El entrelazamiento cuántico anuncia la posible creación de una

«internet cuántica» global. No es, por consiguiente, sorprendente que

estén muy interesados en la criptografía cuántica que utiliza QKD

compañías de reciente creación como la suiza ID Quantique (se fundó en

2001 como una spin-off del Grupo de Física Aplicada de la Universidad de

Ginebra), la estadounidense MagiQ o la australiana QuintessenceLabs,

además de otras bien establecidas como HP, IBM, Mitsubishi, NEC, NTT y

Toshiba.

Un problema con la criptografía cuántica es que si utiliza canales de

comunicación clásicos, como la fibra óptica, la señal se debilita

debido a que los fotones son absorbidos o difundidos por las moléculas

de la fibra (el límite para enviar mensajes criptografiados

cuánticamente es del rango de una o dos ciudades). La transmisión

clásica sufre también este problema, que resuelve con repetidores, pero

esto no es posible con su paralelo cuántico debido al hecho ya señalado

de que una interacción intermedia destruye la unidad del mensaje. El

vacío espacial, no las fibras del tipo que sean, es el mejor «cable»

posible para la comunicación cuántica. Y se ha producido recientemente

un avance significativo en este sentido: un equipo dirigido por Jian-Wei

Pan, de la Universidad de Ciencia y Tecnología de China en Hefei, en

colaboración con el de Anton Zeilinger (uno de los mejores especialistas

en comunicación y computación cuánticas) en la Universidad de Viena,

consiguieron enviar mensajes cuánticos entre Xinglong y Graz —separadas

por una distancia de 7.600 kilómetros— utilizando como intermediario un

satélite chino, Micius, que fue puesto en órbita, a una altura de 500

kilómetros, en agosto de 2016.6

Para ampliar su rango de acción, se utilizaron sistemas de fibra óptica

que unían Graz con Viena, y Xinglong con Pekín; de esta manera, se

estableció una videoconferencia segura entre las Academias de Ciencias

China y de Viena que duró 75 minutos y exigió dos gigabytes de datos,

una capacidad similar a la que empleaban los teléfonos celulares en la

década de 1970. Semejantes logros preludian el establecimiento de redes

de satélites que permitirán comunicaciones seguras de todo tipo

(llamadas telefónicas, correos electrónicos, faxes). Un mundo nuevo, en

definitiva, al que más tarde se unirá también otro instrumento

relacionado íntimamente con los fenómenos cuánticos mencionados, la

computación cuántica, en la que el principio de superposición cuántico

desempeña un papel central.

El entrelazamiento cuántico anuncia la posible creación de una «internet cuántica» global, por lo que no es sorprendente que compañías como HP, IBM, Mitsubishi, NEC, NTT y Toshiba estén muy interesadas en la criptografía cuántica que utiliza QKD

Mientras que en la computación clásica la información se almacena en

bits (0, 1), en la cuántica la base son los qubits (quantum bits; cúbits

en castellano). Existen muchos sistemas físicos que pueden actuar como

cúbits; por ejemplo, fotones, electrones, átomos y pares de Cooper. El

principio de superposición cuántico mencionado significa que, si

pensamos por ejemplo en fotones, estos pueden estar polarizados

horizontal o verticalmente, pero también en alguna combinación entre

ambos estados. La consecuencia es que se tiene un número más grande de

unidades para procesar-almacenar en una máquina de computación, con las

que, además, es posible realizar varias operaciones a la vez, esto es,

operar en paralelo (todo bit tiene que ser bien 1 o 0, mientras que un

cúbit puede ser 1 o 0 al mismo tiempo, lo que permite realizar múltiples

operaciones a la vez). Evidentemente, cuanto mayor sea el número de

cúbits que se empleen, mayor será la capacidad de cálculo del

correspondiente computador cuántico: se cree que el número de cúbits

necesarios para superar a los computadores clásicos es 50, un umbral que

hace poco IBM ha anunciado ha superado… pero solamente durante unos

pocos nanosegundos. Y es que un gran problema es mantener los cúbits

entrelazados (esto es, no perturbados) durante un tiempo suficiente,

algo muy complicado debido a que las partículas subatómicas son

inherentemente inestables. Es por esto, para evitar lo que se denomina

«decoherencia», que entre los principales campos de investigación en la

computación cuántica se encuentre la búsqueda de desarrollar modos de

minimizar los efectos perturbadores de la luz, sonido, movimiento o

temperatura, lo que hace que muchos computadores cuánticos se construyan

dentro de cámaras de vacío a muy bajas temperaturas. Queda todavía

mucho por hacer, pero por razones obvias empresas y gobiernos (a la

cabeza de estos en la actualidad China) se esfuerzan en avanzar en el

campo de la computación cuántica: Google y NASA, por ejemplo, están

utilizando una computadora cuántica fabricada por una empresa

canadiense, D-Wave Systems, Inc, la primera en comercializar este tipo

de máquinas, que puede realizar algunos tipos de operaciones a una

velocidad 3.600 veces superior a la del supercomputador digital más

rápido del mundo.

Otra posibilidad asociada al entrelazamiento cuántico es el del

teletransporte, que, según la definición de Ignacio Cirac (2011, p.

478), consiste en «la transferencia de un estado cuántico intacto de un

lugar a otro, realizada por un remitente que no conoce ni el estado a

ser teletransportado ni la localización del receptor al que debe

llegar». Se han realizado ya experimentos de teletransporte con fotones,

iones y átomos, pero aún queda un largo camino por recorrer.

La física en un mundo interdisciplinar

En las secciones precedentes me he

ocupado de desarrollos que han tenido lugar en lo que podríamos

denominar «física más fundamental», pero la física no se limita, en modo

alguno, al estudio de los componentes «últimos» (?) de la naturaleza,

de la unificación de las fuerzas, o de las aplicaciones de los

principios más básicos de la física cuántica. La física está constituida

por un amplio y variado conjunto de campos —materia condensada, bajas

temperaturas, nuclear, óptica, electromagnetismo, fluidos,

termodinámica…—, y en todas ellas se ha continuado avanzando en la

última década, avances que, sin duda, proseguirán en el futuro. Sería

imposible referirme a todos, pero sí quiero señalar un campo al que la

física tiene mucho que aportar: la interdisciplinariedad.

La naturaleza, recordemos, es una y no conoce fronteras; somos

nosotros, por necesidades prácticas los que las hemos establecido,

creando disciplinas que llamamos física, química, biología, matemáticas,

geología, etcétera. Pero al ir avanzando en nuestro conocimiento de la

naturaleza, se hace cada vez más necesario ir más allá de esas

fronteras, unir disciplinas. Es imprescindible que se formen grupos de

especialistas —no necesariamente muy numerosos— en disciplinas

científicas y tecnológicas diferentes, que, provistos de los suficientes

conocimientos generales como para poder entenderse entre sí, colaboren

en resolver nuevos problemas, problemas que por su propia naturaleza

necesitan de esa colaboración. Y la física no puede faltar en esos

grupos. Encontramos manifestaciones de interdisciplinariedad en

prácticamente todos los ámbitos. En, por ejemplo, los procesos que

subyacen en los fenómenos atmosféricos, que involucran todo tipo de

ciencias: intercambios energéticos y gradientes de temperaturas,

radiación que se recibe del Sol, reacciones químicas, composición de la

atmósfera, desplazamiento de corrientes atmosféricas y marinas, biología

animal y de plantas para entender el comportamiento y reacciones de

especies animales y vegetales, procesos industriales, modos y mecanismos

sociales de transporte y un largo etcétera. La arquitectura y el

urbanismo nos proporcionan también evidencias en el mismo sentido. Para

el cambio climático, las limitaciones energéticas, la contaminación

atmosférica o la aglomeración en gigantescas urbes, es imperativo

ahondar en la colaboración entre arquitectura, urbanismo, ciencia y

técnica, sin olvidar que también habrá que tener en cuenta otras

disciplinas, como la psicología y la sociología, vinculadas al estudio

del carácter de los humanos. Debemos construir edificios que minimicen

las pérdidas de energía, procurando aproximarse a la autosuficiencia

energética, a la sostenibilidad, una de las palabras de moda en los

últimos años. Afortunadamente, junto a materiales con novedosas

propiedades térmicas y acústicas, disponemos de elementos, frutos

también de la ciencia y la tecnología, como paneles solares, y también

la posibilidad del reciclaje de desechos orgánicos.

Un ejemplo particularmente importante, en el que, además, la

presencia de la física es manifiesta, se encuentra el denominado

«Proyecto del Mapa de la Actividad Cerebral», que el entonces presidente

de Estados Unidos, Barack Obama, presentó públicamente el 2 de abril de

2013. Se trata de un proyecto de investigación —sucesor en más de un

aspecto del gran Proyecto Genoma Humano, que logró cartografiar los

genes que componen nuestros cromosomas— destinado a estudiar las señales

enviadas por las neuronas y a determinar cómo los flujos producidos por

esas señales a través de las redes neuronales se convierten en

pensamientos, sentimientos y acciones. De la importancia de este

proyecto, que se enfrenta a uno de los mayores retos de la ciencia

contemporánea, como es el comprender de manera global el cerebro humano,

y cómo este tiene conciencia de sí mismo, caben pocas dudas. Al

defenderlo, Obama mencionó su esperanza de que con él se abriría también

el camino para desarrollar tecnologías esenciales para combatir

enfermedades como el alzhéimer y el parkinson, al igual que para

establecer nuevas terapias para diversas enfermedades mentales, además

de servir de ayuda en el avance de la inteligencia artificial.

Basta con leer el encabezamiento del artículo en el que un grupo de

científicos presentaron y defendieron este proyecto para darse cuenta de

la naturaleza interdisciplinar del mismo y la presencia en él de la

física. Publicado en 2012 en la revista Neuron, el artículo se titula

«Proyecto de mapa de actividad cerebral y el reto de la conectómica

funcional» y está firmado por seis científicos: Paul Alivisatos, Miyoung

Chun, George Church, Ralph Greenspan, Michael Roukes y Rafael Yuste

(2012). Los propios lugares de trabajo de estos autores revelan la

naturaleza plural del proyecto: División de Ciencia de Materiales y