Inteligencia artificial de beneficios probados

¿Deberían preocuparnos los riesgos a largo plazo de la

inteligencia artificial superinteligente? En caso afirmativo, ¿qué

podemos hacer al respecto? Aunque parte de la comunidad mayoritaria de

la inteligencia artificial ignora estas preocupaciones, yo argumentaré

que es necesaria una reorientación fundamental del campo. En lugar de

construir sistemas que optimicen objetivos arbitrarios, necesitamos

aprender a construir sistemas que nos resulten probadamente

beneficiosos. Demostraré la utilidad de dotar a los sistemas de

incertidumbre explícita referida respecto a los objetivos de los humanos

a los que tienen que ayudar, pues para ello han sido diseñados.

El objetivo

de la investigación en inteligencia artificial (IA) ha sido comprender

los principios que subyacen en el comportamiento inteligente y

aplicarlos a la construcción de máquinas capaces de presentar dicho

comportamiento. En los 50 años de vida de la disciplina se han buscado

distintas definiciones de «inteligente», incluida la emulación del

comportamiento humano y la capacidad de razonamiento lógico. En décadas

recientes, sin embargo, ha surgido un consenso en torno a la idea de un

agente racional que percibe y actúa para alcanzar sus objetivos al

máximo. Subcampos como la robótica y el procesamiento de lenguajes

naturales pueden entenderse como casos especiales del paradigma general.

La IA ha incorporado la teoría de la probabilidad a la gestión de la

incertidumbre, la teoría de la utilidad para definir objetivos y el

aprendizaje estadístico para ayudar a las máquinas a adaptarse a

circunstancias nuevas. Estos progresos han creado fuertes vínculos con

otras disciplinas que aplican conceptos similares, incluidas la teoría

del control, la economía, la investigación de operaciones y la

estadística.

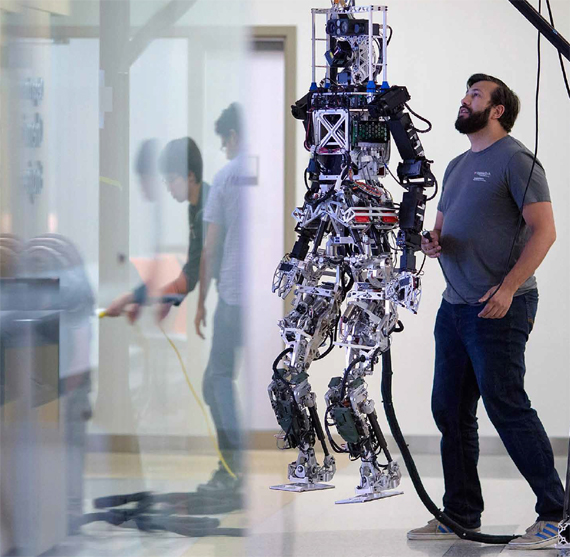

Los progresos en IA parecen

acelerarse. En los últimos años, debido en parte a los avances en el

aprendizaje de las máquinas, tareas como el reconocimiento de voz, la

identificación de objetos, la locomoción bípeda y la conducción autónoma

se han resuelto en gran medida. Cada nueva destreza alcanzada trae

consigo nuevos mercados potenciales y nuevos incentivos para seguir

invirtiendo en investigación, lo que conduce a un ciclo virtuoso que

impulsa la IA. En la próxima década es probable que asistamos a

progresos sustanciales en comprensión efectiva del lenguaje, lo que

conducirá a sistemas capaces de ingerir, sintetizar y contestar

preguntas sobre la suma total del conocimiento humano.

A pesar de todos estos avances,

seguimos lejos de la IA a nivel humano. Por ejemplo, no disponemos de

métodos prácticos para inventar conceptos útiles como «electrón» o

nuevas acciones útiles de alto nivel como «preparar diapositivas para la

clase de mañana». Esta última destreza es especialmente importante para

sistemas que operan en el mundo real, donde los objetivos que importan

pueden requerir miles de millones de acciones básicas de control motor.

Sin la capacidad de concebir ni razonar sobre acciones nuevas de alto

nivel, son imposibles la planificación y la actuación en las escalas

temporales que se manejan. Sin duda son necesarios más avances que no

sabremos describir hasta que nuestros esfuerzos por construir sistemas

IA polivalentes fracasen de maneras interesantes. La dificultad de

predecir estos avances implica que dar una estimación precisa de la

fecha en la que la IA alcanzará el nivel humano es imprudente. Sin

embargo, la mayoría de expertos cree que es probable que ocurra en el

presente siglo (Müller y Bostrom 2016; Etzioni 2016).

Es difícil exagerar la importancia

de un acontecimiento así. Todo lo que ofrece nuestra civilización es

consecuencia de la inteligencia; por tanto, el acceso a una inteligencia

sustancialmente mayor supondría una discontinuidad en la historia de la

humanidad. Podría conducir a soluciones de problemas como la

enfermedad, la guerra y la pobreza; al mismo tiempo, varios observadores

han señalado que los sistemas de IA superinteligentes pueden, por su

propia naturaleza, tener impactos a escala global que podrían ser

negativos para la humanidad de no estar bien diseñados.(1) La clave está

en definir el problema que nuestros sistemas de IA tienen que resolver,

para que podamos garantizar nuestra satisfacción con los resultados. Y

lo que nos jugamos es mucho.

Riesgos y refutaciones

Las preocupaciones

que suscita la IA superinteligente no son algo nuevo. Turing mismo, en

una comunicación por radio de 1951, sintió la necesidad de apuntar la

siguiente posibilidad: «Si una máquina puede pensar, es posible que

piense de manera más inteligente que nosotros, y entonces ¿dónde nos

coloca eso? Incluso si pudiéramos relegar a las máquinas a una posición

de servidumbre, por ejemplo desenchufándolas en momentos estratégicos,

deberíamos, como especie, extraer una lección de humildad […] Este nuevo

peligro […] es, sin duda, algo que puede causarnos preocupación».

Irving. J. Good (1965), que había trabajado con Turing durante la

Segunda Guerra Mundial, fue más allá y apuntó la posibilidad de sistemas

de IA que se automejoran. «Habría entonces, indudablemente, una

“explosión de inteligencia”, y la inteligencia del hombre quedaría muy

atrás.» El problema del control de la IA, por tanto, es cómo asegurarse

de que los sistemas con un grado arbitrariamente alto de inteligencia

permanecen bajo estricto dominio humano.

Parece razonable

ser cauteloso a la hora de crear algo mucho más inteligente que nosotros

mismos; sin embargo, necesitamos algo más que una sensación de

inquietud generalizada para reconducir de manera correcta la despiadada

presión científica y económica a la hora de construir sistemas cada vez

más capaces. Muchas novelas y películas han trasladado esta inquietud a

escenarios de máquinas conscientes espontáneamente malvadas, algo que es

muy improbable y, como fenómeno técnico a evitar, imposible de abordar.

De hecho, en la medida en que comprendemos el problema, la fuente de

dificultades más probable parece ser un fracaso en el alineamiento de

valores; a saber, que es posible que, sin darnos cuenta, dotemos a las

máquinas de objetivos que no se alinean correctamente con los nuestros.

Norbert Wiener (1960) lo expresó así: «Si usamos para nuestros fines una

agencia mecánica en cuyo funcionamiento no podemos interferir de manera

efectiva […] debemos asegurarnos de que el propósito que damos a la

máquina es el que de verdad deseamos».

Por desgracia, ni la IA

ni otras disciplinas construidas alrededor de la optimización de

objetivos (economía, estadística, teoría del control e investigación de

operaciones) tienen gran cosa que decir sobre cómo identificar los

propósitos que de verdad deseamos. En lugar de ello, asumen que los

objetivos son simplemente implantados en la máquina. La IA estudia la

capacidad de conseguir objetivos, no el diseño de estos. Y, como

descubrió el rey Midas, conseguir lo que uno desea no siempre es bueno.

Nick Bostrom (2014)

expone varios argumentos adicionales que sugieren que el problema no

tiene soluciones fáciles. El más relevante para el análisis de este

artículo lo debemos a Omohundro (2008), quien observó que entidades

inteligentes tenderán a actuar de maneras que preserven su propia

existencia. Esta tendencia no tiene nada que ver con el instinto de

autoconservación ni otros conceptos biológicos; simplemente, una entidad

no puede lograr sus objetivos si está muerta. Esto significa que la ya

citada confianza de Turing en la posibilidad de apagar la máquina no

procede. Según la argumentación de Omohundro, una máquina

superinteligente se las arreglará para anular la opción de apagado. Así

pues, tenemos un horizonte de máquinas superinteligentes cuyas acciones

son (por definición) impredecibles por parte de meros humanos, cuyos

objetivos especificados de forma imperfecta e incompleta pueden entrar

en conflicto con los nuestros y cuya motivación para preservar su propia

existencia como vía para cumplir esos objetivos puede resultar

insuperable.

Estos argumentos han

despertado una serie de objeciones, en especial por parte de

investigadores de IA. Las objeciones son reflejo de una actitud

defensiva natural, unida tal vez a una falta de imaginación sobre lo que

podrían hacer las máquinas superinteligentes. Nadie parece dispuesto a

estudiar esto con detenimiento (si a simple vista alguna de las

objeciones se antoja absurda, puedo asegurar que las hay más absurdas

aún y que las omito para no avergonzar a sus autores). Varias de estas

objeciones figuran en el reciente Informe AI100 (Stone et al. 2016),

mientras que otras las hacen individuos que participan en paneles de

debate en congresos de IA:

«La inteligencia artificial a nivel

humano, es decir, similar a la humana, es imposible», se trata de una

afirmación chocante cuando la hacen investigadores de IA que, desde

tiempos de Turing, han tenido que rebatir aseveraciones similares por

parte de filósofos y matemáticos. La afirmación, que no está

fundamentada en argumentos ni en pruebas, parece admitir que si la IA

superinteligente fuera posible, supondría un riesgo significativo. Es

como si un conductor de autobús, con la humanidad entera como pasajeros,

dijera: «Sí, estoy conduciendo hacia un precipicio, pero confiad en mí,

¡nos quedaremos sin gasolina antes de llegar!». La afirmación también

supone una apuesta temeraria en contra del ingenio humano. En el pasado,

hemos hecho apuestas semejantes a estas y hemos perdido. El 11 de

septiembre de 1933, el famoso físico Ernest Rutherford afirmó, con gran

seguridad: «Quien espere obtener una fuente de energía de la

transformación de estos átomos es que está en la luna». El 12 de

septiembre de 1933, el físico Leó Szilárd inventó la reacción nuclear en

cadena inducida por neutrones. Unos años después, tras haber demostrado

esta reacción en su laboratorio, Szilárd escribió: «Desenchufamos todo y

nos fuimos a casa. Aquella noche tuve pocas dudas de que el mundo se

dirigía hacia el sufrimiento».

«Es demasiado pronto para

preocuparse por ello.» El momento de preocuparse por un problema

potencialmente serio para la humanidad no depende de cuándo se producirá

dicho problema, sino de cuánto tiempo se necesita para idear e

implementar una solución que lo evite. Por ejemplo, si tuviéramos que

detectar un asteroide de gran tamaño que se predice que va a colisionar

con la Tierra en 2066, ¿diríamos que es demasiado pronto para

preocuparnos? Y si consideramos los peligros catastróficos globales del

calentamiento humano que se cree que sobrevendrán a finales del presente

siglo, ¿es prematuro emprender acciones para prevenirlos? Al contrario,

puede ser demasiado tarde. La escala temporal pertinente para la IA a

nivel humano es menos predecible, pero en absoluto eso quiere decir que,

al igual que la fisión nuclear, pueda llegar bastante antes de lo

esperado.

«Es como preocuparse por la

superpoblación en Marte» es una variación interesante de la afirmación

«Es demasiado pronto para preocuparse» y que trae a la cabeza una

analogía especialmente pertinente: no solo se trata de un riesgo muy

futuro y de fácil gestión, también es extremadamente improbable que

intentemos trasladar a miles de millones de personas a Marte. Sin

embargo, la analogía es falsa. Ya estamos dedicando recursos científicos

y técnicos ingentes para crear sistemas de IA cada vez más capaces. Así

que un plan para trasladar la raza humana a Marte sin pensar antes en

lo que respiraríamos, beberíamos o comeríamos al llegar allí, sería una

analogía más adecuada.

«La IA a nivel humano no es una

realidad inminente, así que no debemos preocuparnos». Es otra variación

de «demasiado pronto para preocuparnos», pero que atribuye las

preocupaciones sobre el control de la IA a la falsa creencia de que la

IA superinteligente es inminente. Esa objeción sencillamente confunde

los motivos de preocupación, que no se basan en la inminencia. Por

ejemplo, Bostrom (2014), escribe: «En este libro no argumentamos en

ningún momento que estemos en el umbral de un importante avance en IA, o

que podamos predecir con ningún grado de precisión cuándo se producirá

dicho avance».

«Nosotros somos los expertos, los

que construimos los sistemas de IA; confiad en nosotros.» Esta objeción

suele ir acompañada de una crítica a quienes plantean preocupaciones,

acusándolos de ignorar la realidad de la IA. Aunque es cierto que

algunos de los personajes públicos que han expresado preocupaciones,

como Elon Musk, Stephen Hawking y Bill Gates, no son expertos en IA, sí

están familiarizados con el razonamiento científico y tecnológico. Y

sería difícil argumentar que Turing (1951), Good (1965), Wiener (1960) y

Minsky (1984) no están cualificados para hablar de IA.

«No sois más que luditas.» Musk,

Gates, Hawking y otros (incluido, al parecer, quien esto firma)

recibieron en 2015 el premio Ludita del año que concede la fundación

para la Información sobre Innovación en las Tecnologías. Una definición

de ludita que incluye a Turing, Wiener, Minsky, Musk y Gate, algunos de

los principales contribuyentes al progreso tecnológico de los siglos xx y

xxi resulta, cuando menos, peculiar. Además, el epíteto refleja una

comprensión del todo errónea de la naturaleza de las preocupaciones

planteadas y el propósito de hacerlas públicas. Es como si se acusara de

luditas a los ingenieros nucleares si plantearan la necesidad de

controlar la fisión. Algunos objetores también emplean el término

«antiAI», que viene a ser como llamar «antifísicos» a los ingenieros

nucleares. El propósito de comprender y prevenir los riesgos de la IA es

asegurar que podemos hacer reales los beneficios. Bostrom (2014), por

ejemplo, afirma que el éxito a la hora de controlar la IA dará lugar a

una «trayectoria civilizadora que conduzca a un uso solidario y jubiloso

de la parcela cósmica de la humanidad».

«Vuestras predicciones

apocalípticas no tienen en cuenta los beneficios potenciales de la IA.»

Si la IA no tuviera beneficios potenciales, no habría interés económico o

social por impulsar su investigación, y por tanto no existiría el

peligro de lograr una IA comparable a la humana. Esta objeción es como

acusar a los ingenieros nucleares que trabajan en contención de no tener

nunca en cuenta los beneficios potenciales de la electricidad barata.

El triste hecho es que los beneficios potenciales de la energía nuclear

no han conseguido materializarse, en gran medida, precisamente porque no

se prestó la atención debida a los riesgos de contención en Three Mile

Island y Chernóbil.

«No se puede controlar la

investigación.» En la actualidad nadie sugiere que pueda limitarse la

investigación sobre IA, solo que hay que prestar atención al problema de

prevenir consecuencias negativas de sistemas mal diseñados. Pero, si es

necesario, podemos controlar la investigación: no diseñamos

genéticamente seres humanos porque los biólogos moleculares decidieron,

en un taller celebrado en Asilomar en 1975, que sería una mala idea,

aunque «mejorar las reservas de humanos» era, desde varias décadas

antes, el objetivo de numerosos investigadores del campo de la biología.

«No conviene mencionar los riesgos, puede afectar la financiación.» Véanse energía nuclear, tabaco, calentamiento global.

Además de estas objeciones en el

campo de las políticas a seguir, hay otras que proponen soluciones

simples para evitar las consecuencias negativas de la IA

superinteligente.

«En lugar de introducir objetivos

en el sistema, dejar que elija los que quiera.» No está nada claro cómo

solucionaría esto el problema. Los criterios de acuerdo a los cuales un

sistema de IA elegiría sus propios objetivos pueden muy bien

considerarse metaobjetivos, y de nuevo nos enfrentamos al problema de

cómo asegurar que conducen a comportamientos consistentes con el

bienestar humano. Tenemos que rectificar el timón, no tirarlo por la

borda.

«Los humanos más inteligentes

tienden a tener objetivos más loables y altruistas, lo mismo ocurrirá

con las máquinas superinteligentes.» Más allá del hecho de que quienes

defienden este argumento se consideran más listos que la mayoría, hay,

de hecho, escasísimas pruebas de la validez de la premisa de este

argumento, y la premisa no proporciona apoyo ninguno a la conclusión.

«No os preocupéis, tendremos

equipos humanos-IA que trabajarán en colaboración.» Una mala alineación

de los valores impide trabajar en equipo, así que esta solución pasa por

contestar antes a la pregunta de cómo solucionar el problema central de

alineamiento de valores.

«No hay que incluir en la ecuación

objetivos humanos como la autoconservación.» Véase la reflexión sobre el

argumento de Omohundro anterior. Para un robot que sirve cafés, la

muerte no es algo malo en sí mismo. Pero sí algo a evitar, porque es

complicado servir café si estás muerto.

«No pasa nada, se apaga y ya está.» Como si una entidad superinteligente no fuera a contar con esa posibilidad.

Soluciones

Bostrom (2014)

considera un número de propuestas técnicas más serias para resolver el

problema de control de la IA. Algunos, bajo el encabezamiento de

«oráculo de IA», proponen encerrar las máquinas en una suerte de

cortafuegos y extraer de ellas trabajo útil tipo pregunta-respuesta,

pero sin permitirles jamás intervenir en el mundo real. (¡Por supuesto

que, esto implica renunciar a los robots superinteligentes!) Por

desgracia, es poco probable que algo así funcione, pues todavía no hemos

inventado un cortafuegos que actúe de manera segura contra simples

humanos, y mucho menos contra máquinas superinteligentes. Otros hablan

de restricciones probadamente aplicables al comportamiento, pero

diseñarlas es como intentar escribir una ley fiscal sin resquicios (¡con

evasores fiscales superinteligentes además!),

¿Podríamos, en lugar de ello,

abordar la advertencia de Wiener? ¿Podemos diseñar sistemas de IA cuyos

propósitos no entren en conflicto con los nuestros, de manera que

nuestra satisfacción con su manera de comportarse esté asegurada? No es

algo nada sencillo, pero puede ser factible si seguimos tres principios

centrales:

- El propósito de la máquina es maximizar la puesta en práctica de valores humanos. Más concretamente, no tiene un propósito propio ni un deseo innato de protegerse.

- La máquina tiene una incertidumbre inicial respecto a cuáles son esos valores humanos. Esto resulta más crucial y, en cierto modo, elude el problema de Wiener. La máquina puede aprender más sobre valores humanos sobre la marcha, claro, pero es posible que nunca alcance total certidumbre.

- Las máquinas pueden aprender sobre valores humanos observando las elecciones que hacemos los humanos.

Resulta que estos

tres principios, una vez incardinados en un marco matemático formal que

defina el problema que la IA está inherentemente obligada a resolver,

parecen permitir ciertos progresos en el problema de control de la IA.

En particular, al menos en casos simples, podemos definir una plantilla

para diseños de agentes probadamente beneficiosos bajo determinados

supuestos razonables (si no ciertos).

Aprendizaje de funciones de recompensa

Para explicar el

marco matemático, ser algo más precisos con la terminología ayuda. Según

Von Neumann y Morgenstern (1994), a cualquier agente racional puede

atribuírsele una función de utilidad U(s) que asigna un número real que

representa la deseabilidad de existir en un estado del mundo particular

cualquiera s. De modo equivalente, esta es la deseabilidad esperada de

las posibles secuencias de estado futuras que empiezan por s, asumiendo

que el agente actúa de forma óptima. (En investigación de operaciones,

esto a menudo se conoce por función de valor, un término que tiene un

significado distinto en economía.) Hay otra suposición posible de

preferencias estacionarias (Koopmans 1972), según la cual la

deseabilidad de una secuencia de estado cualquiera puede expresarse como

una suma (que probablemente decrece con el tiempo) de recompensas

inmediatas asociadas a cada estado de la secuencia. Por razones de

conveniencia, la función de recompensa R(s, a, s’) se define de manera

que sea la recompensa inmediata asociada a la transición del estado s al

estado s’ mediante la acción a. Por lo general, la función recompensa

proporciona una manera concisa de definir una tarea; por ejemplo, la

tarea de jugar al backgammon puede definirse especificando que la

recompensa sea = para todos los estados no terminales s’ y un número

entre -192 y +192 para transiciones a estados terminales (el valor

preciso dependerá del estado del cubo de doblar y de si el juego termina

de una manera normal, con gammon o con backgammon). La utilidad de un

estado de backgammon s, por otra parte, será en la mayoría de los casos

una función muy compleja de s, porque representa una expectativa de

secuencias de recompensa futuras respecto a todas los resultados

posibles de los dados que se produzcan durante lo que queda de partida.

Para una persona que está pasando un rato de disfrute en su jardín, las

recompensas de oler una rosa pueden ser positivas (siempre que no la

huela cien veces seguidas) y las de pincharse el dedo con las espinas

negativas, mientras que la utilidad de estar en el jardín en ese momento

dependerá de todas las recompensas futuras, y estas pueden variar

enormemente en función de si uno está a punto de casarse, de cumplir una

larga condena en la cárcel, etcétera.

En la medida en que sea posible

definir de manera concisa objetivos especificando funciones de

recompensa, el comportamiento puede explicarse de forma también concisa

infiriendo funciones de recompensa. Esta es la idea clave que subyace en

el llamado aprendizaje por refuerzo inverso (IRL, por sus siglas en

inglés; Russell 1998; Ng y Russell 2000). Un algoritmo IRL aprende una

función nueva observando el comportamiento de otro agente, del que se

asume que actúa en consonancia con dicha función. El IRL es la forma

secuencial de obtención de preferencias y está relacionado con el

cálculo estructural de PDM (procesos de decisión de Márkov, en

economía). Viendo a su dueño preparar café por la mañana, el robot

doméstico aprende algo sobre la deseabilidad de tomar café en

determinadas circunstancias, mientras que un robot de dueño inglés

aprenderá sobre la deseabilidad de tomar el té en cualquier ocasión.

Resolver problemas sencillos de control de IA

Cabría imaginar que

el IRL proporciona una solución sencilla al problema de alineamiento de

valores: el robot observa el comportamiento humano, aprende la función

de recompensa y se comporta de acuerdo a dicha función. Esta sencilla

idea presenta dos problemas. El primero es obvio: el comportamiento

humano (en especial por la mañana) a menudo transmite un deseo de tomar

café, y el robot puede aprender esto, pero ¡no queremos que el robot

quiera tomar café! Este defecto es fácil de solucionar; necesitamos

reformular el problema de alineamiento de valores de manera que el robot

siempre tenga el mismo objetivo de optimizar la recompensa para el

humano (el principio 1 expuesto anteriormente) y se vuelva más capaz de

hacerlo a medida que aprenda cuál es la función de recompensa humana.

El segundo problema es menos obvio y

menos fácil de solucionar. Al humano le interesa asegurar que el

alineamiento de valores se produzca de la forma más rápida y precisa

posible, de forma que el robot pueda ser útil al máximo y se eviten

errores potencialmente desastrosos. Sin embargo, actuar de forma óptima

en la adquisición de café limitando al robot a un papel pasivo puede no

ser la manera idónea de conseguir el alineamiento de valores. En lugar

de ello, el humano tal vez debería explicar los pasos necesarios para

preparar café, así como enseñar al robot dónde se guarda el café y qué

hacer si se deja demasiado tiempo la cafetera encendida, mientras que el

robot puede preguntar para qué sirve el botón de hacer espuma y probar a

preparar café bajo la supervisión de un humano, incluso si los primeros

resultados son imbebibles. Ninguna de estas posibilidades encaja en el

marco del IRL.

Si se extiende el aprendizaje

inverso por refuerzo de manera que incorpore como agentes tanto al robot

como al humano, entonces es posible formular y solucionar un problema

de alineamiento de valores, convirtiéndolo en un proceso de maximización

de recompensa cooperativo e interactivo (Hadfield-Menell et al. 2017a).

Más concretamente, un problema de aprendizaje inverso cooperativo por

refuerzo (CIRL, por sus siglas en inglés) es una partida para dos

jugadores con información parcial en la que el humano conoce la función

de recompensa(2) y el robot no, pero la recompensa del robot es idéntica

a la del humano. Por tanto, el CIRL encarna los tres principios

enunciados anteriormente. Las soluciones óptimas a este juego maximizan

la recompensa humana y pueden generar de forma natural instrucción

activa por parte del humano y aprendizaje activo por parte del robot.

En el marco del

CIRL, se puede formular y resolver el problema de desenchufar, es decir,

el problema de evitar que un robot inutilice su botón de apagado. (Así

Turing puede estar tranquilo.) Es seguro que un robot diseñado para

resolver el problema del CIRL quiere maximizar valores humanos, pero

también es seguro que no sabe con exactitud cuáles son. Ahora bien, el

robot se beneficia de hecho de que lo apaguen porque entiende que el

humano pulsará el interruptor para evitar que el robot haga alguna cosa

contraria a los valores humanos. Así, el robot tiene un incentivo

positivo para respetar el interruptor de apagado y este incentivo deriva

directamente de su incertidumbre respecto a los valores humanos.

Además, es posible demostrar que en algunos casos el robot es

probadamente beneficioso, a saber, la recompensa esperada por el humano

es mayor cuando hay un robot capaz de resolver problemas de CIRL con

independencia de cuál sea la función de recompensa real del humano

(Hadfield-Menell et al. 2017b).

El ejemplo del

interruptor de apagado sugiere algunas fórmulas para el diseño de

agentes controlables y nos proporciona al menos un caso de sistema de

beneficio probado. El enfoque general guarda cierta similitud con el

diseño de mecanismos de resolución de problemas en matemáticas, donde

uno trata de incentivar a otros agentes para que se comporten de maneras

que sean probadamente beneficiosas para el diseñador del mecanismo. La

diferencia fundamental es que aquí estamos construyendo a uno de los

agentes para que beneficie al otro.

El ejemplo de apagado funciona

debido al principio 2, es decir, que el robot debería tener

incertidumbre respecto a la verdadera función de recompensa del humano.

Por extraño que parezca, la incertidumbre respecto a la recompensa ha

sido ignorada casi por completo en IA, a pesar de que la incertidumbre

respecto al conocimiento del campo de acción y la interpretación de

sensores ha sido una preocupación central durante veinte años. La razón

puede ser que la incertidumbre respecto a la función de recompensa es

irrelevante en problemas de decisiones secuenciales estándar (procesos

de decisión de Márkov o MDP, MDP parcialmente observables o POMDP y

problemas de control óptimo), porque la política óptima con una función

de recompensa incierta es idéntica a la política óptima con una función

de recompensa definida equivalente al valor esperado de la función de

recompensa incierta. Sin embargo, esta equivalencia solo se mantiene

cuando el entorno no proporciona ulterior información sobre la verdadera

función de recompensa, que no es el caso de problemas de CIRL, donde

las acciones humanas revelan información sobre preferencias humanas.

Cuando el entorno sí puede proporcionar información adicional sobre la

función de recompensa, los agentes con incertidumbre respecto a esta

pueden presentar comportamientos que no podrían realizar sistemas de IA

tradicionales con funciones de recompensa fijas.

En este punto, el lector

familiarizado con el concepto de aprendizaje por refuerzo (RL, por sus

siglas en inglés) podría aducir que la «señal recompensa» que recibe el

agente RL después de cada transición estado-acción-estado sí proporciona

información sobre la verdadera función de recompensa, porque da el

valor real de R(s, a, s’) para la transición producida. Así pues,

¿podría el aprendizaje por refuerzo ordinario constituir una base para

el alineamiento de valores si el humano se limita a suministrar una

señal de recompensa directamente al robot? ¡Por fortuna no! En primer

lugar, el humano puede no ser capaz de cuantificar la recompensa de

forma precisa, ni siquiera para transiciones específicas ya

experimentadas. En segundo lugar, el modelo formal de RL asume que la

señal de recompensa le llega al agente de fuera del entorno; pero el

humano y el robot son parte del mismo entorno, y el robot puede

maximizar su recompensa modificando al humano de manera que le

proporcione en todo momento una señal de recompensa máxima. Lo

indeseable de este resultado, conocido como wireheading o estimulación

directa (Muehlhauser y Hibbard 2014), pone de manifiesto un error de

base en la formulación estándar del RL. El error es que el entorno no

puede proporcionar una recompensa real al agente; tan solo información

sobre la recompensa. Así, un humano que emite una «señal de recompensa»

al robot no le está dando una recompensa, sino proporcionándole pruebas

(probablemente ruidosas) de sus preferencias en forma de una acción que

selecciona un número. Esta nueva formulación evita claramente el

problema de wireheading porque el robot solo saldrá perdiendo si

modifica la fuente de información para enmascarar la señal subyacente. Y

si la formulación estipula que el robot tiene que maximizar la función

de recompensa original, entonces modificar al humano de manera que tenga

una función de recompensa nueva más sencilla de maximizar no le hace

ningún bien al robot.

Consideraciones prácticas

He argumentado que

el marco para el aprendizaje inverso por refuerzo puede ser el primer

paso para una resolución teórica del problema de control en IA. Hay

también razones para creer que el enfoque puede funcionar en la

práctica. En primer lugar, hay ingentes cantidades de información

escrita y filmada sobre humanos haciendo cosas (y otros humanos

reaccionando). La tecnología necesaria para construir modelos de valores

humanos a partir de estos archivos estará disponible mucho antes de que

se creen sistemas de IA superinteligentes. En segundo lugar, existen

incentivos muy poderosos y a corto plazo para que los robots entiendan

los valores humanos: si un robot doméstico mal diseñado cocina al gato

para cenar porque no entiende que su valor sentimental excede con mucho

su valor nutricional, el sector de los robots domésticos quebrará. En el

campo de los asistentes personales digitales, que probablemente se

convertirá en un mercado importante antes de que termine la década, un

asistente que se adapta con rapidez a las preferencias complejas y

llenas de matices de su dueño presenta beneficios obvios.

-

Un enfoque basado en el aprendizaje

de valores a partir del comportamiento humano, no obstante, plantea

problemas evidentes. Los humanos son irracionales, incoherentes,

pusilánimes y computacionalmente limitados, de manera que sus acciones

no siempre reflejan sus valores (pensemos, por ejemplo, en dos humanos

que juegan al ajedrez; por lo general uno de ellos pierde, ¡pero no

adrede!). Los humanos también son diversos en cuanto a valores y

circunstancias, lo que quiere decir que los robots deben ser receptivos a

las preferencias individuales y mediar en conflictos de preferencias,

un problema tanto para científicos sociales como para ingenieros. Y

algunos humanos son malvados, así que el robot debe poder ser capaz de

filtrar valores de sistemas individuales que sean incompatibles con el

bienestar general.

-

Parece probable que

los robots puedan aprender de comportamientos humanos no racionales solo

con la ayuda de modelos cognitivos de humanos muy mejorados. ¿Y qué

pasa con el comportamiento indeseable? ¿Es posible evitar corromper a

nuestros robots sin imponer limitaciones adquiridas (y que por tanto

varían según las culturas) a los valores que estamos dispuestos a

permitir? Tal vez se pueda usar una versión del imperativo categórico de

Kant, según la cual una función de recompensa que asignara valor

negligible o negativo al bienestar de los demás carecería de

autoconsistencia, en el sentido de que si todos operaran con dicha

función de recompensa, entonces ninguno la obtendría.

Síntesis

He argumentado,

siguiendo a numerosos autores, que encontrar una solución al problema de

control de la IA es una tarea importante. Más concretamente y en las

sonoras palabras de Bostrom, «la tarea esencial de nuestra época».

También he argumentado que, hasta el momento, la IA se ha centrado en

sistemas capaces de tomar mejor decisiones, pero que esto no es lo mismo

que tomar decisiones mejores. Por muy excelentemente que maximice un

algoritmo, y por muy preciso que sea su modelo del mundo, las decisiones

de una máquina pueden ser estúpidas a los ojos de un humano normal y

corriente si su función de utilidad no está bien alineada con los valores humanos.

Este problema exige cambiar la

definición misma de IA, que debe dejar de ser un campo que se ocupa de

la inteligencia pura, con independencia del objetivo, y ser uno que se

ocupe de sistemas probadamente beneficiosos para los humanos. (Supongo

que también podríamos diseñar sistemas de IA para otras especies, pero

no creo que sea una prioridad ahora mismo.) Tomarse en serio el problema

ha dado lugar a nuevas maneras de enfocar la IA, sus propósitos y

nuestra relación con ella

-.

Notas

1. Existen otros

posibles riesgos del uso indebido de una IA cada vez más potente,

incluidos la vigilancia automática y la persuasión, las armas autónomas y

la disrupción económica; deben ser estudiadas en profundidad, pero no

son el tema del presente artículo.

2. Cabría

preguntarse: ¿por qué un humano que conoce la función de recompensa no

se limita a programarla en el robot? Aquí usamos «saber» en el sentido

restringido de como si uno conociera la función de recompensa, sin ser

necesariamente capaz de hacerla explícita. Es como cuando un humano

«conoce» la diferencia de pronunciación entre la letra g en gente y en

guante sin ser capaz de poner por escrito la regla ortográfica.

-

Bibliografía

— Bostrom, N., Superintelligence, Oxford, Oxford University Press, 2014 [Ed. esp. Superinteligencia, Zaragoza, Teell, 2016].

— Etzioni, O., «Are the Experts Worried About the Existential Risk of Artificial Intelligence?», en MIT Technology Review, 2016.

— Good, I. J., «Speculations Concerning the First Ultraintelligent Machine», en Alt, F. L. y Rubinoff, M. (eds.), Advances in Computers 6, Nueva York, Academic Press, 1965.

— Hadfield-Menell, D., Dragan, A., Abbeel, P. y Russell, S., «Cooperative Inverse Reinforcement Learning», en Advances in Neural Information Processing Systems 25, Cambridge, Massachusetts, The MIT Press, 2017a.

—

Hadfield-Menell, D., Dragan, A., Abbeel, P. y Russell, S., «The

off-switch», en la 31ª Conferencia AAAI sobre Inteligencia Artificial

(AAAI-17), 2017b.

— Koopmans, T. C., «Representation of Preference Orderings over Time», en McGuire, C. B. y Radner, R. (eds.), Decision and Organization, Ámsterdam, Elsevier/North-Holland, 1972.

— Minsky, M., «Afterword to Vernor Vinge’s novel, “True Names”», manuscrito inédito, 1984.

— Muehlhauser, L. y Hibbard, B., «Exploratory Engineering in Artificial Intelligence», en Communications of the ACM, vol. 57, n.º 9, 2014, pp. 32-34.

—

Müller, V. C. y Bostrom, N., «Future Progress in Artificial

Intelligence: A Survey of Expert Opinion», en Müller, V. C. (ed.), Fundamental Issues of Artificial Intelligence, Berlín, Springer, Synthèse Library, vol. 376, 2016.

— Ng., A. Y. y Russell, S., «Algorithms for Inverse Reinforcement Learning», Actas de la XVII Conferencia Internacional sobre Aprendizaje Automático, Stanford, California, Morgan Kaufmann, 2000.

— Omohundro, S. M., «The Basic AI Drives», en Proceedings of the First AGI Conference, IOS Press, 2008.

— Russell, S., «Learning Agents for Uncertain Environments (extended abstract)», en Proc. COLT-98, Madison, Wisconsin, ACM Press, 1998.

— Stone, P. et al., «Artificial Intelligence and Life in 2030», en One Hundred Year Study on Artificial Intelligence, informe del Panel de Estudio 2015, Universidad de Stanford, septiembre de 2016.

— Turing, A. M., «Can digital Machines Think?», 1951. Conferencia retransmitida por la BBC, transcripción en inglés en turingarchive.org

— Von Neumann, J. y Morgenstern, O., Theory of Games and Economic Behavior, 1ª ed., Princenton, Princeton University Press, 1944.

— Wiener, N., «Some Moral and Technical Consequences of Automation», en Science, vol. 131, n.º 3.410, 1960, pp. 1.355-1.358.

Russell, S., "Inteligencia artificial de beneficios probados", en

El próximo paso. La vida exponencial, Madrid, BBVA, 2016.

https://www.bbvaopenmind.com/articulos/inteligencia-artificial-de-beneficios-probados/

No hay comentarios:

Publicar un comentario